发表时间:2018(ICLR 2018)

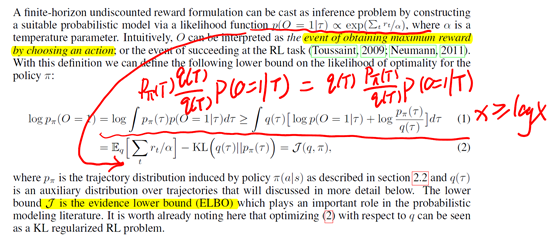

文章要点:从variational inference的角度引入了一种新的RL范式:最大化后验策略优化(MAXIMUM A POSTERIORI POLICY OPTIMISATION,MPO)。主要式子如上图,目标是使得获得最大reward的事件出现的概率最大,然后引入了一个新的策略q,放缩成了右边的目标函数J(evidence lower bound (ELBO))。有点贝叶斯方法的感觉,然后用EM的方式更新,E-step更新q来提升J,M-step更新π来提升J。这个范式把最大熵策略(引入KL constraint)和信頼域方法(可以看做parametric E-step)也囊括了进来,算是policy optimization方法和off-policy方法的混合。在连续控制上效果较好,Atari这样的离散问题上效果比SOTA差些。

总结:从inference的角度看RL方法,挺有意思的。后面好多MCTS的文章也被拿来从MPO的角度来解释和进一步改进,挺重要的思路。

疑问:证明没明白,还需要看看yidaxu的课再回过头来看一遍paper。

MAXIMUM A POSTERIORI POLICY OPTIMISATION (MPO)

原文:https://www.cnblogs.com/initial-h/p/15018229.html