对机器学习问题而言,数据和特征(包括获取先验知识所用到的数据和特征)决定了结果的上限,而模型、算法的选择和优化则是在逐步接近这个上限。

数值型特征归一化

为什么需要进行特征归一化?

特征归一化的方b法:

线性函数归一化(min-max scaling)

零均值归一化(z-score normalization)

什么时候会用到特征归一化?

类别型特征

组合特征

什么是组合特征?

如何有效的找到组合特征?

文本表示模型

文本表示模型有哪些?

词袋模型(Bag of Words):将整段文本以词为单位切分开,那么文本可以表示为一个长向量,向量中的每一维代表一个单词,该维对应的权重反映了词在文章中的重要程度。常用TF-IDF计算权重,

其中TF(t,d)为单词t在文档d中出现的频率,IDF(t)为逆文档频率,用来衡量单词t对表达语义所起的重要性

N-gram:单词拆分后的含义与组合起来的含义可能差别很大,可以将连续出现的n个词组成的词组(N-gram)作为一个单独的特征放到向量表示中,构成N-gram模型。

词干抽取(Word Stemming):同一词会有多种词性变化,却有相似的含义,可将不同词性的单词统一成为同一词干的形式。

主题模型(Topic Model):从文本库中发现有代表性的主题(得到每个主题上的词分布特性),并能够计算出每篇文章的主题分布。

词嵌入模型(Word Embedding):词嵌入是一类将词向量化的模型的统称,核心思想是将每个词映射为低维空间(50~300维)上的一个稠密向量(Dense Vector),空间中的每一维可以看作一个隐含的主题。

Word2Vec:一种常用的词嵌入模型,一种浅层的神经网络结构,由CBOW(Continues Bags of Words)和Skip-gram两部分组成。CBOW根据上下文出现的词语预测当前词的出现概率,skip-gram根据当前词预测上下文词的生成概率。

隐迪利克雷模型(LDA)

图像不足时的处理方法

评估方法

阶段划分:离线评估、在线评估

常用指标

准确率(Accuracy):值分类正确的样本占样本个数的比例

缺陷:当数据不均衡时,占比大的数据会成为影响准确率的最主要因素。(比如负样本99%,所有样本都预测为负样本也可以获得99%的准确率)

解决方法:是用平均准确率(各类别下的样本准确率的算术平均)

精确率(Precision):分类正确的正样本个数占分类器判定为正样本的样本个数的比例

召回率(Recall):分类正确的正样本个数占真正的正样本个数的比例

均方根误差(Root Mean Square Error, RMSE)

高维特征所带来的问题:

相比于全连接网络,卷积神经网络和循环神经网络的优势:

模型结果较差的思考角度:

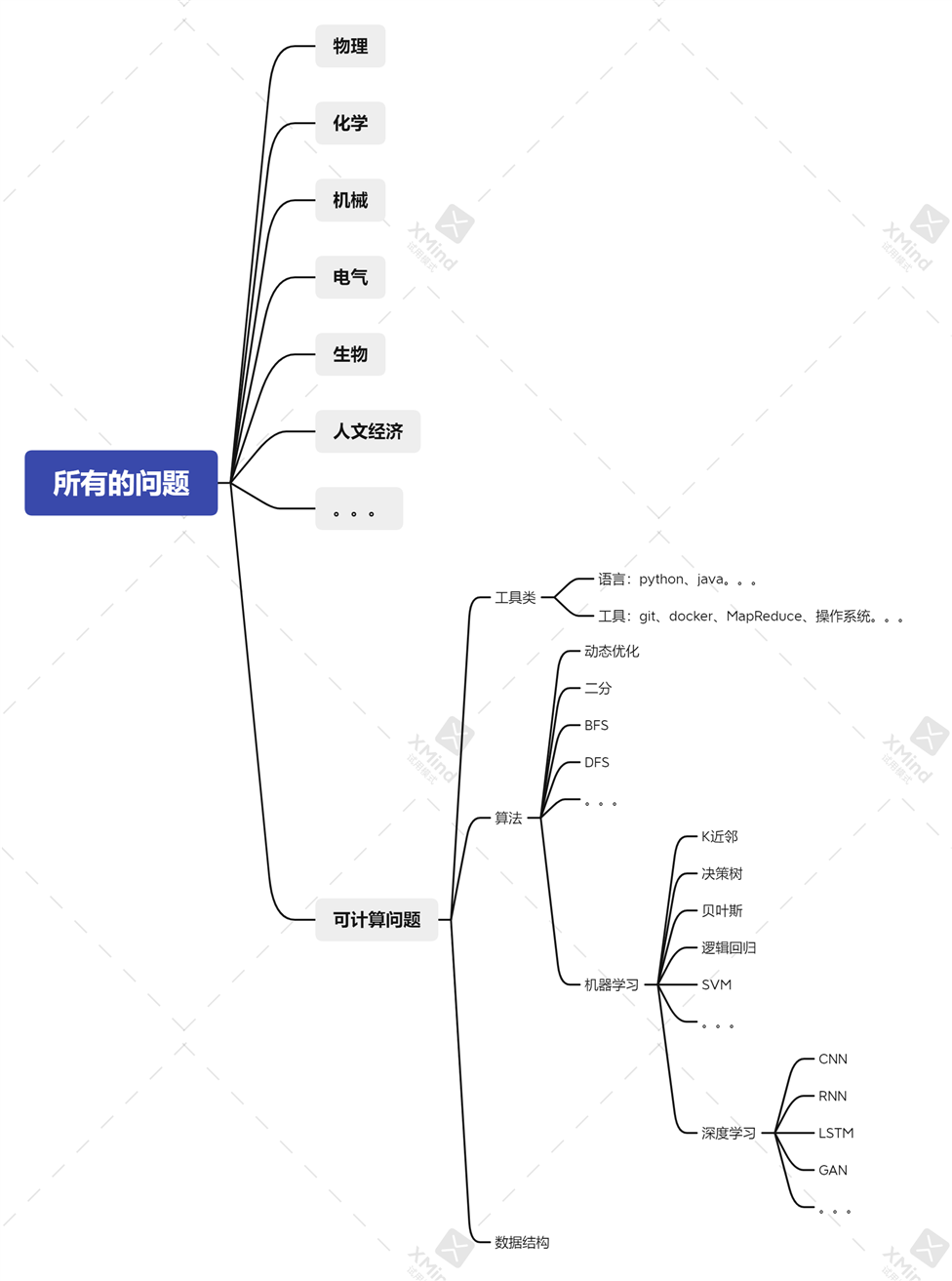

该图并不严谨,但我只想说:无论何时都应保持谦逊,更要努力扩宽自己、切莫封闭,你所会的只是三千弱水中的一瓢,世界很大。

原文:https://www.cnblogs.com/tensorzhang/p/14901693.html