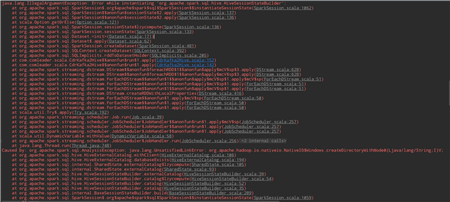

## 错误:

## 解决方案:

下载 hadoop 的可执行tar包,解压放在windows 本地,并配置环境变量。 在 解压后的文件夹的bin目录下放入两个文件: winutils.exe, hadoop.dll

## windows 上hadoop 工具的获取:https://github.com/steveloughran/winutils/tree/master/hadoop-2.6.4/bin (或者自行百度一下)

原文:https://www.cnblogs.com/nulijiushimeili/p/14147751.html