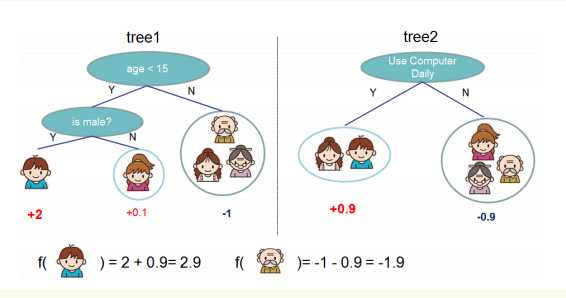

先来举个例子,我们要预测一家人对电子游戏的喜好程度,逐一给各人在电子游戏喜好程度上打分,如下图所示。

训练出了2棵树tree1和tree2,类似之前gbdt的原理,两棵树的结论累加起来便是最终的结论

所以小孩的预测分数就是两棵树中小孩所落到的结点的分数相加:2 + 0.9 = 2.9。爷爷的预测分数同理:-1 + (-0.9)= -1.9。

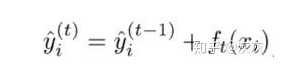

新生成的树是要你和上次预测的残差的,即当生成t棵树后,预测可以分可以写成:

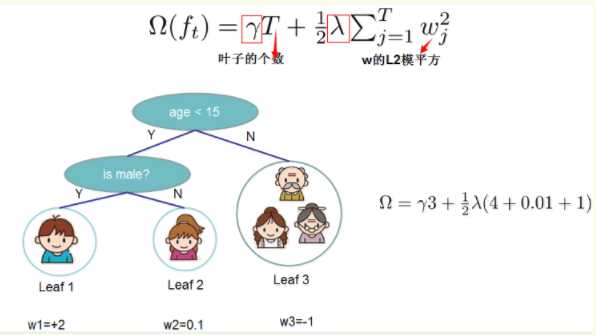

XGBoost对树的复杂度包含了两个部分:

树里面叶子节点的个数T

树上叶子节点的得分w的L2模平方(对w进行L2正则化,相当于针对每个叶结点的得分增加L2平滑,目的是为了避免过拟合)

原文:https://www.cnblogs.com/hapyygril/p/13711768.html