应用:语音问答、股票预测、作词机、模仿写论文、模仿写代码。

循环神经网络与卷积神经网络对比:

卷积神经网络主要用于分类和检索。

两者之间的不同:传统的输入输出是相互独立的,而RNN可以考虑上下文的时序关系,不仅依赖于输入,还依赖于记忆

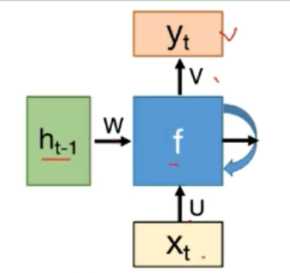

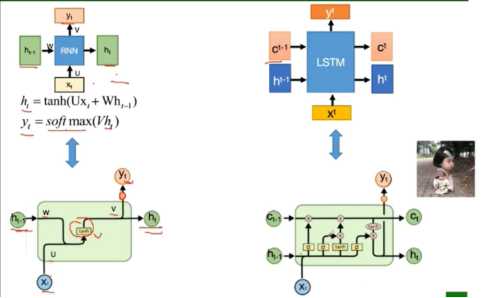

循环神经网络的基本结构:

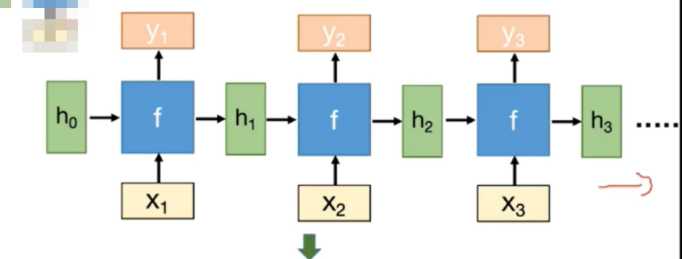

展开 以后是:

展开 以后是:

三块参数:U从输入到隐藏状态,W从前一隐藏层状态到下一个隐藏状态,V从隐藏状态到输出。Xt是时间t处的输入,ht是时间t处的记忆。

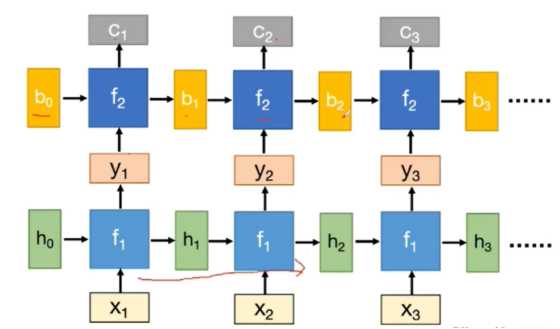

深度RNN:

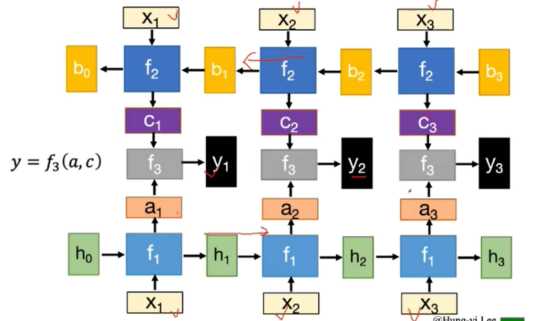

双向RNN:双向RNN结合时间上从序列起点开始移动的RNN和另一个时间上从序列末尾开始移动的RNN。

传统RNN的问题:

当循环神经网络在时间维度上非常深的时候,会导致梯度消失或者梯度消失。导致模型训练不稳定,梯度为无效数字或者无穷大 的值。

改进:

梯度爆炸:权重衰减(权重加上一个值);梯度截断(梯度高于或者低于阈值时,使梯度等于该阈值)

梯度消失:改进模型;LSTM;GRU

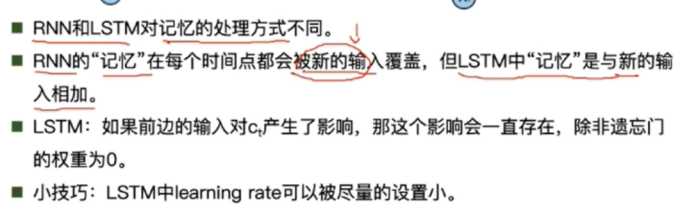

LSTM:长短时记忆

拥有三个门:遗忘门,输入门,输出门。

遗忘门:决定丢弃信息,就是一个sigmoid函数,输出在0-1之间,根据ft的值决定是否通过。

输入门:首先经过sigmoid层决定什么信息需要更新,然后通过tanh层输出备选的需要更新的内容,然后加入新的状态中。

输出门:首先通过sigmoid来确定细胞状态的哪个部分将输出出去。然后通过tanh进行处理并将结果与sigmoid输出的结果相乘,然后根据结果决定是否输出。初始值一般为1或5

如何解决梯度消失的:

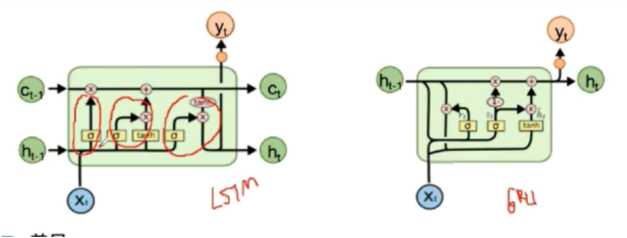

GRU来简化了LSTM的计算:

只有两个门:重置门,更新门

原文:https://www.cnblogs.com/jiangym1998/p/13542438.html