线性回归:w1x1+w2x2+w3x3+......+wnxn+bias(这是一个偏移量),我们采用的算法是:线性回归,策略是:均方误差,优化是:梯度下降API,

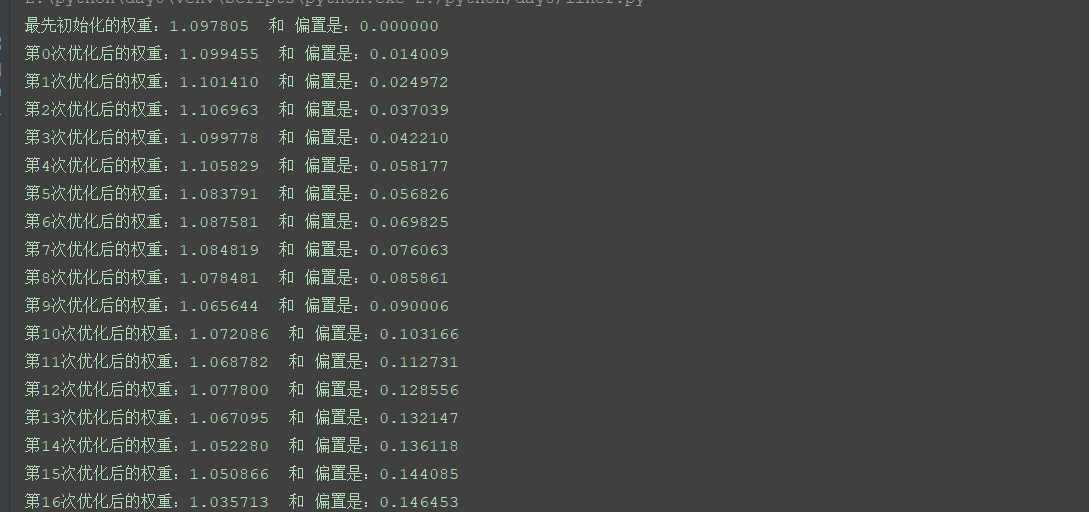

1.转准备好实验的数据:100个数据,每一个有一个特征值,所以形成一个【100,1】的列表,在准备一个目标函数:y=0.8x+0.7那么怎么知道为什么是0.8和0.7呢,这是我们假设的

2.建立一个模型,需要我们随机生成两个参数,一个是权重w一个是偏置b , y_predict = x * w + b,需要注意的是这个模型的参数必须要用变量来定义

3.求损失误差,我们求的是均方误差,公式是:((y1-y1‘)^2+(y2-y2‘)^2+.......+(y100-y100‘)^2)/100

4.接下来就是利用梯度下降来优化误差,这个梯度下降是tensorflow里边自己实现的,我们只需要指定一个学习率就行了

Tensorflow运算的API

矩阵运算:tf.matmul(x,w)

平方运算:tf.square(参数1)

均值运算:tf.reduce_mean(参数1)

梯度下降API: tf.train.GradientDescentOptimizer(learning_rate);这是一个梯度下降优化器,learn_rate一般是method:minimize(loss),返回一个梯度下降的op

import tensorflow as tf import os os.environ[‘TF_CPP_MIN_LOG_LEVEL‘] = ‘2‘#把报错的这个警告等级降低 def myLineregression(): #1.准备数据,x是100行1列的矩阵,y是一个目标值,100行 x = tf.random_normal([100,1],mean = 1.75,stddev=0.5,name="x_data") y_true = tf.matmul(x,[[0.7]]) + 0.8 #其中这个0.7和0.8是不知道的,在这里我们假设我们知道了 #2.建立回归模型,1个特征值x 1个权重weight,一个偏置bias,组成:y = x*weight + bias,这里一定是变量 #随机给一个权重和偏置,让他接下来去计算误差函数,然后再去优化,但是前提是必须是变量才能优化 weigth = tf.Variable(tf.random_normal([1,1],mean=0.0,stddev=1.0),name=‘w‘)#即使是一个数也要表示成矩阵,一行一列表示一个矩阵 bias = tf.Variable(0.0,name=‘b‘) y_predict = tf.matmul(x,weigth) + bias; #3建立损失函数 loss = tf.reduce_mean(tf.square(y_true - y_predict)) #4.梯度下降优化损失,learning_rate一般是在0~10,越小越好通常是,最大不要超过10,然后通过minimize()来优化误差函数loss train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss) #接下来就要通过会话来运行实现了,但在这之前需要初始化变量的op init_op = tf.global_variables_initializer() with tf.Session() as sess: #初始化变量 sess.run(init_op) #打印最先初始化的权重个偏置 print("最先初始化的权重:%f 和 偏置是:%f" %(weigth.eval(),bias.eval()))#最先初始化的权重:-0.475077 和 偏置是:0.000000 # #运行优化,这只是训练一次的结果:优化后的权重:0.635607 和 偏置是:0.581311 # sess.run(train_op) #循环训练,运行优化,优化1000次,越多越精确,越接近我们的假设值 for i in range(1000): sess.run(train_op) #打印优化后的权重和偏置 print("第%d次优化后的权重:%f 和 偏置是:%f" % (i,weigth.eval(), bias.eval())) return None if __name__ == "__main__": myLineregression()

.......

那么你可能有一个疑问,为什么weight和bias会一直变化呢,因为他两是tf.Variable类型的,在Variable()最后一个参数是trainable默认是True,如果你指定他是False的话,weight和bias就不会随着我们梯度变化来变化了

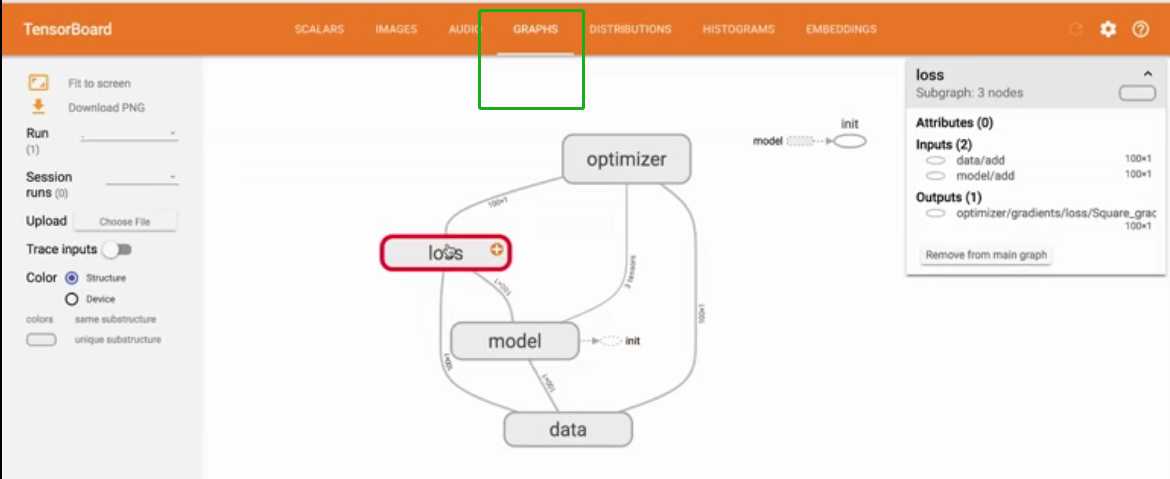

我们接下来用变量作用域来实现一下:这样的作用有两个:第一:使得我们的代码更加爽目;第二:使得我们后台显示很流畅,否则可能会有点凌乱

import tensorflow as tf import os os.environ[‘TF_CPP_MIN_LOG_LEVEL‘] = ‘2‘#把报错的这个警告等级降低 def myLineregression(): with tf.variable_scope("data"): #1.准备数据,x是100行1列的矩阵,y是一个目标值,100行 x = tf.random_normal([100,1],mean = 1.75,stddev=0.5,name="x_data") y_true = tf.matmul(x,[[0.7]]) + 0.8 #其中这个0.7和0.8是不知道的,在这里我们假设我们知道了 with tf.variable_scope("model"): #2.建立回归模型,1个特征值x 1个权重weight,一个偏置bias,组成:y = x*weight + bias,这里一定是变量 #随机给一个权重和偏置,让他接下来去计算误差函数,然后再去优化,但是前提是必须是变量才能优化 weigth = tf.Variable(tf.random_normal([1,1],mean=0.0,stddev=1.0),name=‘w‘)#即使是一个数也要表示成矩阵,一行一列表示一个矩阵 bias = tf.Variable(0.0,name=‘b‘) y_predict = tf.matmul(x,weigth) + bias; with tf.variable_scope("loss"): #3建立损失函数 loss = tf.reduce_mean(tf.square(y_true - y_predict)) with tf.variable_scope("Optimizer"): #4.梯度下降优化损失,learning_rate一般是在0~10,越小越好通常是,最大不要超过10,然后通过minimize()来优化误差函数loss train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss) #接下来就要通过会话来运行实现了,但在这之前需要初始化变量的op init_op = tf.global_variables_initializer() with tf.Session() as sess: #在后台可视化观察图结构 fileWrite = tf.summary.FileWriter("E:/python/day8/temp/summary/text/",graph=sess.graph) #接下来在终端运行tensorboard --logdir="E:/python/day8/temp/summary/text/",就会产生一个网址,在浏览器打开即可 #初始化变量 sess.run(init_op) #打印最先初始化的权重个偏置 print("最先初始化的权重:%f 和 偏置是:%f" %(weigth.eval(),bias.eval()))#最先初始化的权重:-0.475077 和 偏置是:0.000000 # #运行优化,这只是训练一次的结果:优化后的权重:0.635607 和 偏置是:0.581311 # sess.run(train_op) #循环训练,运行优化 for i in range(1000): sess.run(train_op) #打印优化后的权重和偏置 print("第%d次优化后的权重:%f 和 偏置是:%f" % (i,weigth.eval(), bias.eval())) return None if __name__ == "__main__": myLineregression()

后台样式:

python深度学习-tensorflow实现一个线性回归的案例

原文:https://www.cnblogs.com/boost/p/13499900.html