类似的, 是large margin的思想, 亮点是多层?

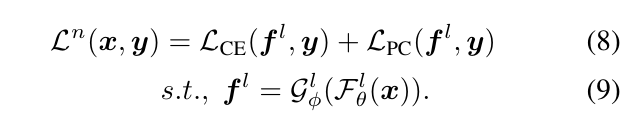

以下, \(f^l\)表示第\(l\)层的输入, \(f\)为最后一层的输入.

一般的网络只有\(\mathcal{L}_{CE}\):

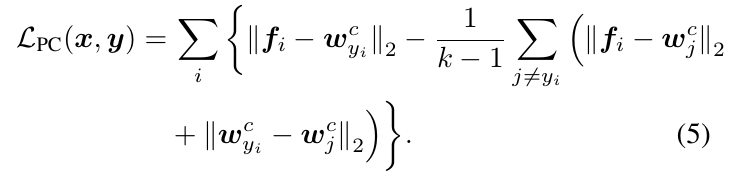

从几何上将是不鲁棒的, 所以本文加了一个正则化项:

显然, 这个是希望\(f_i\)和类别中心\(w_{y_i}\)靠的近, 同时最大化类间距离.

进一步可以拓展到多层情况:

Adversarial Defense by Restricting the Hidden Space of Deep Neural Networks

原文:https://www.cnblogs.com/MTandHJ/p/13285487.html