SGD的问题:

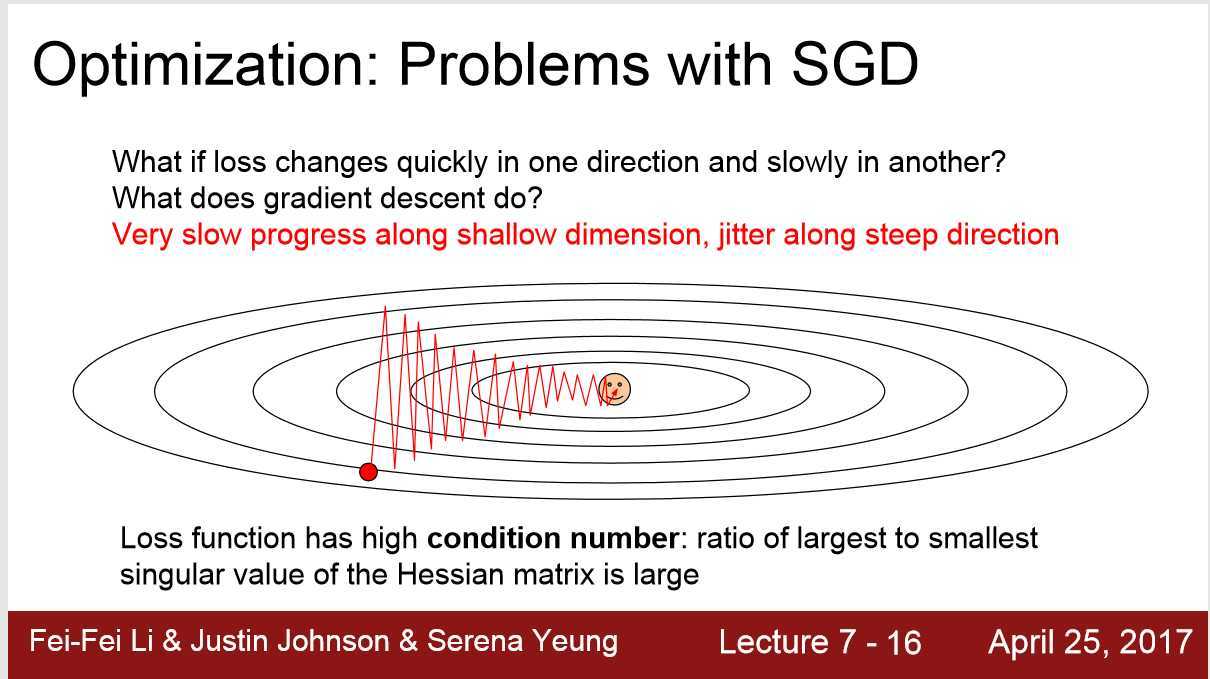

1. Loss 在某一个方向上下降很快,在另一个方向上较慢

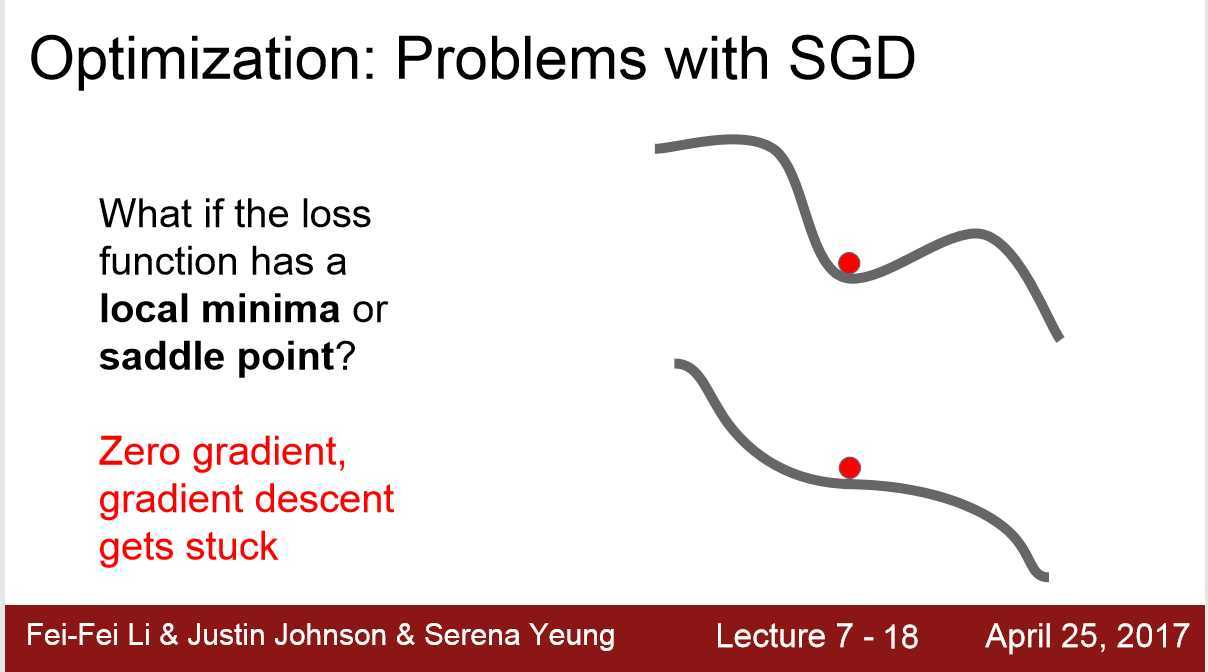

2. 遇到局部最优,或者鞍点:斜率为0或者非常小,这样loss下降的会非常慢

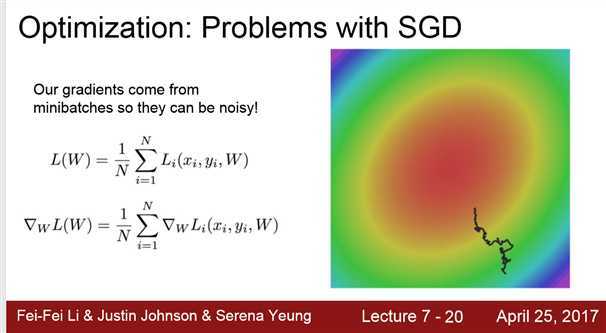

3. 随机梯度下降来自于 随机的一个mini-batch,其最优梯度不一定代表全样本最优

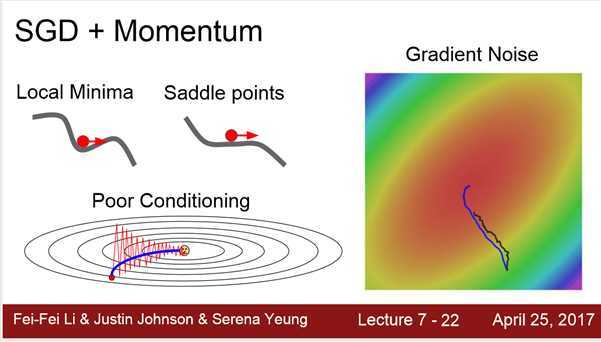

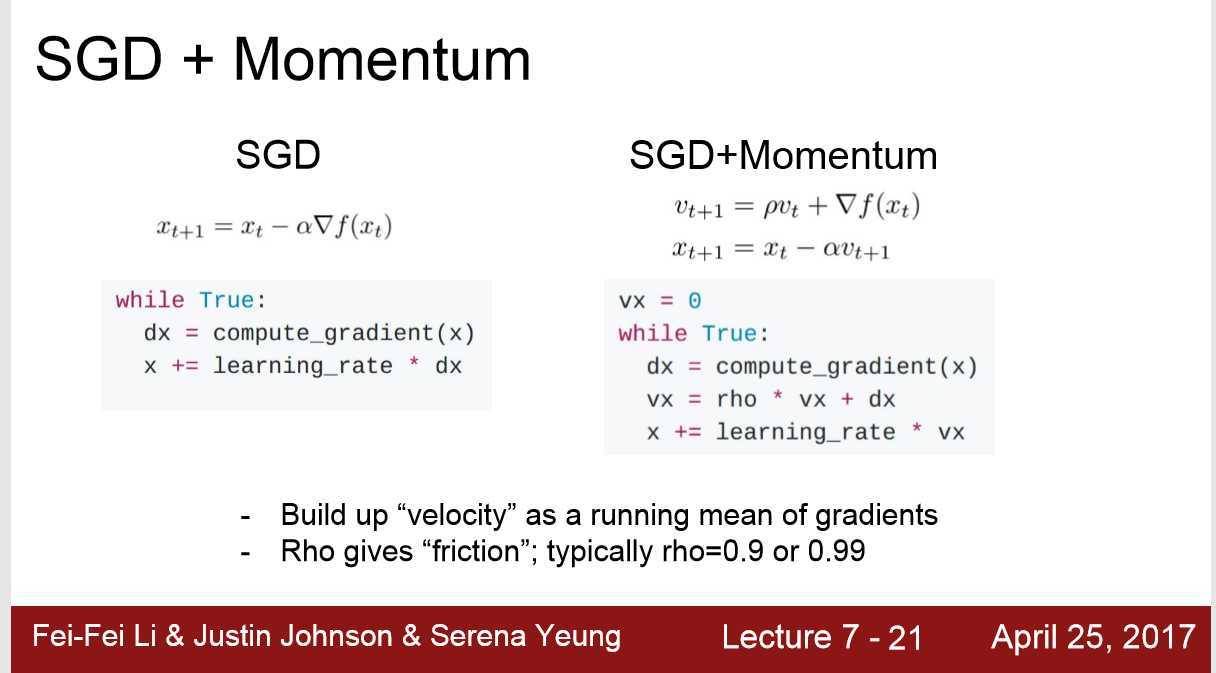

优化方法: SGD+Momentum

加入一个动量项: 在第n+1次更新梯度时,保留0.9倍第n次的梯度,从而更新参数,降低loss

原文:https://www.cnblogs.com/ChevisZhang/p/12950443.html