最近开始粗读论文。这一篇讲的就是1DCNN做Fault Diagnosis。

他的特色有几个

1 第一层用了大卷积核(64),后面全用小的,作者说是第一层就用小的会很受噪音干扰。

第一层大卷积核这个想法我有过,但我的想法是单层大核,直接接MAXPOOL,因为多层的卷积没有物理意义。

之前没有思考过第一层小核的劣势。

2 用了AdaBN,自适应系数的BN,和主方向关系不大不深究了。

3 主要过来读的目的就是他的可视化了。作者可视化了很多东西:

(1)学到的卷积核(第一层) ,分析说有些长得像sinusoid,可以看出来这些卷积核可能是受噪音影响的。

还可视化了这些卷积核的频率域表示。

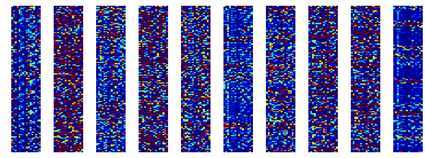

(2).对于十种不同输入,第一层卷积的激活状态。作者说可见不同输入激活位置是不同的。

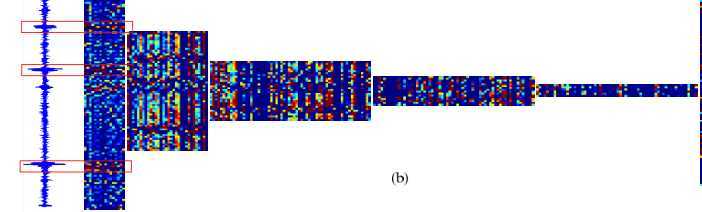

(3).把每一层的激活地图都可视化了,然后标出来第一层比较红的区域。提供一种决策位置上的解释。(这里的想法与图像中的CAM,LRP有一些相似)

.

(4).

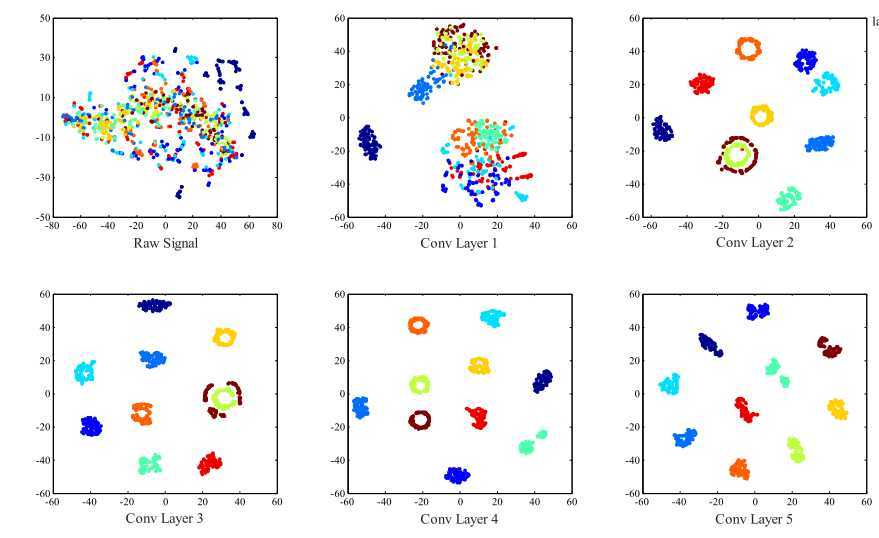

tSNE图 传统方法 体现每一层的学习成果。

对于本文我觉得优点是可视化的研究了一些前人在fault diagnosis领域忽略的东西。

但是对网络结构没有本质上的创新,还是传统的一套,缺点就是第二层开始的特征都缺乏物理意义(所以作者只集中讨论了第一层),

同时CNN本身的学习很受噪音干扰(即使作者用大核优化来避免),从第一层滤波器看出可能很多都没学到本质的东西。

原文:https://www.cnblogs.com/zuoci-acmer/p/12877752.html