环境搭建

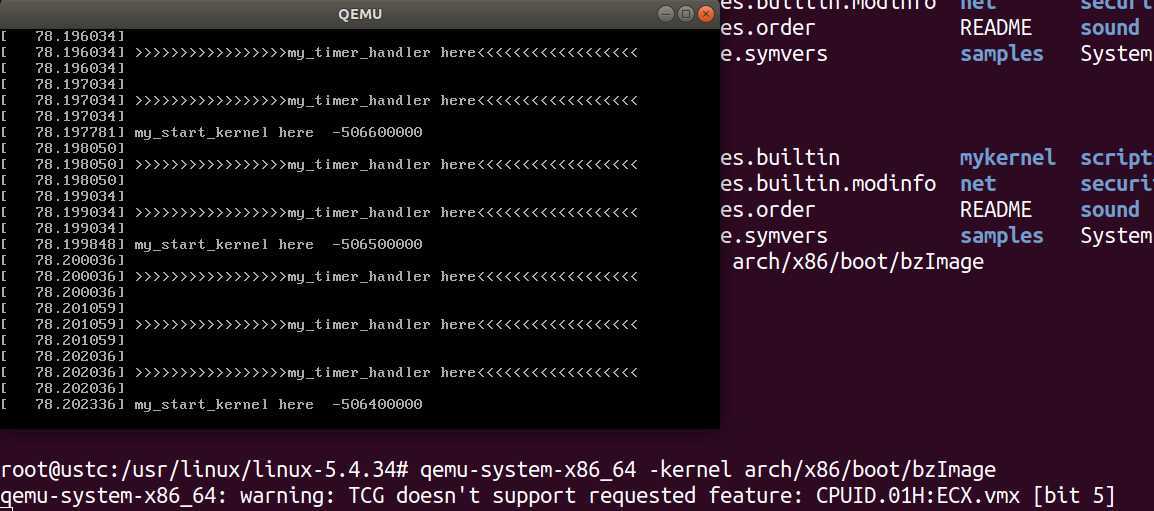

//依次执行下列指令 wget https://raw.github.com/mengning/mykernel/master/mykernel-2.0_for_linux-5.4.34.patch sudo apt install axel axel -n 20 https://mirrors.edge.kernel.org/pub/linux/kernel/v5.x/linux-5.4.34.tar.xz xz -d linux-5.4.34.tar.xz tar -xvf linux-5.4.34.tar cd linux-5.4.34 patch -p1 < ../mykernel-2.0_for_linux-5.4.34.patch sudo apt install build-essential libncurses-dev bison flex libssl-dev libelf-dev make defconfig // Default configuration is based on ‘x86_64_defconfig‘ make -j$(nproc) // 编译的时间比较久哦 sudo apt install qemu // install QEMU qemu-system-x86_64 -kernel arch/x86/boot/bzImage //得到如下运行结果

从qemu窗口中可以看到my_start_kernel在执行,同时my_timer_handler时钟中断处理程序周期性执行。进入mykernel目录可以看到qemu窗口输出的内容的代码mymain.c和myinterrupt.c。当前有一个CPU执行C代码的上下文环境,同时具有中断处理程序的上下文环境,通过Linux内核代码模拟了一个具有时钟中断和C代码执行环境的硬件平台。

源码分析

内核的编译

qemu :相当于打开一个虚拟机

kernel:启动一个内核,位置由其后的文件名指定。

initrd指令:挂了一个ramdisk虚拟硬盘,是内核的重要补充,rootfs.img就是这个虚拟硬盘,内有分区,然后启动其中的init.init是由之前编译而成,gcc -o命名为init

内核的启动

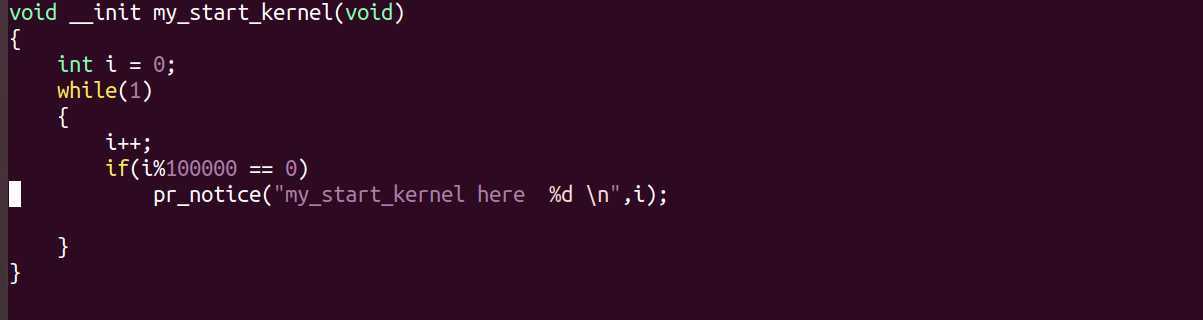

mymain.c

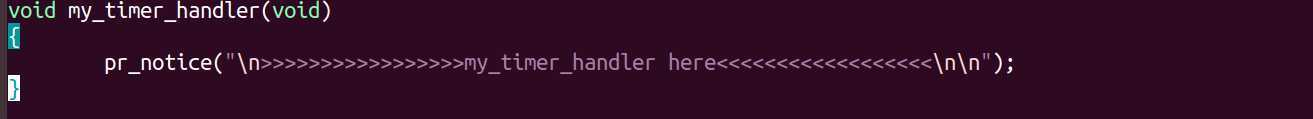

myinterrupt.c

在Linux-5.3.34内核源代码根?录下进?mykernel?录,可以看到QEMU窗?输出的内容的代码mymain.c和myinterrupt.c ,当前有?个虚拟的CPU执?C代码的上下?环境,可以看到mymain.c中的代码在不停地执?。同时有?个中断处理程序的上下?环境,周期性地产?的时钟中断信号,能够触发myinterrupt.c中的代码。这样就通过Linux内核代码模拟了?个具有时钟中断和C代码执?环境的硬件平台。只要在mymain.c的基础上继续写进程描述PCB和进程链表管理等代码,在myinterrupt.c的基础上完成进程切换代码,就可以完成?个可运?的?OS kernel。

最简单的操作系统内核代码

①定义线程,进程控制块的.h文件

/* CPU-specific state of this task */ struct Thread { unsigned long ip; unsigned long sp; }; typedef struct PCB{ int pid; volatile long state; /* -1 unrunnable, 0 runnable,*/ char stack[KERNEL_STACK_SIZE]; /* CPU-specific state of this task */ struct Thread thread; unsigned long task_entry; struct PCB *next; }tPCB; void my_schedule(void);

②在mymain.c中添加内核入口函数my_start_kernel和处理函数

void __init my_start_kernel(void) { int pid = 0; int i; /* Initialize process 0*/ task[pid].pid = pid; task[pid].state = 0;/* -1 unrunnable, 0 runnable, >0 stopped */ task[pid].task_entry = task[pid].thread.ip = (unsigned long)my_process; task[pid].thread.sp=(unsignedlong)task[pid].stack[KERNEL_STACK_SIZE- task[pid].next = &task[pid]; /*fork more process */ for(i=1;i<MAX_TASK_NUM;i++) { memcpy(&task[i],&task[0],sizeof(tPCB)); task[i].pid = i; task[i].state = -1; task[i].thread.sp = (unsigned long)&task[i].stack[KERNEL_STACK_SIZE- task[i].next = task[i-1].next; task[i-1].next = &task[i]; } /* start process 0 by task[0] */ pid = 0; my_current_task = &task[pid]; asm volatile( "movq %1,%%rsp\n\t" /* set task[pid].thread.sp to rsp */ "pushq %1\n\t" /* push rbp */ "pushq %0\n\t" /* push task[pid].thread.ip */ "ret\n\t" /* pop task[pid].thread.ip to rip */ : : "c" (task[pid].thread.ip),"d" (task[pid].thread.sp) ); }

说明:初始化MAX_TASK_NUM个进程控制块,使用嵌入式汇编代码将零号进程的sp和ip写入寄存器

void my_process(void) { while(1) { i++; if(i%10000000 == 0) { printk(KERN_NOTICE "this is process %d -\n",my_current_task->pid); if(my_need_sched == 1) { my_need_sched = 0; my_schedule(); } printk(KERN_NOTICE "this is process %d +\n",my_current_task->pid); } } }

③重新编写myintercept.c

extern tPCB task[MAX_TASK_NUM]; extern tPCB * my_current_task; extern volatile int my_need_sched; volatile int time_count = 0; /* * Called by timer interrupt. * it runs in the name of current running process, * so it use kernel stack of current running process */ void my_timer_handler(void) { if(time_count%1000 == 0 && my_need_sched != 1) { printk(KERN_NOTICE ">>>my_timer_handler here<<<\n"); my_need_sched = 1; } time_count ++ ; return; } void my_schedule(void) { tPCB * next; tPCB * prev; if(my_current_task == NULL || my_current_task->next == NULL) { return; } printk(KERN_NOTICE ">>>my_schedule<<<\n"); /* schedule */ next = my_current_task->next; prev = my_current_task; if(next->state == 0)/* -1 unrunnable, 0 runnable, >0 stopped */ { my_current_task = next; printk(KERN_NOTICE ">>>switch %d to %d<<<\n",prev->pid,next->pid); /* switch to next process */ asm volatile( "pushq %%rbp\n\t" /* save rbp of prev */ "movq %%rsp,%0\n\t" /* save rsp of prev */ "movq %2,%%rsp\n\t" /* restore rsp of next */ "movq $1f,%1\n\t" /* save rip of prev */ "pushq %3\n\t" "ret\n\t" /* restore rip of next */ "1:\t" /* next process start here */ "popq %%rbp\n\t" : "=m" (prev->thread.sp),"=m" (prev->thread.ip) : "m" (next->thread.sp),"m" (next->thread.ip) ); } return; }

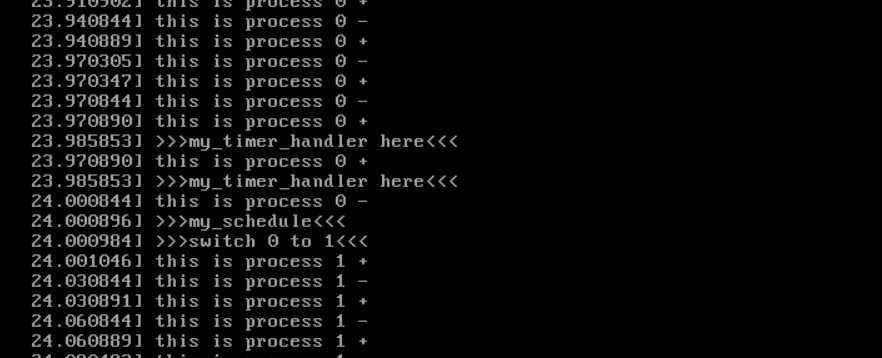

运行

进程的切换

为了简便,假设系统只有两个进程,分别是进程0和进程1。进程0由内核启动时初始化执?,然后需要进程调度和进程切换,然后开始执?进程1。

进程切换过程中进程0和进程1的堆栈和相关寄存器的变化过程?致如下:

• • pushq %%rbp 保存prev进程(本例中指进程0)当前RBP寄存器的值到堆栈;

• • movq %%rsp,%0 保存prev进程(本例中指进程0)当前RSP寄存器的值到prev->thread.sp,这时RSP寄存器指向进程的栈顶地址,实际上

就是将prev进程的栈顶地址保存;%0、%1...指这段汇编代码下?输?输出部分的编号。

• • movq %2,%%rsp 将next进程的栈顶地址next->thread.sp放?RSP寄存器,完成了进程0和进程1的堆栈切换。

• • movq $1f,%1 保存prev进程当前RIP寄存器值到prev->thread.ip,这?$1f是指标号1。

• • pushq %3 把即将执?的next进程的指令地址next->thread.ip?栈,这时的next->thread.ip可能是进程1的起点my_process(void)函数,也

可能是$1f(标号1)。第?次被执?从头开始为进程1的起点my_process(void)函数,其余的情况均为$1f(标号1),因为next进程如果之前运?过

那么它就?定曾经也作为prev进程被进程切换过。

• • ret 就是将压?栈中的next->thread.ip放?RIP寄存器,为什么不直接放?RIP寄存器呢?因为程序不能直接使?RIP寄存器,只能通过call、

ret等指令间接改变RIP寄存器。

• • 1: 标号1是?个特殊的地址位置,该位置的地址是$1f。

• • popq %%rbp 将next进程堆栈基地址从堆栈中恢复到RBP寄存器中。

原文:https://www.cnblogs.com/slm-/p/12860026.html