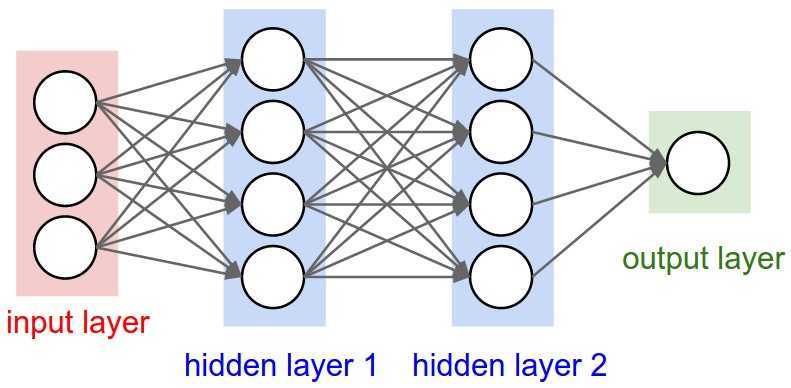

完全连接层:

两个相邻层之间的神经元完全成对连接,但是单层内的神经元不共享任何连接。、

命名约定:

当我们说N层神经网络时,不包括输入层。单层神经网络描述的是没有隐藏层的网络。

输出层:

输出层神经元通常不具有激活功能。通常将最后一个输出层用于表示分类。

神经网络的大小:

指标:神经元的数量(不包括输入层)或者是参数的数量(可学习的参数,包括权重参数和偏差参数)。

FP:前馈计算示例;

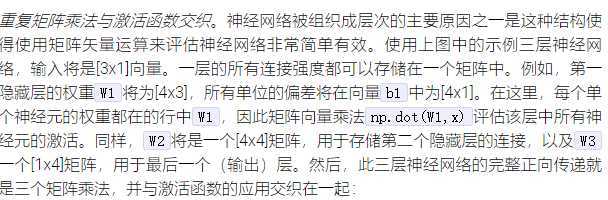

重复矩阵乘法与激活函数交织。

# forward-pass of a 3-layer neural network:

f = lambda x: 1.0/(1.0 + np.exp(-x)) # activation function (use sigmoid)

x = np.random.randn(3, 1) # random input vector of three numbers (3x1)

h1 = f(np.dot(W1, x) + b1) # calculate first hidden layer activations (4x1)

h2 = f(np.dot(W2, h1) + b2) # calculate second hidden layer activations (4x1)

out = np.dot(W3, h2) + b3 # output neuron (1x1)

设置数据和模型:

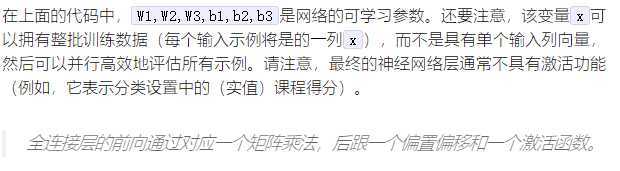

数据预处理:

均值减法/归一化

左侧图像是原始图像--二维输入数据;中间图像:通过减去每个维度的平均值,数据以零点为中心;右侧图像:每个尺度通过其标准差进行缩放。

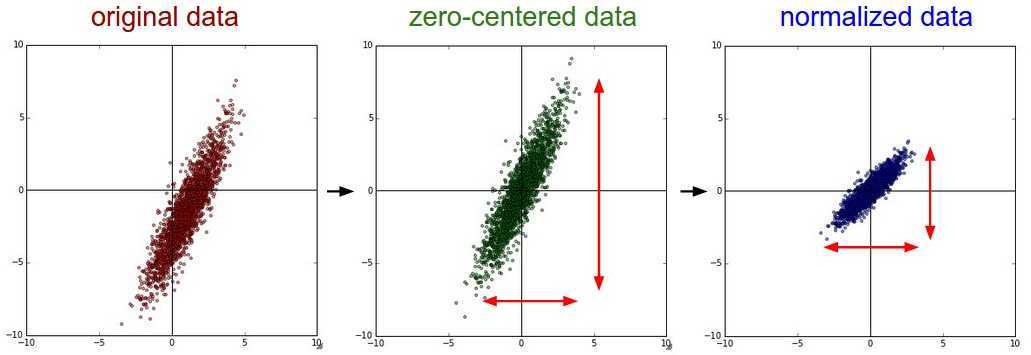

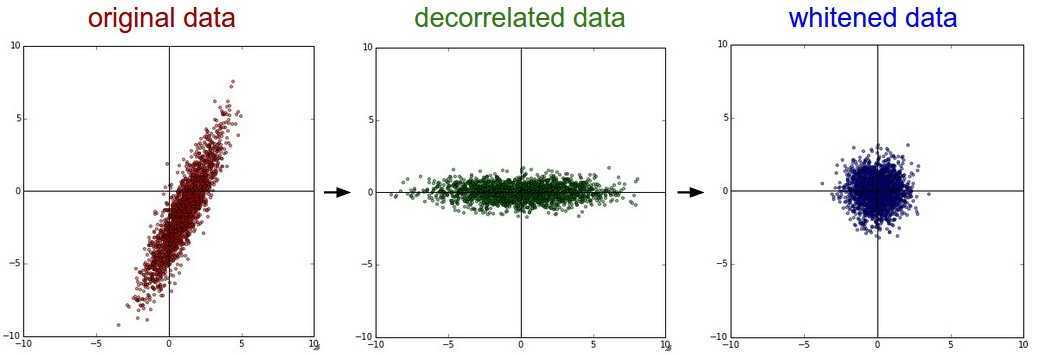

PCA/白化

左侧图像:原始图像,二维输入数据;

中间图像:执行PCA后,数据以零点为中心,然后旋转为数据协方差矩阵的本征基。这将对数据进行解相关。

右侧图像:每个维度通过特征缩放,将数据协方差矩阵转化为单位矩阵。在几何上,这对应于将数据拉伸和压缩为各向同性的高斯斑点。

未完成....

原文:https://www.cnblogs.com/djrcomeon/p/12490958.html