1. 作用:中文文本通过分词获得单个词语,属于第三方库,需要提前cmd+r 打开命令行安装, <pip install jieba>

2. 模式:共3种;no.1: 精确模式 : 把文本精确地分开,不存在冗余

no.2: 全模式 : 把文本中所有可能存在的词语都扫描出来,存在冗余

no.3: 搜索引擎模式 : 在精确模式的基础上,对长词再次切分,有冗余

3. 常用函数

| 函数 | 描述 |

| jieba.lcut() | 返回一个列表类型的分词结果,没有冗余 |

| jieba.lcut(s,cut_all=True) | 返回一个列表类型的分词结果,有冗余 |

| jieba.lcut_for_seach(s) | 返回一个列表类型的分词结果,有冗余 |

| jieba.add_word(w) | 向分词词典增加新词w |

4. 案例:

import jieba #导入jieba库 txt = "我看见他戴着黑布小帽,穿着黑布大马褂,深青布棉袍,蹒跚地走到铁道边,慢慢探身下去,尚不大难。可是他穿过铁道,要爬上那边月台,就不容易了。"

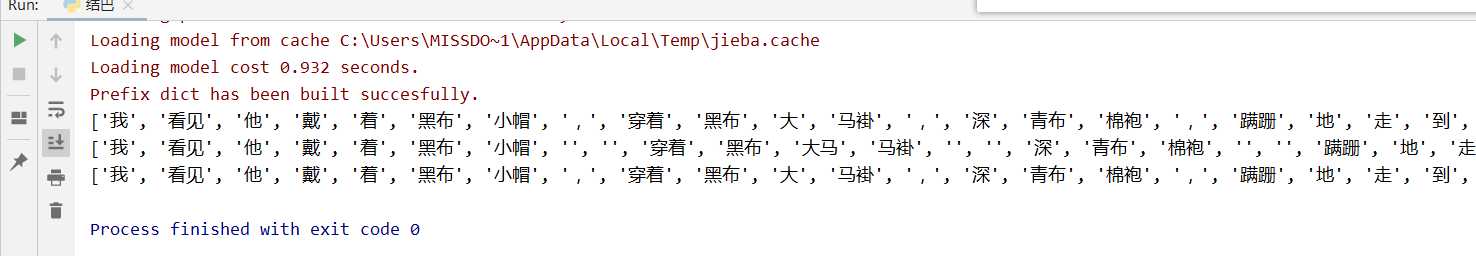

res = jieba.lcut(txt) #精确分词模式,没有冗余

print(res)

res1 = jieba.lcut(txt,cut_all=True) #全分词模式,有冗余

print(res1)

res2 = jieba.lcut_for_search(txt) #搜素引擎分词模式,有冗余

print(res2)

run res , res1, res2 结果:

原文:https://www.cnblogs.com/Cheryl-D/p/11759245.html