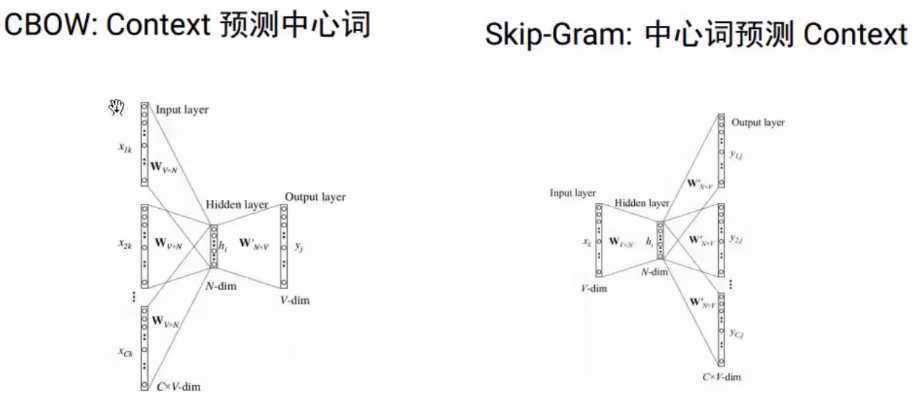

分布式假设:假设两个词上下文相似,则它们的语义也相似。

问题:词向量不考虑上下文,无法解决“一词多义”

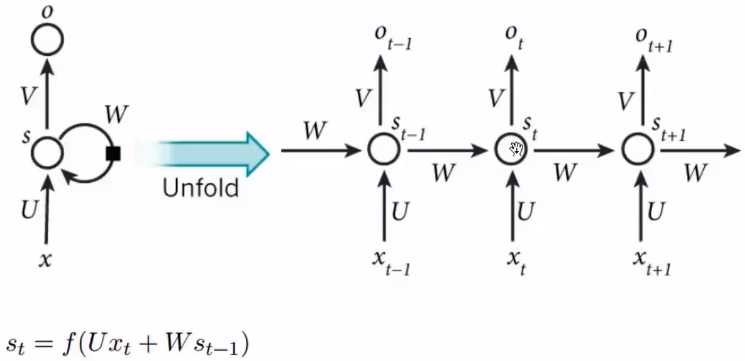

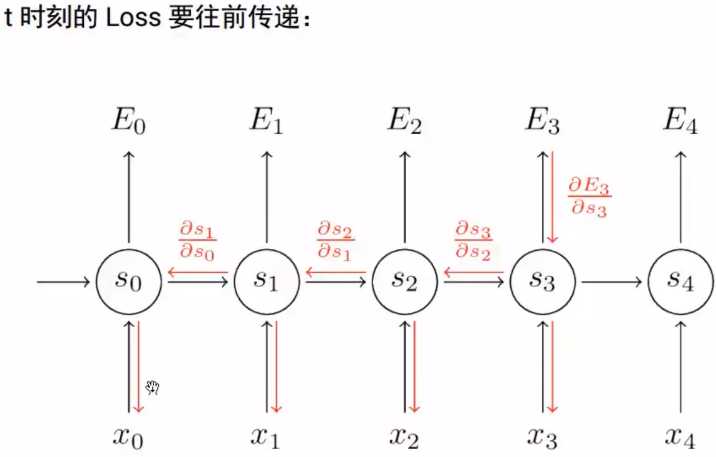

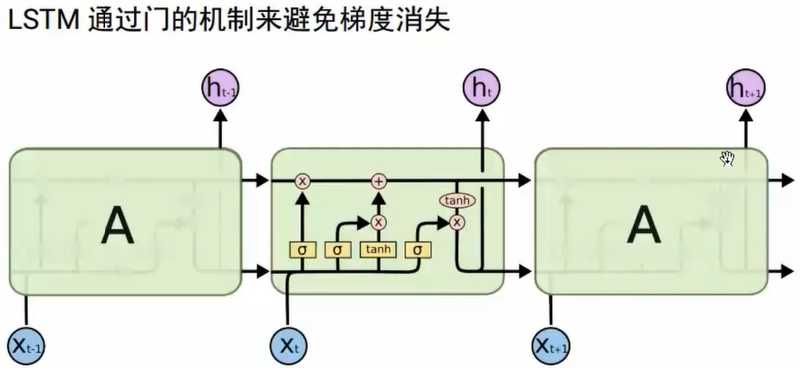

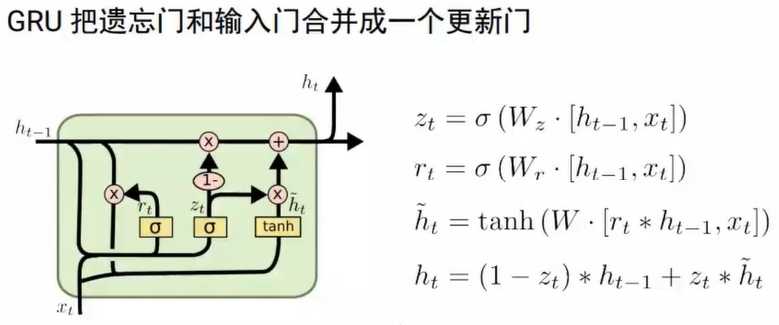

解决方案:RNN具有“记忆”能力

RNN的问题:顺序依赖,无法并行。(单向信息流)

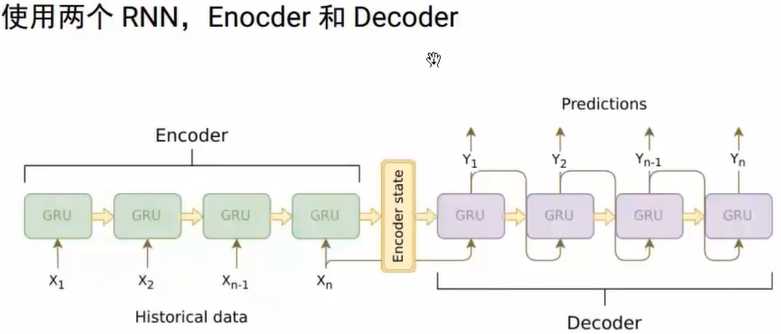

可用于翻译、摘要、问答和对话系统

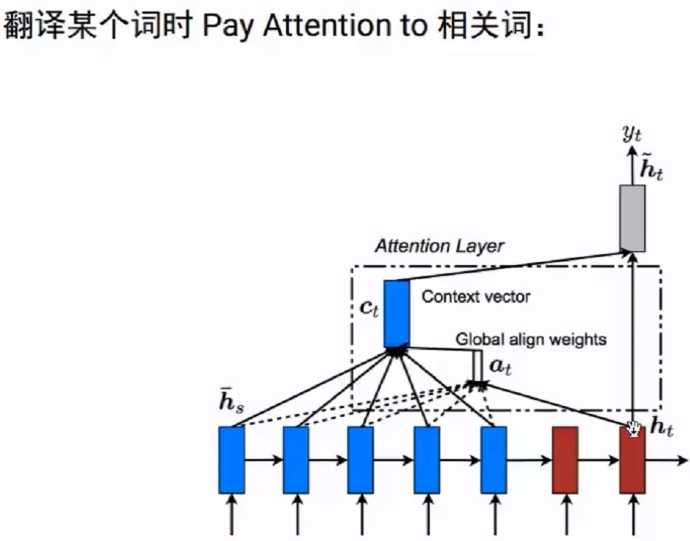

问题:定长的context向量

问题:监督数据量不足,难以学到复杂的上下文表示;

解决方案:无监督的contextual word embedding:ELMo、OpenAI GPT、BERT

原文:https://www.cnblogs.com/nxf-rabbit75/p/11626806.html