设$A$是n阶方阵,如果存在数$\lambda$和n维非零列向量$x$使:

\[Ax = \lambda x\]

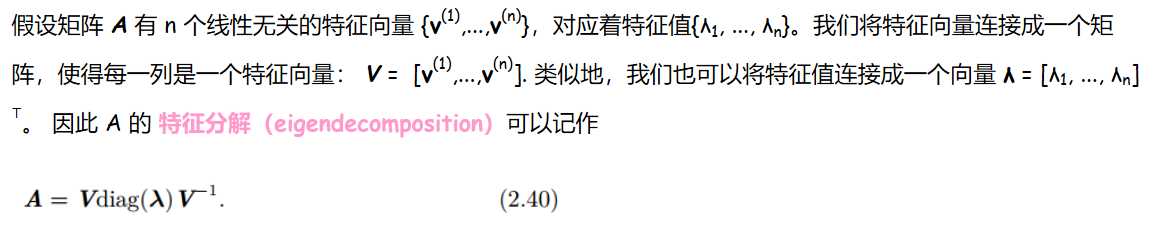

则称数$\lambda$为矩阵$A$的特征值,非零列向量$x$称为矩阵$A$的属于特征值$\lambda$的特征向量。(类似的我们也可以定义左特征向量:${x^T}A = \lambda {x^T}$)。

每个实对称矩阵都可以分解成实特征向量和实特征值。

一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。特征值表示的是这个特征到底有多重要,而特征向量表示这个特征是什么,描述了矩阵的一个变化方向。而一个高维矩阵可能会有多个变化方向, 我们通过特征值分解得到的前N个特征向量(特征值按从小到大排列),那么就对应了这个矩阵最主要的N个变化方向。我们利用这前N个变化方向,就可以近似这个矩阵(变换)。

https://www.cnblogs.com/jian-gao/p/10781649.html

原文:https://www.cnblogs.com/xumaomao/p/11389105.html