1. 线性分类SVM面临的问题

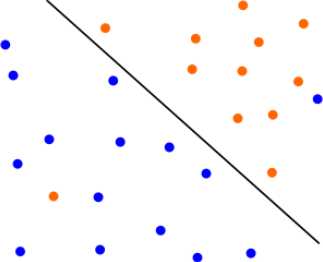

(1)、有时候数据可以用线性分类SVM来求解,但因为混入异常点,导致不能线性可分,

比如下图:有一个蓝色和橙色异常点导致不能按照线性支持向量机方法来分类。

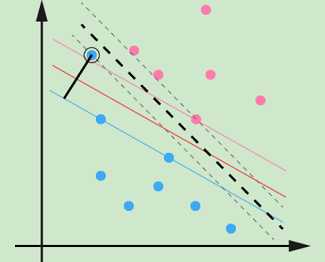

(2)、数据可分,但影响模型泛化能力。

比如下图:不考虑异常点,SVM的超平面应该是下图中的红线,但由于一个蓝色异常点,导致学习的超平面是下图中的粗虚线。

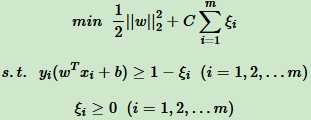

2. 线性分类SVM的软间隔最大化

SVM对训练集里面的每个样本 (xi,yi) 引入一个松弛变量 ξi ≥ 0,使函数间隔加上松弛变量 ≥1,也就是说:

yi ( w•xi + b) ≥ 1-ξi

对比硬间隔最大化,对样本到超平面的距离的要求放松了,之前 ≥1 ,现在加上一个 ≥0 的松弛变量满足 ≥1 即可。当然每一个松弛变量 ξi 对应一个代价 Cξi ,所以软间隔最大化的 SVM 模型为:

其中,C>0为惩罚系数,可以理解为回归和分类问题的正则化参数。

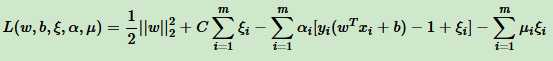

3. 线性分类SVM的软间隔最大化目标函数的优化

和线性可分SVM的优化类似,先将软间隔最大化的约束问题用拉格朗日函数转化为无约束问题:

其中  ,均为拉格朗日系数。

,均为拉格朗日系数。

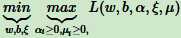

也就是说,现在要优化的目标函数是:

我们可以先求优化函数对于 ω,b,ξ的极小值,接着再求拉格朗日乘子 α 和 μ 的极大值。

原文:https://www.cnblogs.com/keye/p/11138981.html