Motivation:

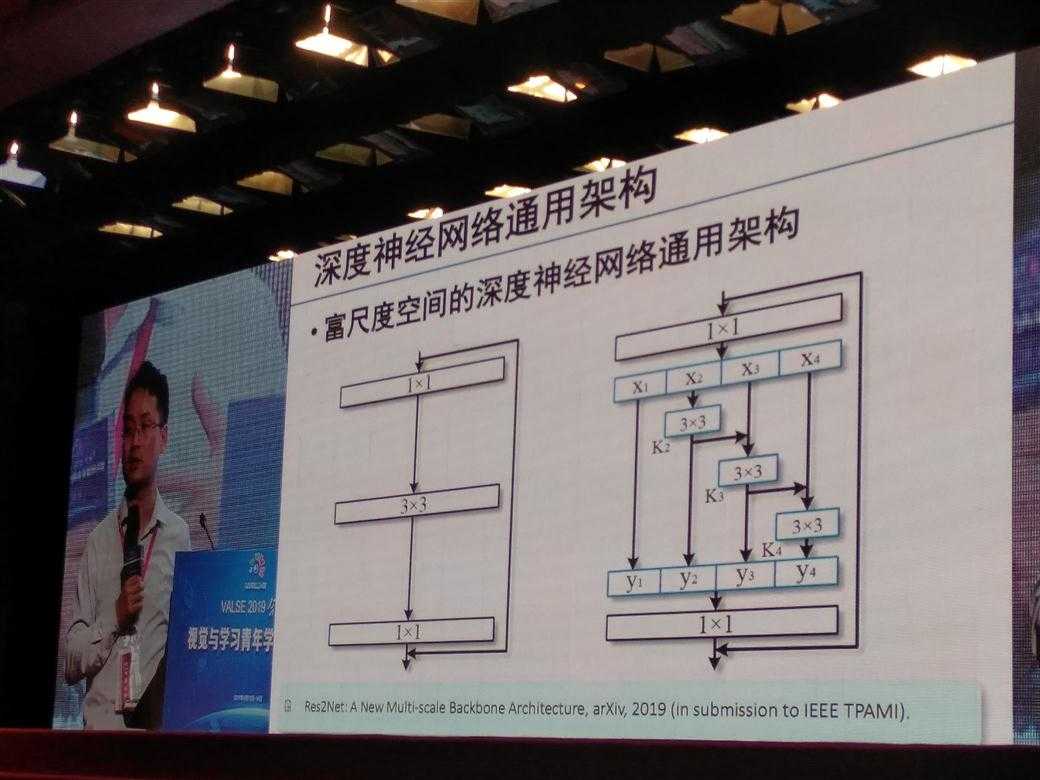

当前各种深度网络的进步得益于网络多尺度信息综合能力的提升

报告主要内容:

富尺度空间神经网络是什么?

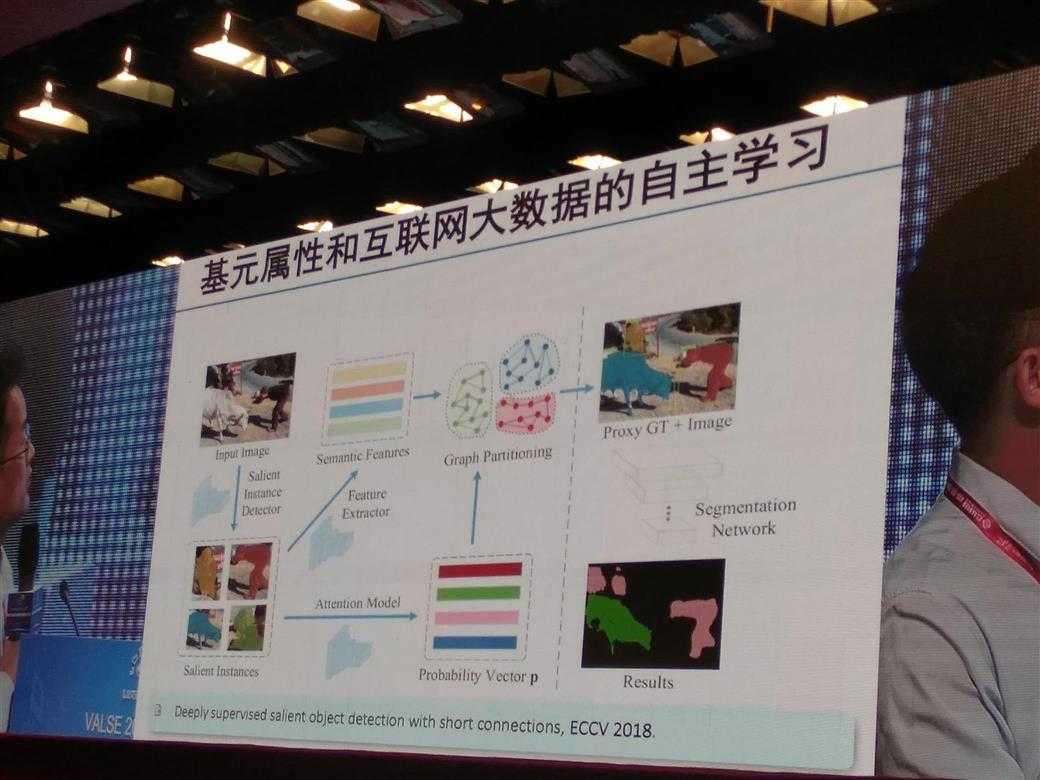

显著性物体检测分类:

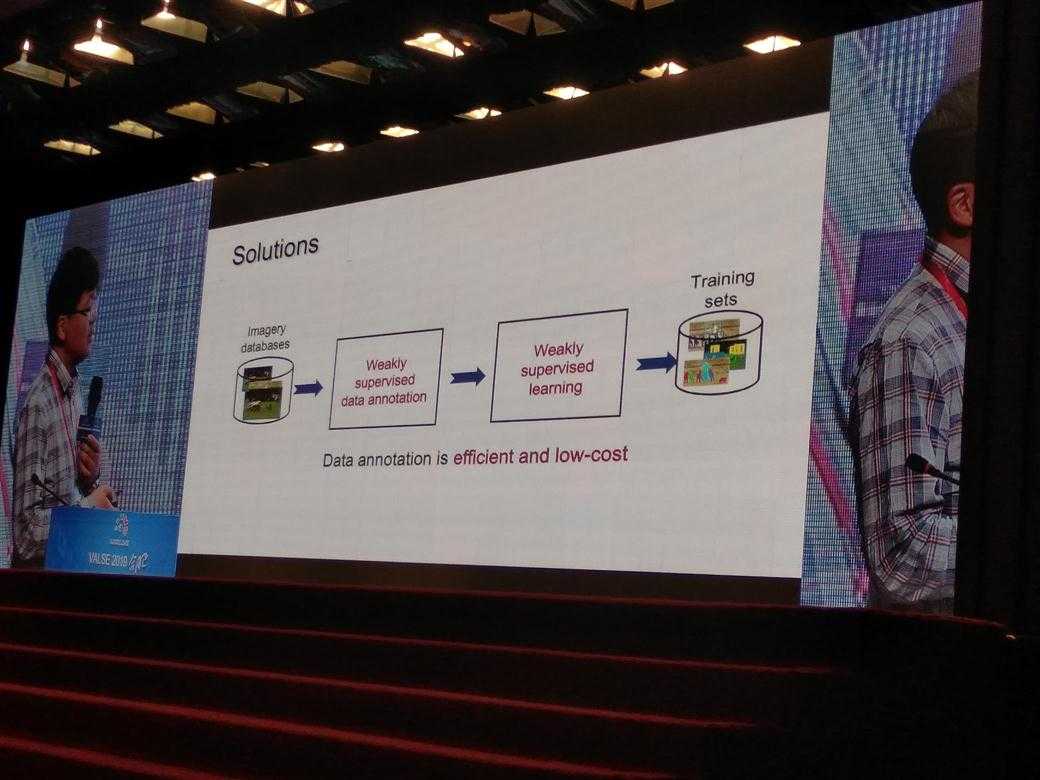

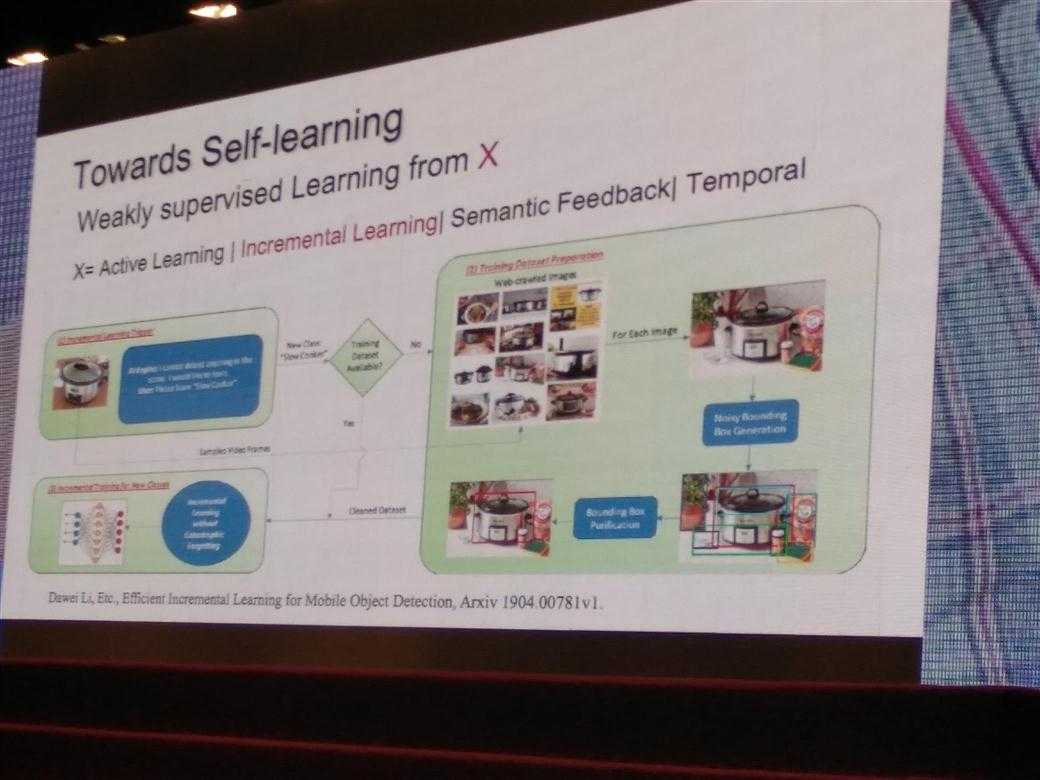

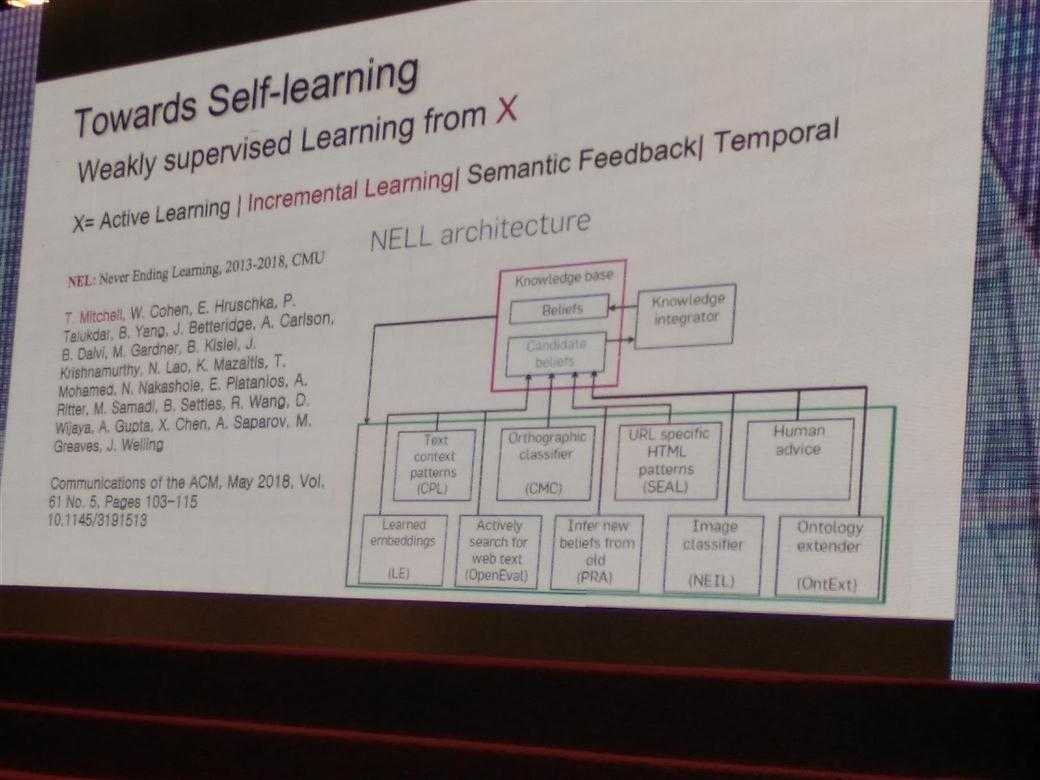

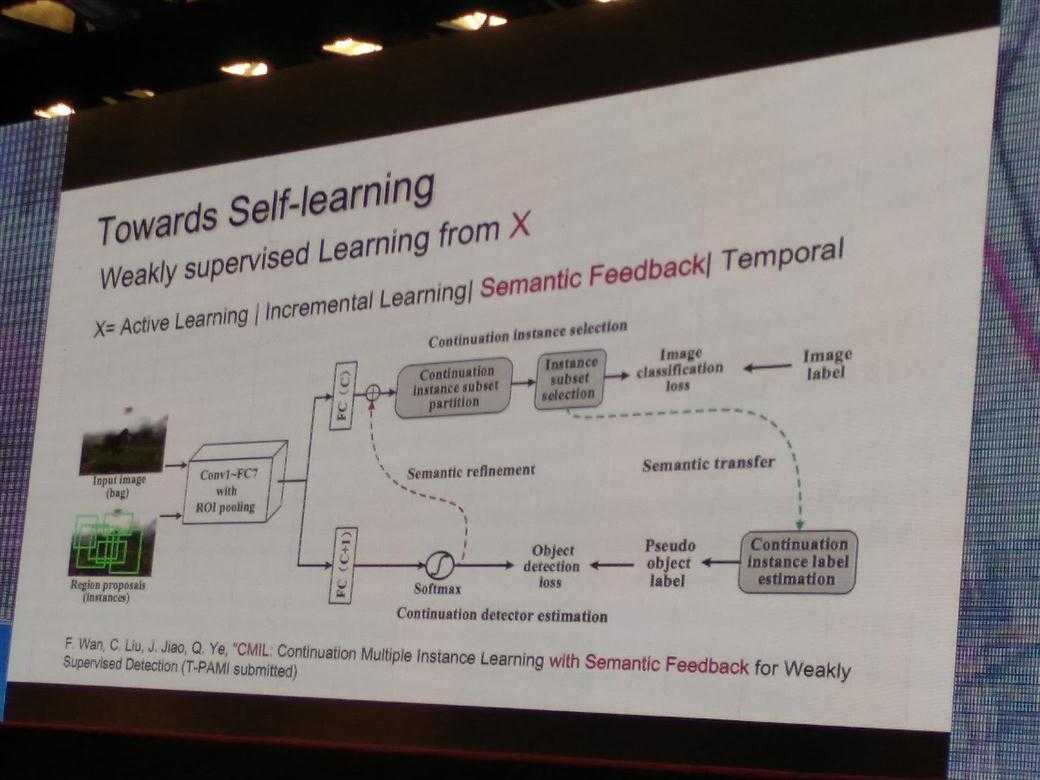

互联网大数据自主学习:

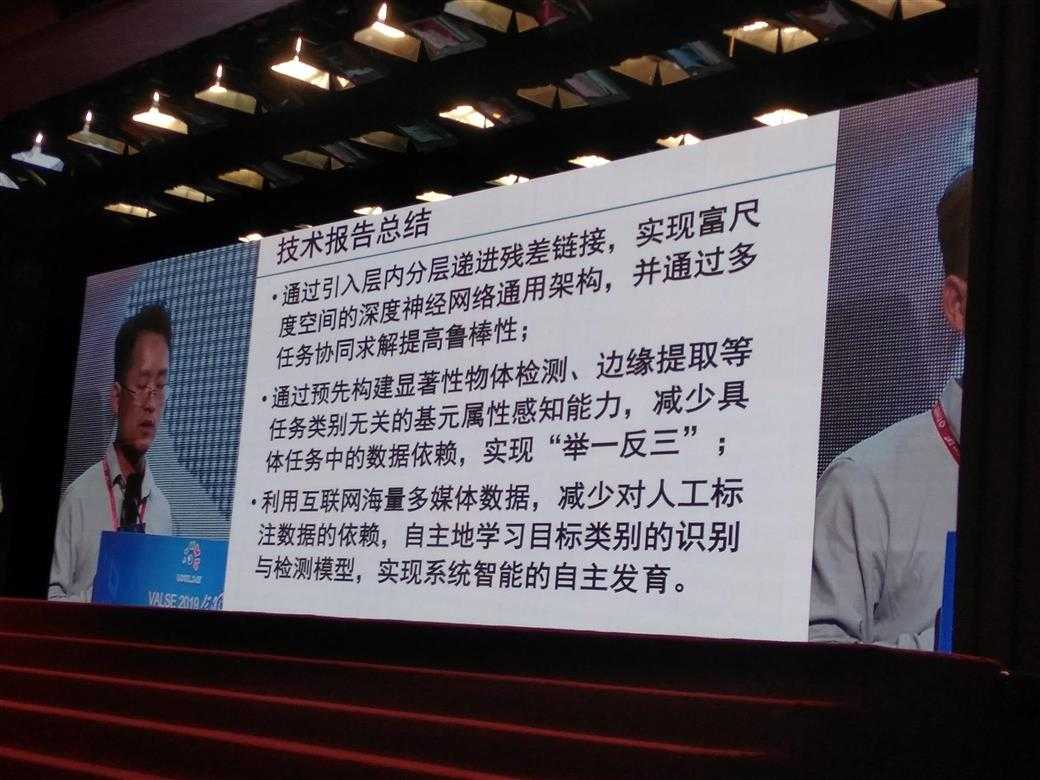

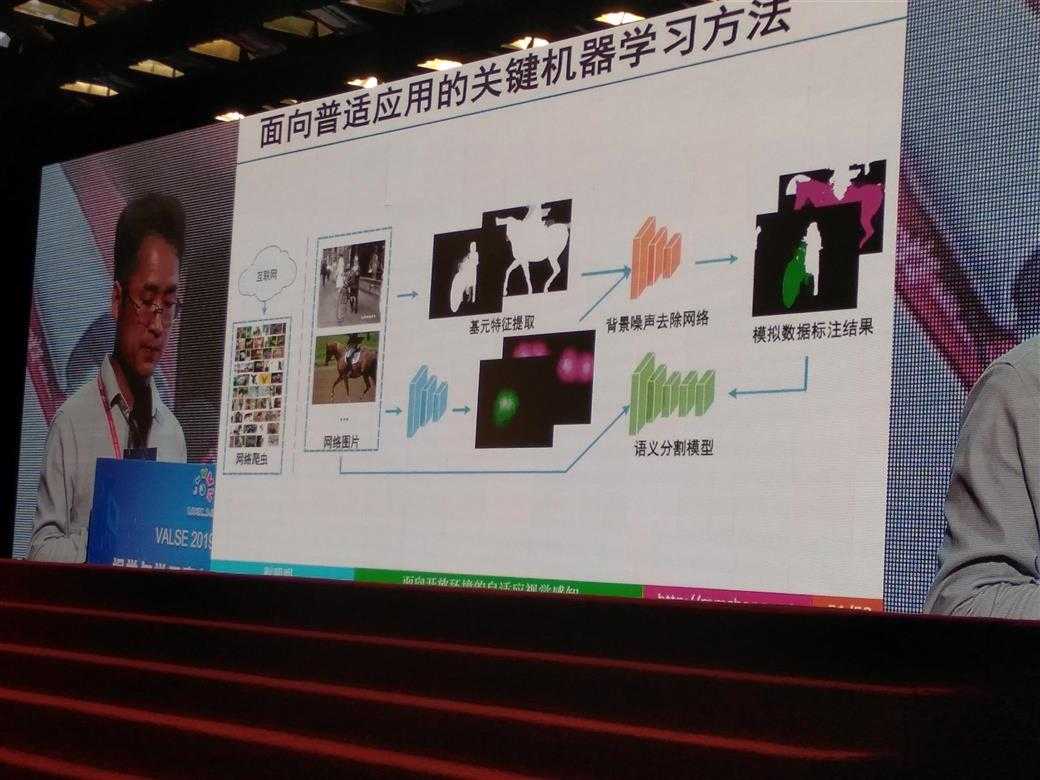

利用互联网海量多媒体数据,减少对人工标注数据的依赖,自主学习目标类别的识别与检测模型,实现系统只能的自主发育

现状

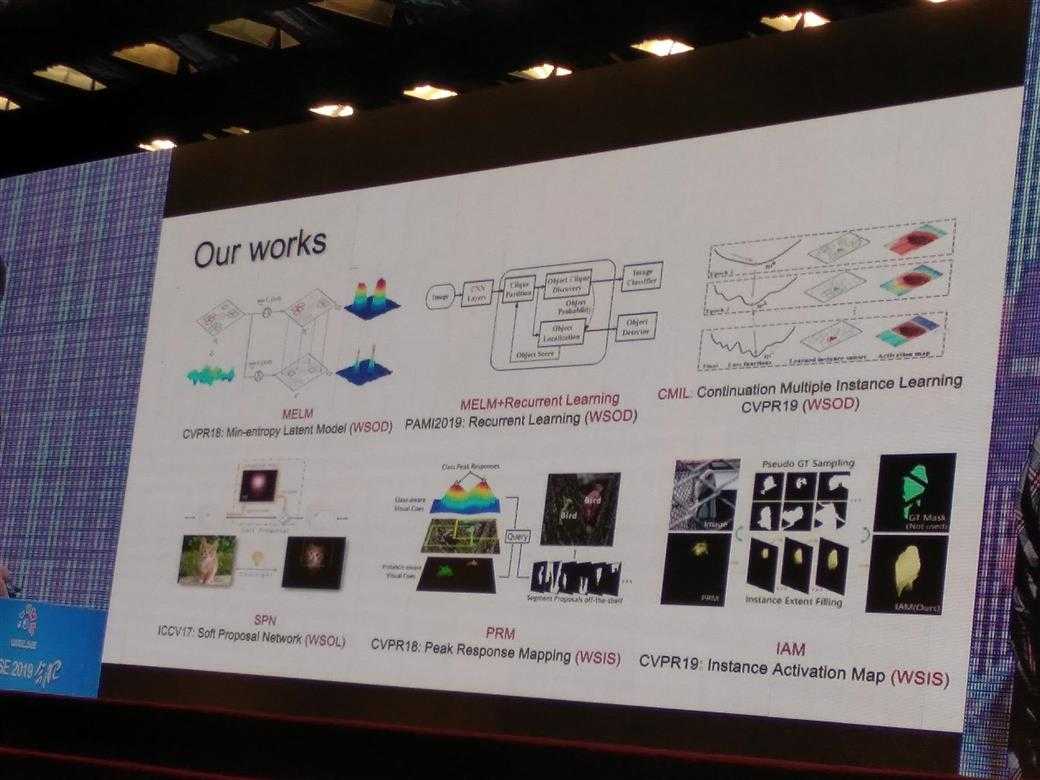

papers:

整理如下:

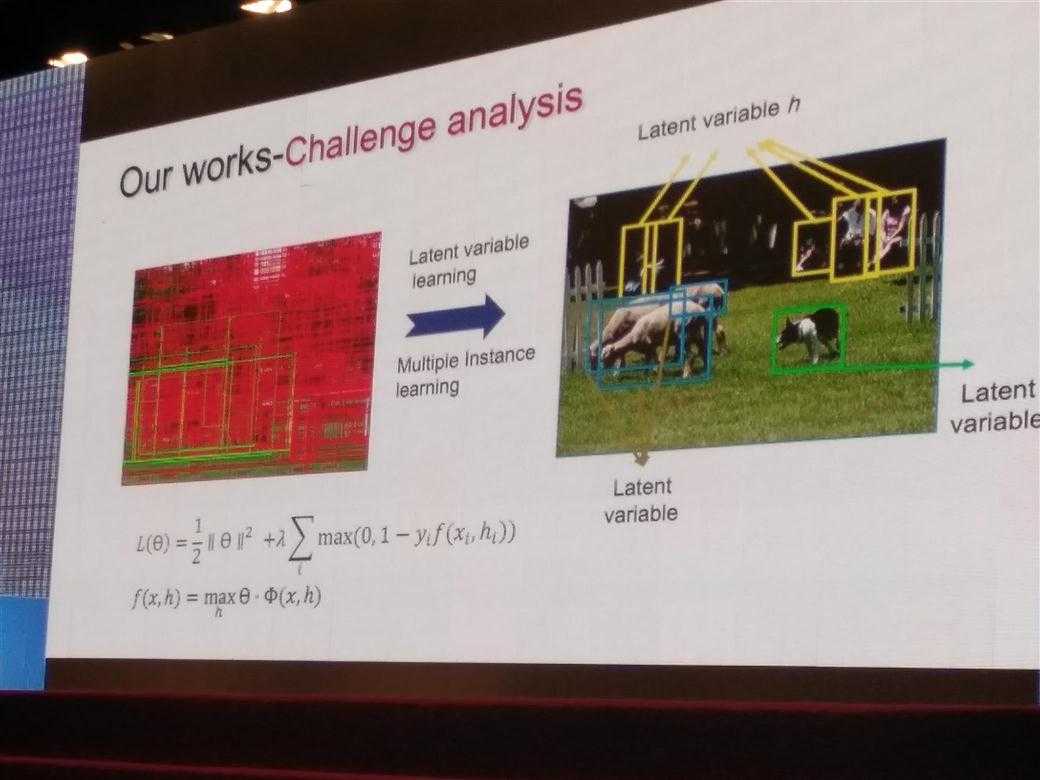

上述论文思路

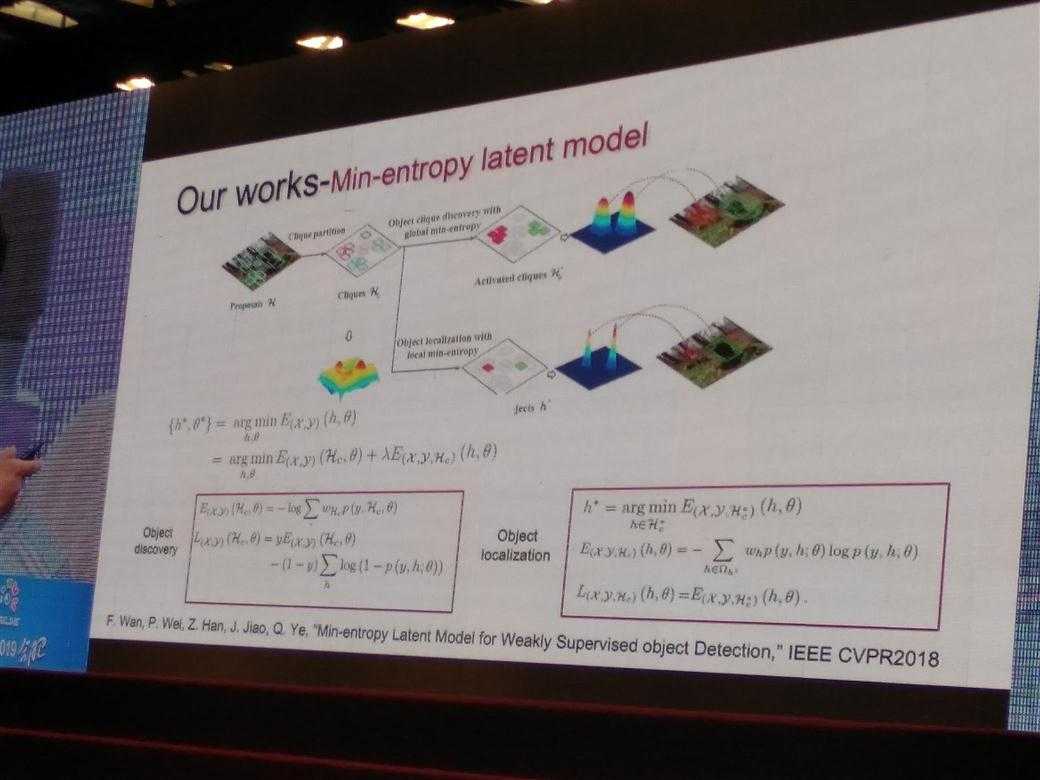

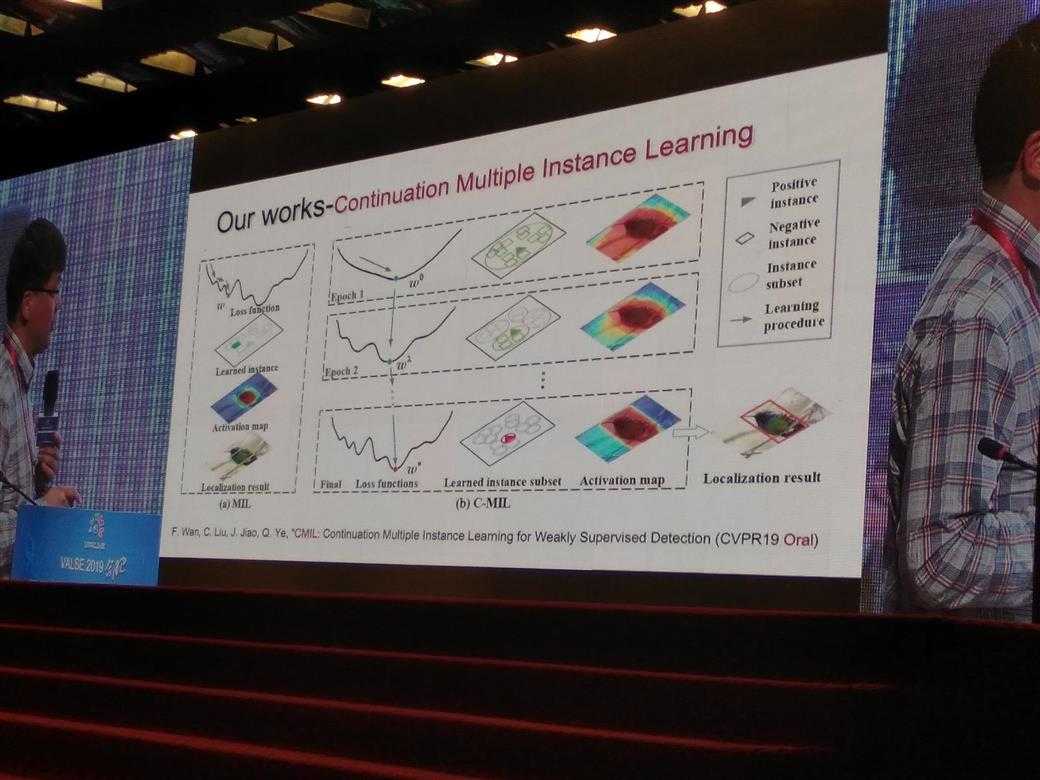

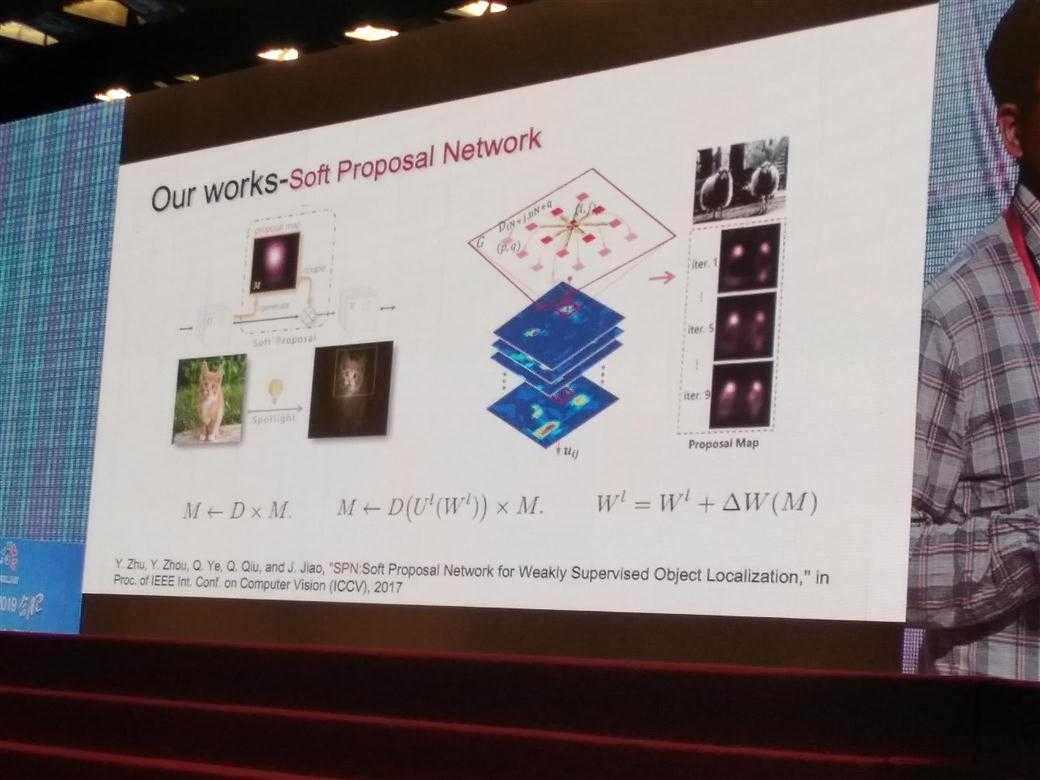

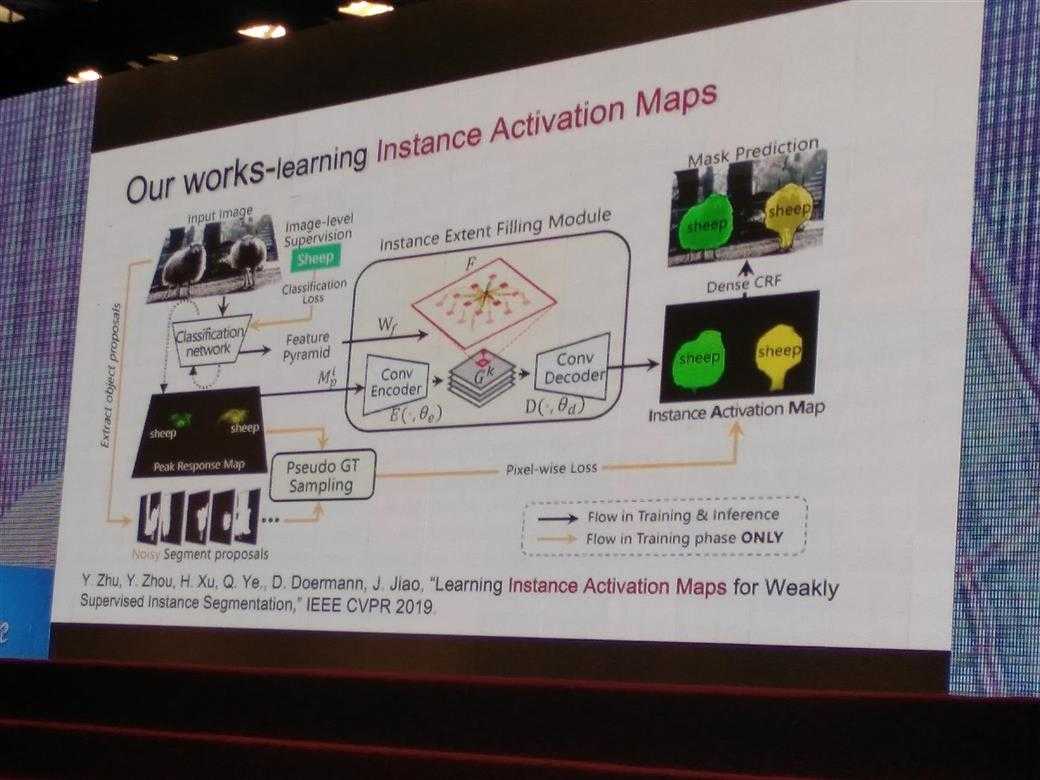

隐变量学习、多实例学习,但是有个问题:一般无法找到全局最优解

对应的solution如下:

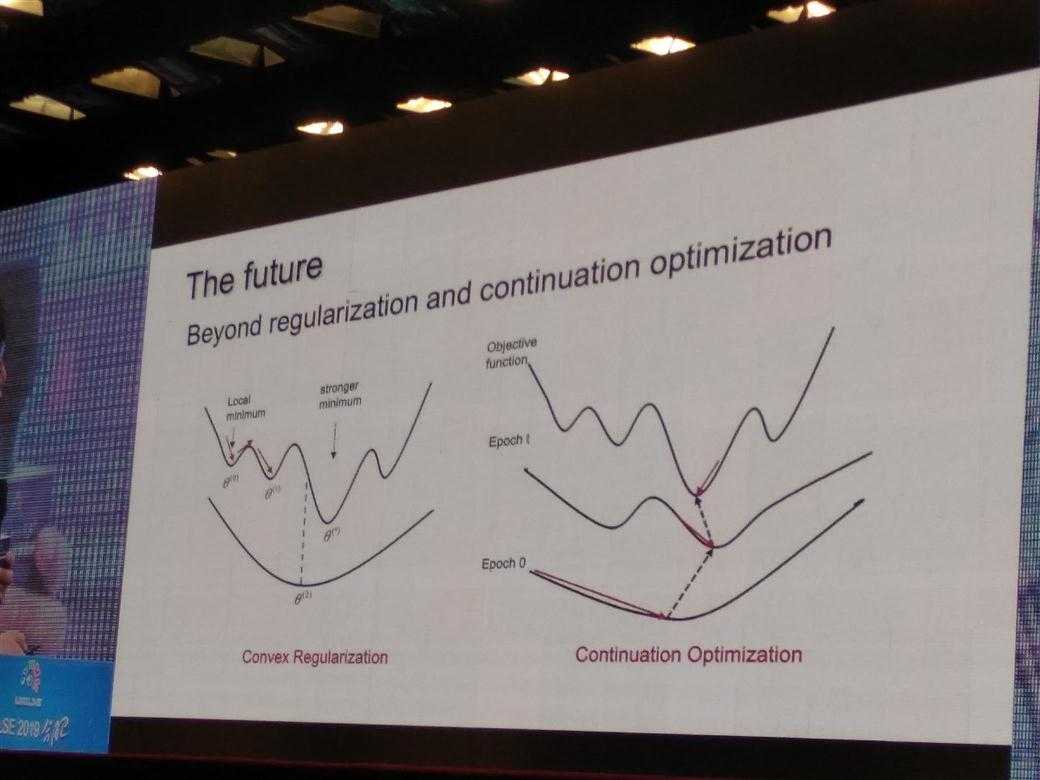

上面几篇论文都是对上面两种优化方式的具体解法,摘选如下:

未来发展方向:

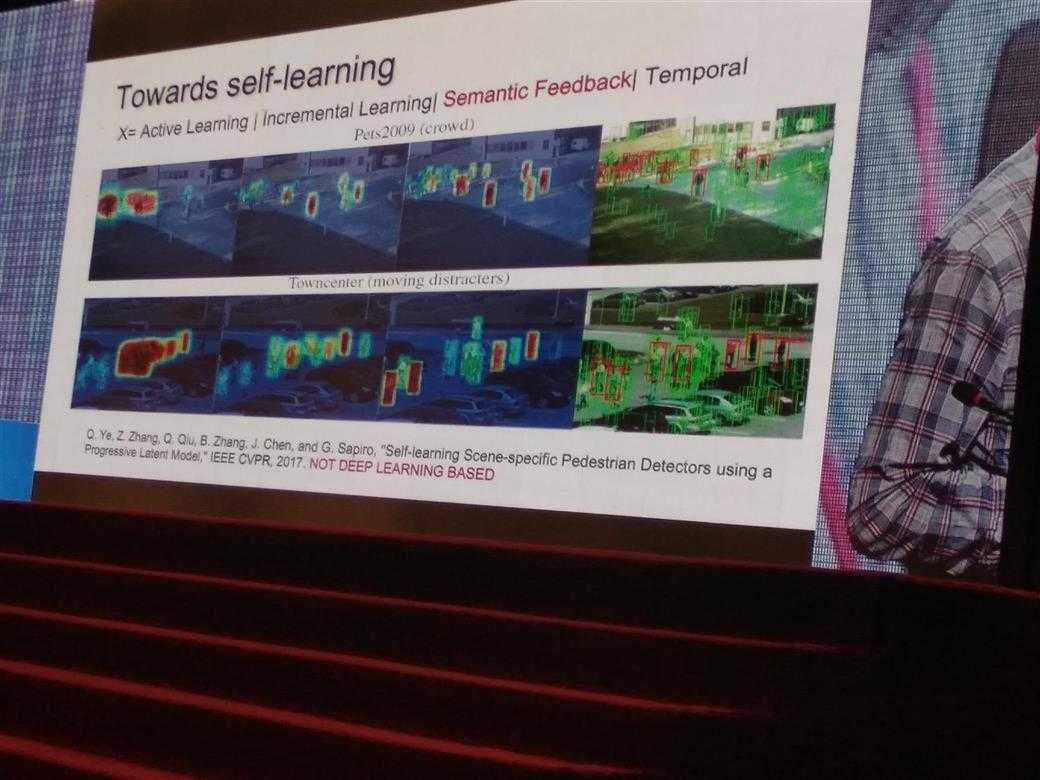

Towrad Self-Learning

Active Learning

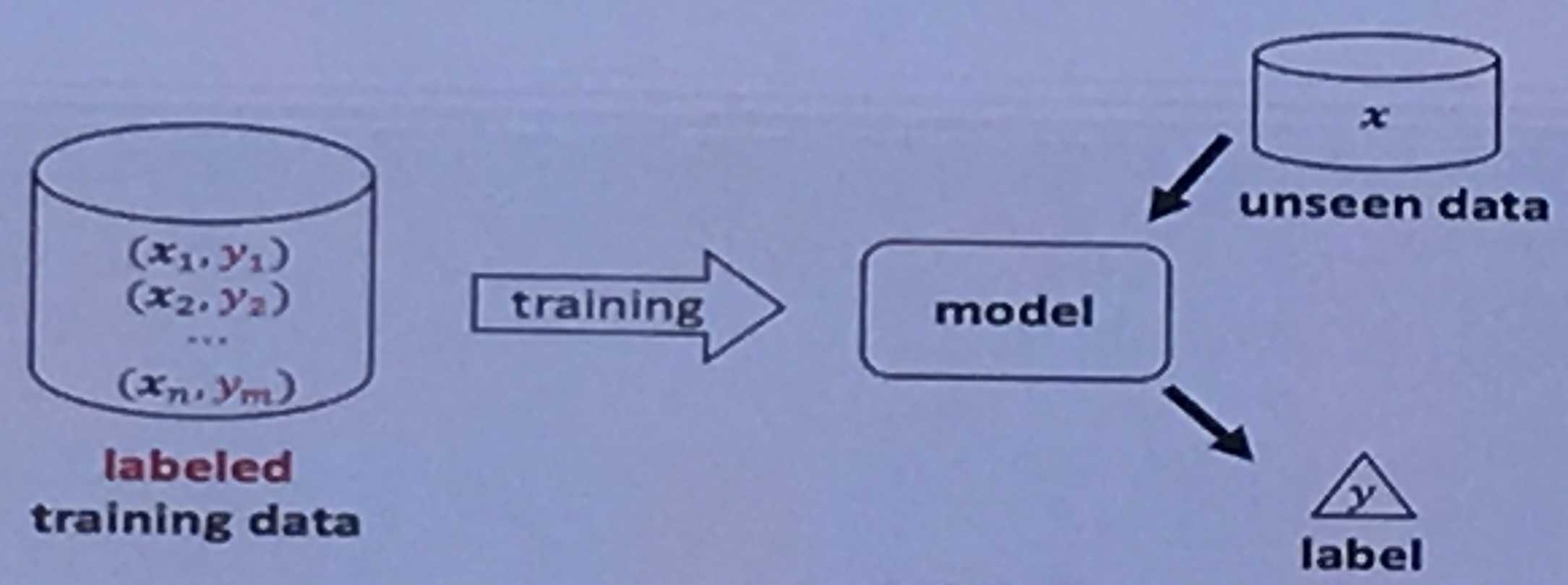

传统的有监督学习

问题在哪里?

大量的数据标记成本巨大,有一些甚至是不可得的(比如医院的患者信息,异常检测的异常样本,几年才发生一次异常)

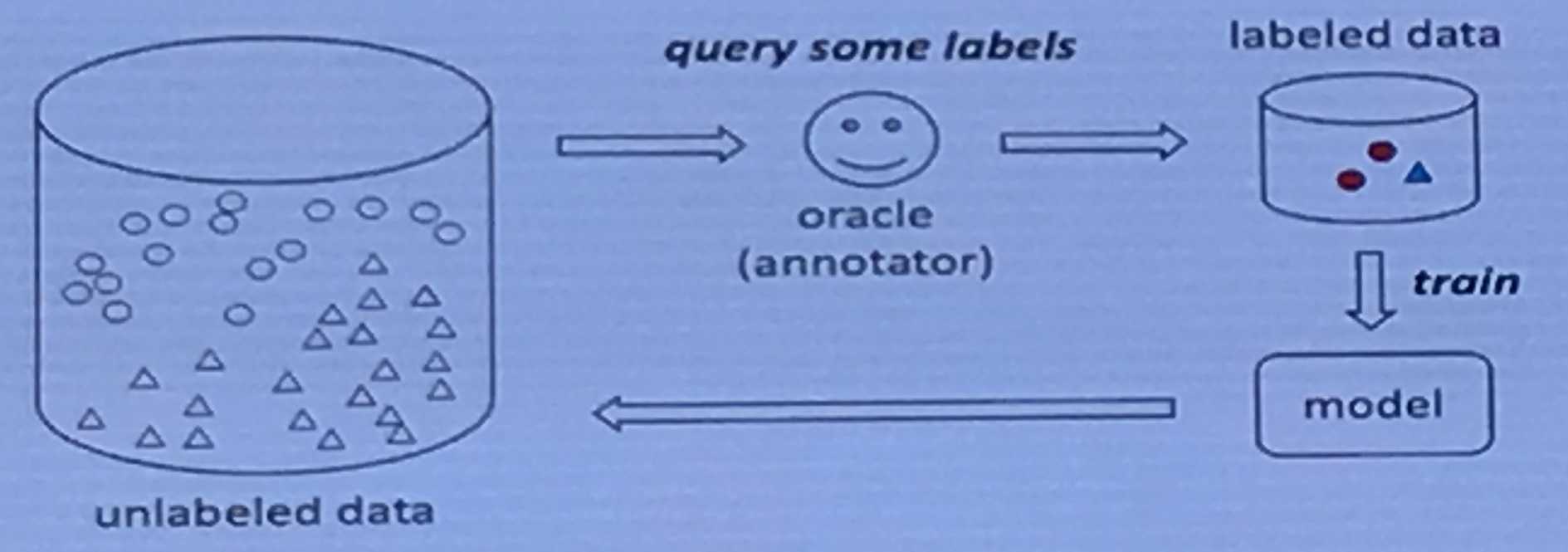

Active Learning

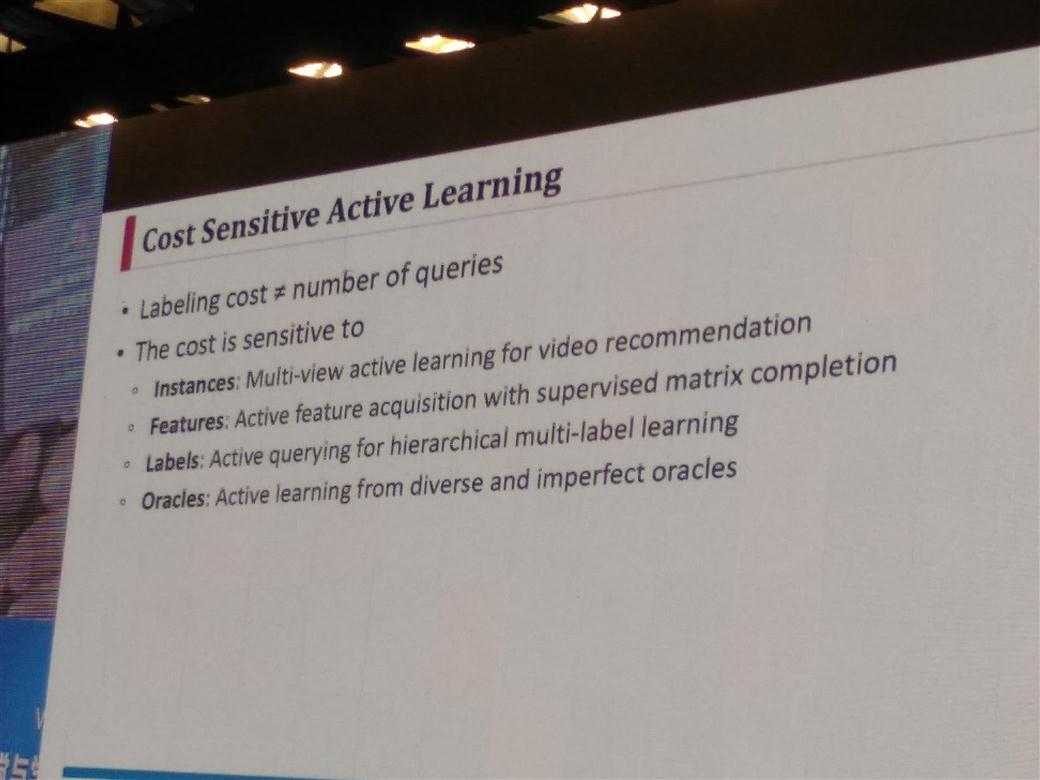

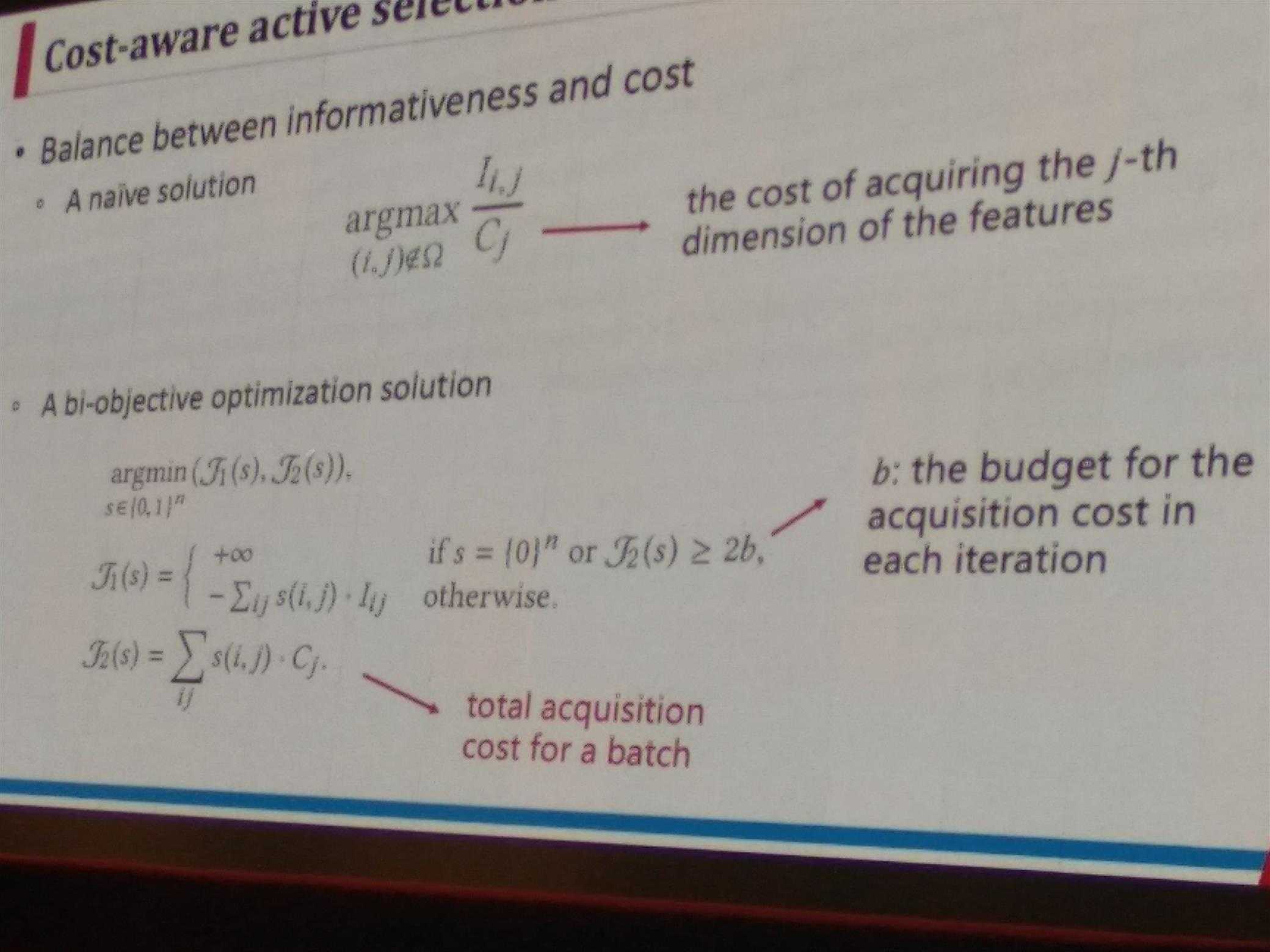

Cost Sensitive Active Learning

The cost is sensitive to (不是简单的 number of queries)

Instances | Features | Labels | Oracles

一个应用举例:用于视频推荐的多视角主动学习(multi-view active learning for video recommendation)

实例(instance):用于视频推荐的多视角主动学习

特征(feature):有监督矩阵补全的主动特征获取

标签(label):主动查询分层多标签学习代理(oracles):积极学习各种不完美的oracles

详细分析:

instances ——multi-view active learning for video recommendation

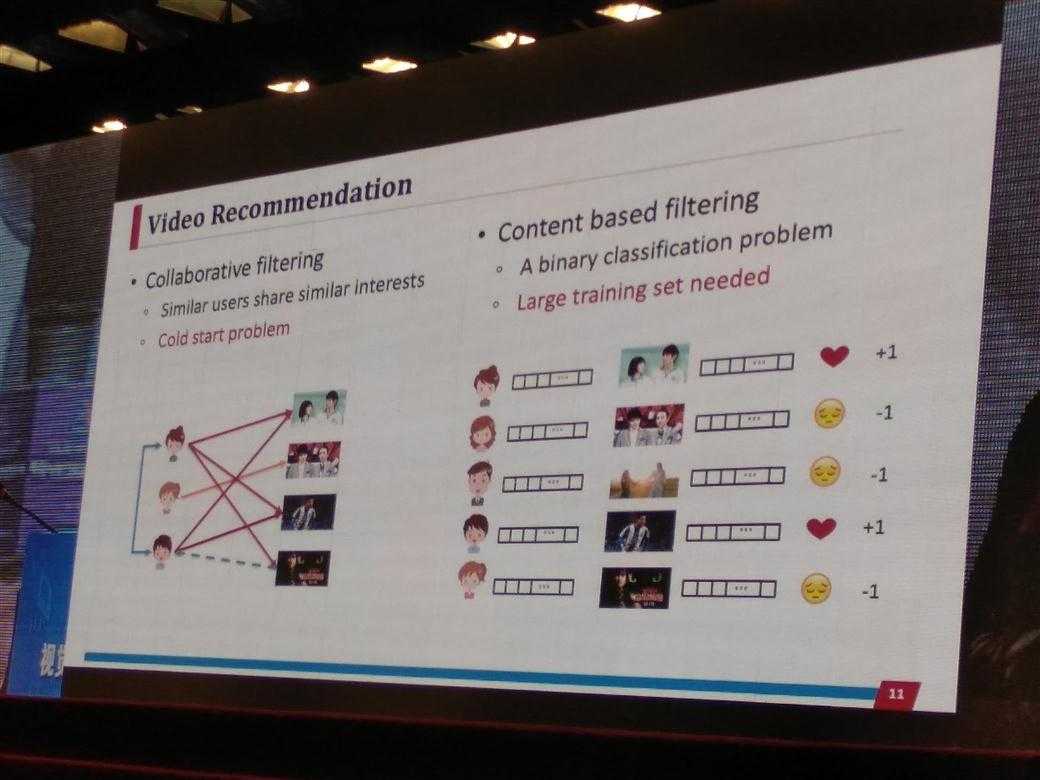

视频推荐:协同过滤(冷门启动问题)| 基于内容的过滤(需要大量数据训练)

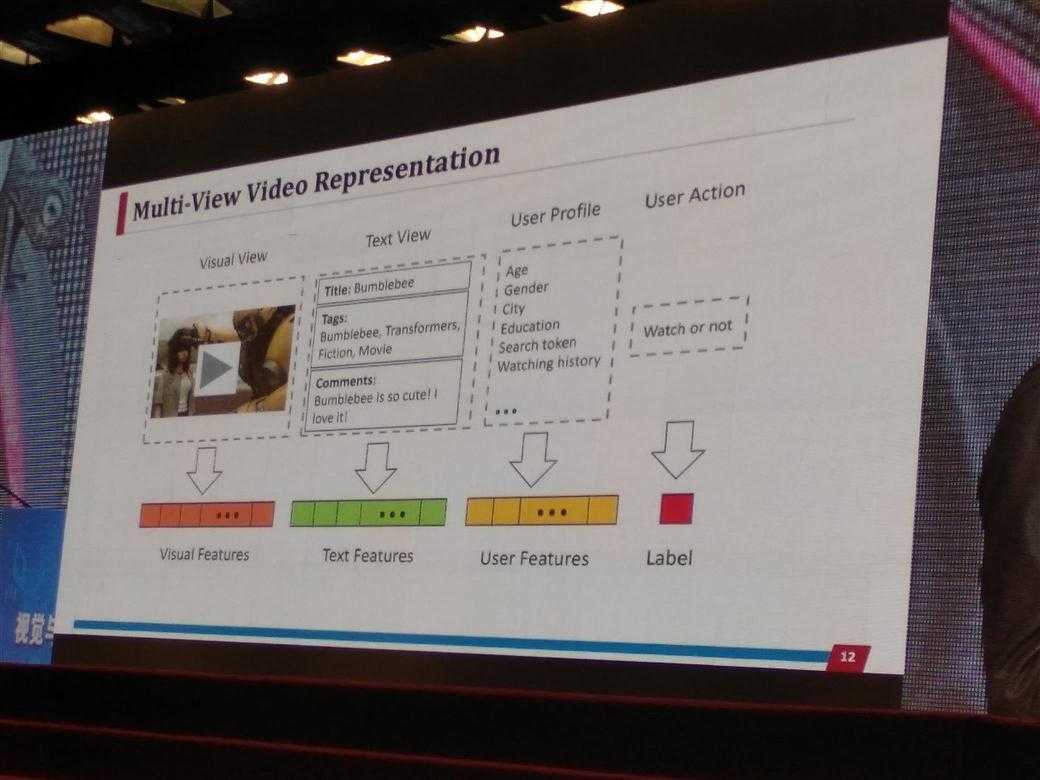

多视角视频表示:视觉特征、文本特征、用户特征、标签

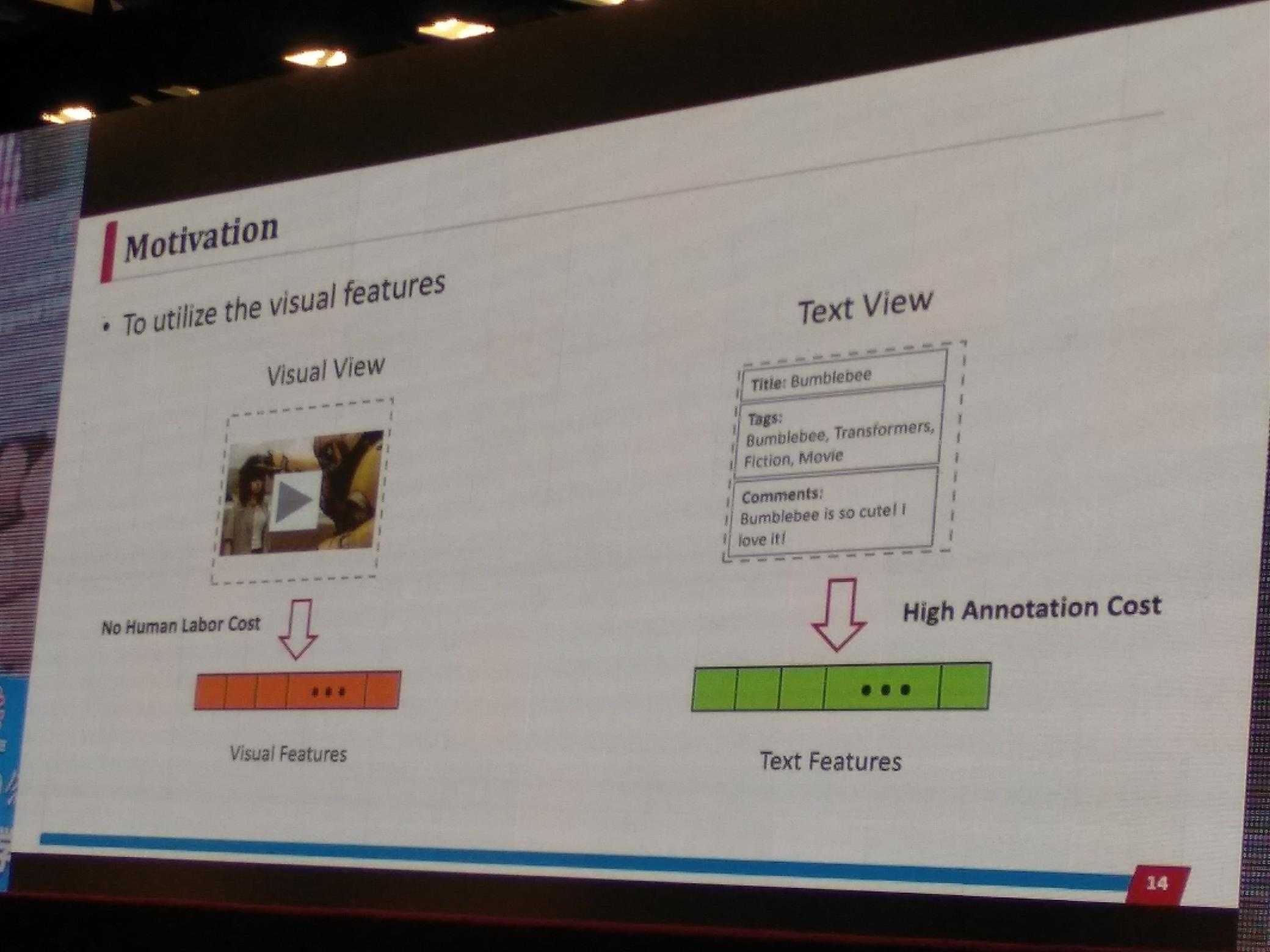

motivation:在视频推荐任务中,文本特征(即评论)获取需要很大代价,视觉特征不需要人力代价。

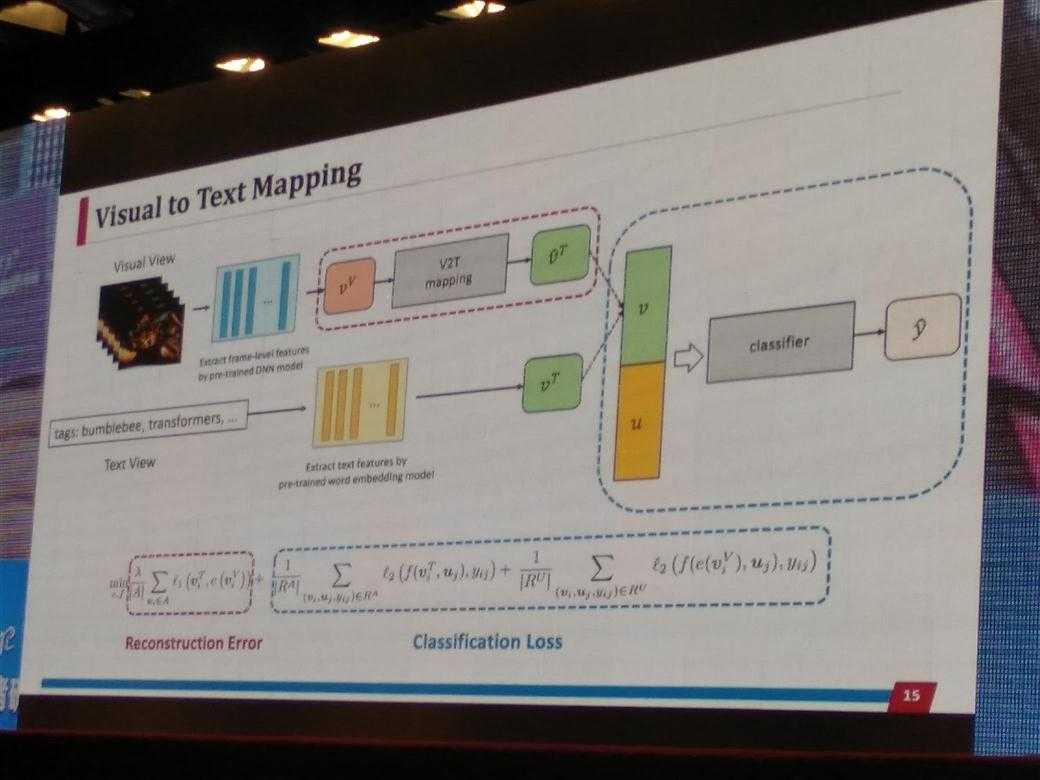

idea: Visual to text Mapping

如下图所示,

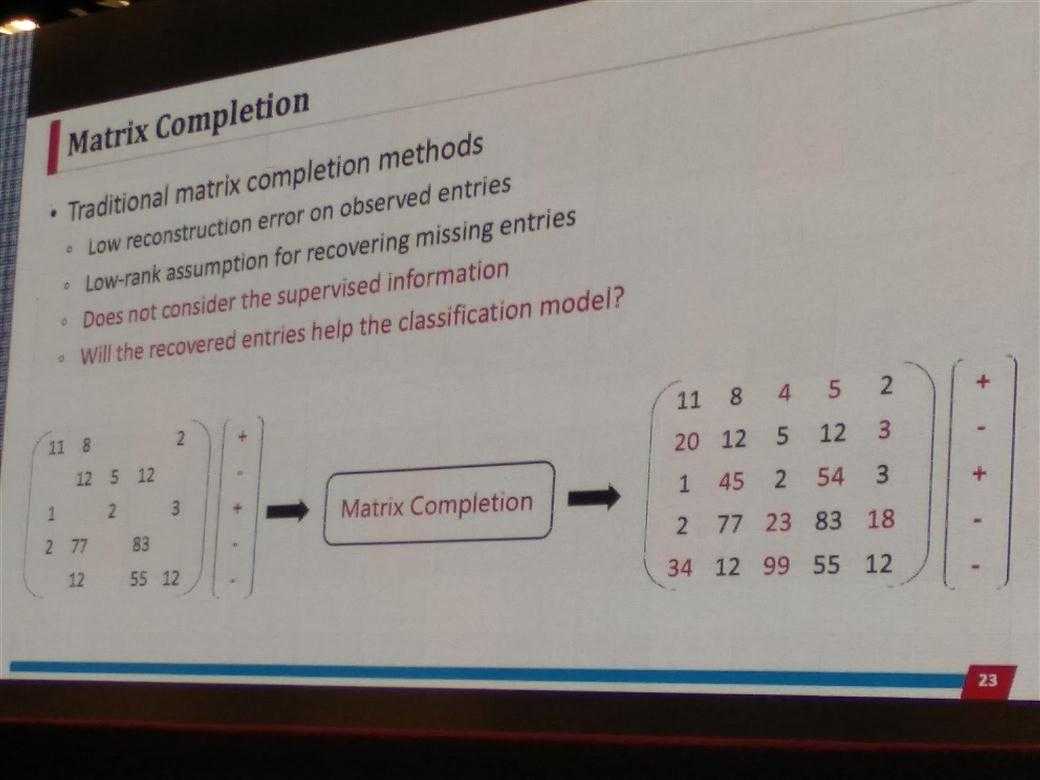

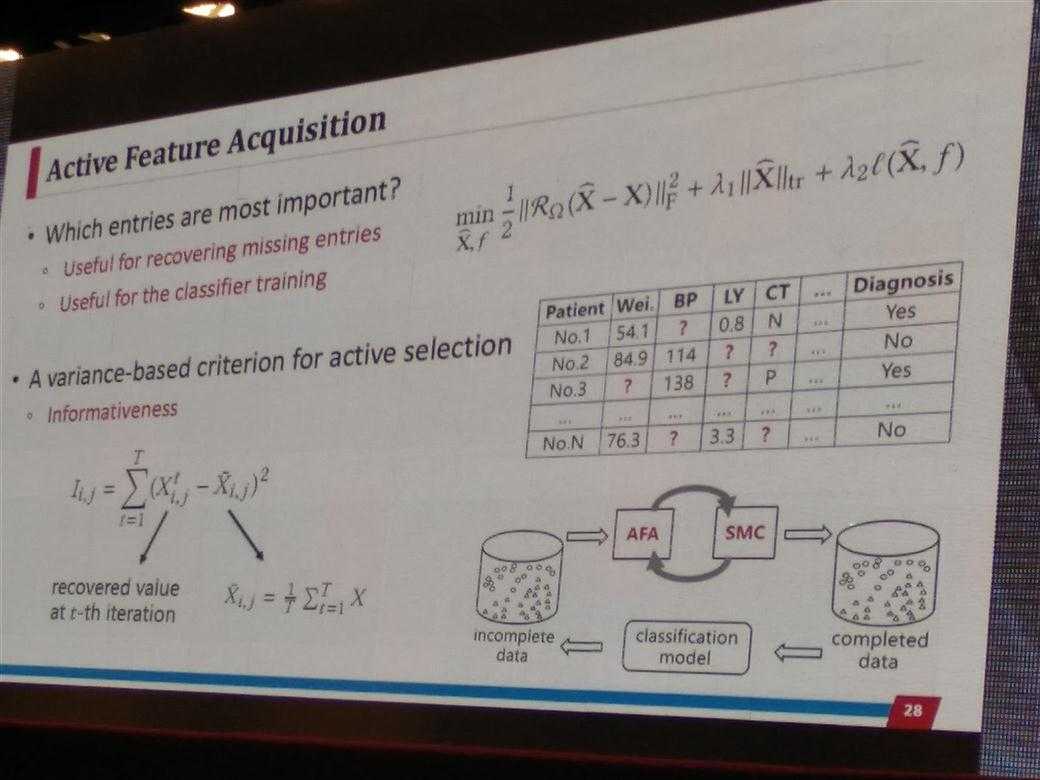

features——active feature acquisition with supervised matrix completion

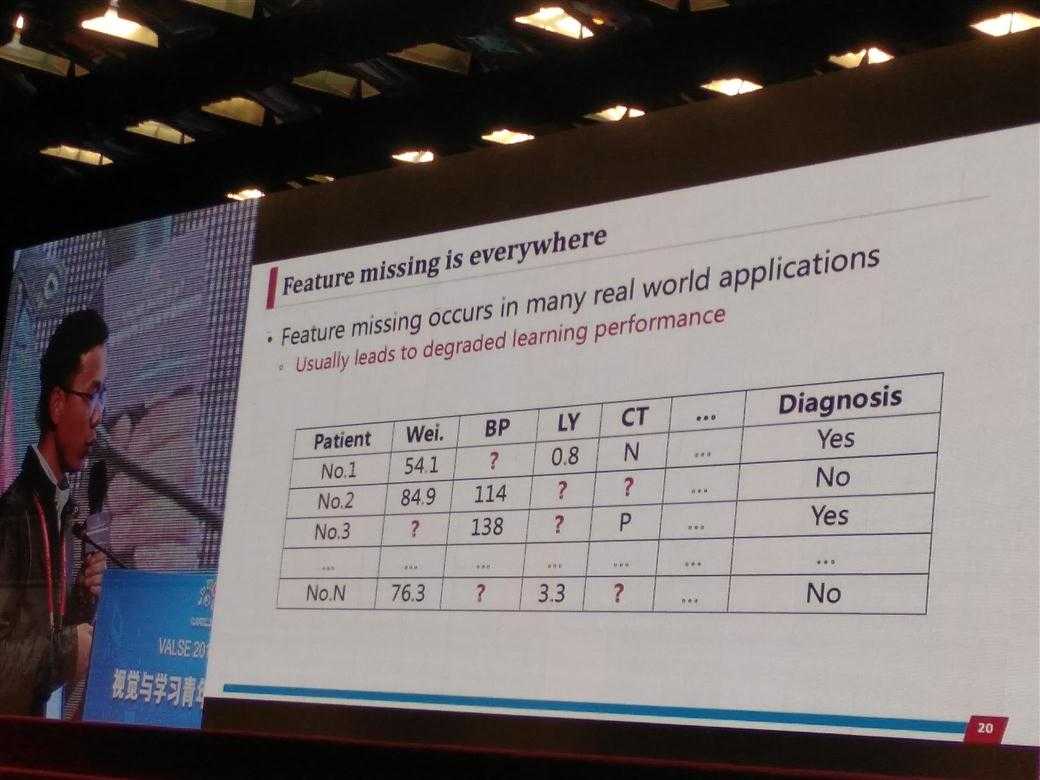

问题:现实应用中往往会出现特征丢失现象,通常导致学习性能下降

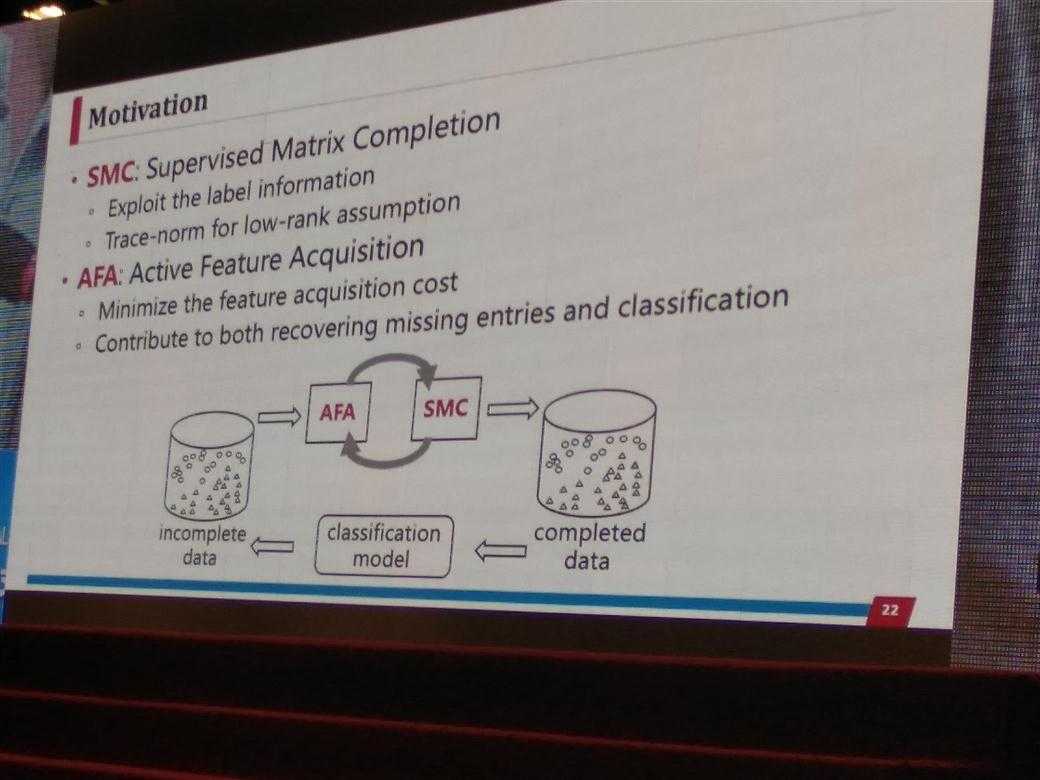

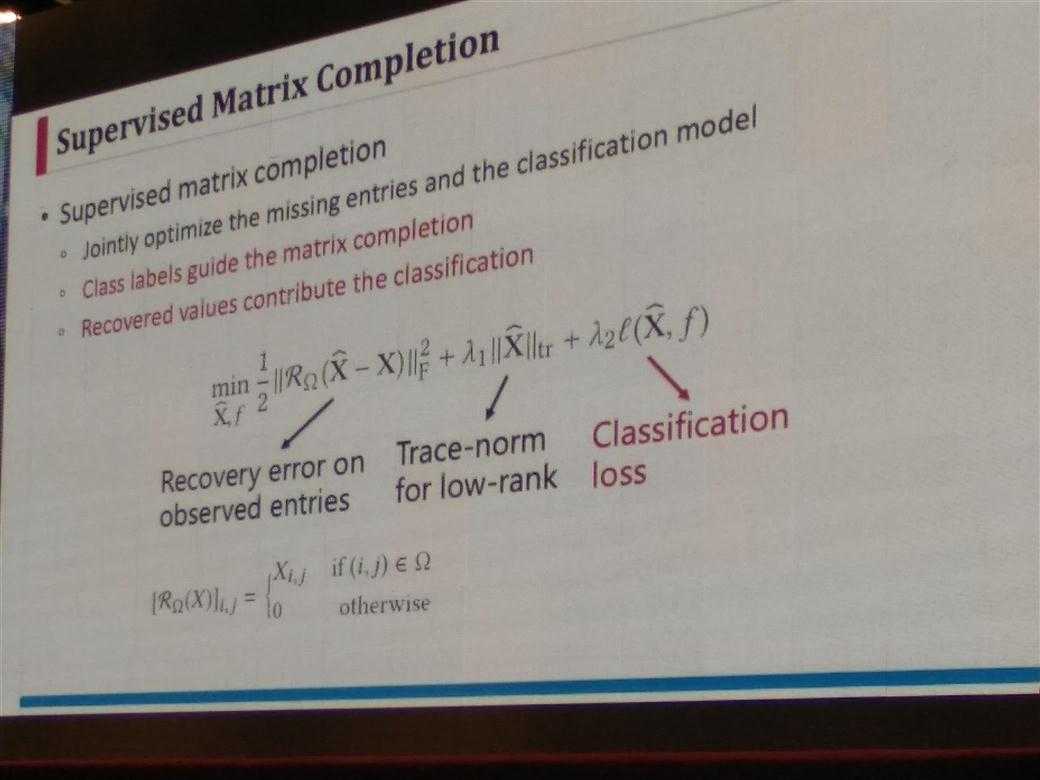

motivation: SMC——supervised matrix completion(exploit the label information / Trace norm for low-rank assumption)

如下图,

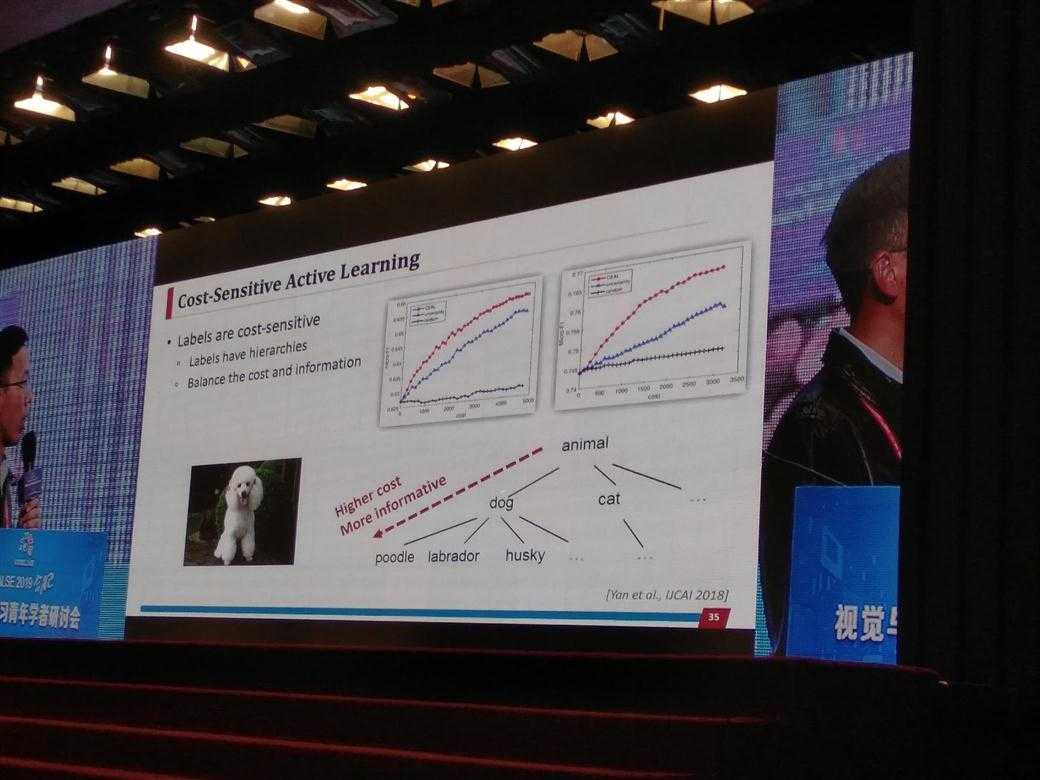

labels——active querying for hierarchical multi-label learning

标签有层次结构

平衡成本和信息

如下图,

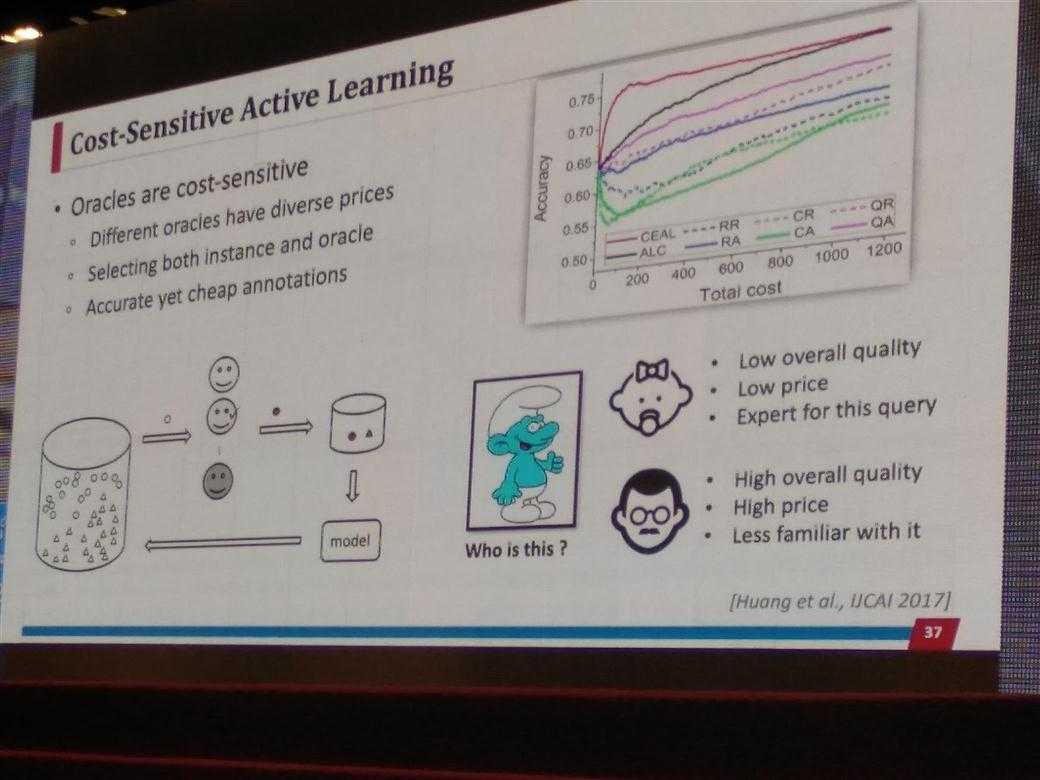

Oracles——active learning from diverse and imperfect oracles

不同的oracles有不同的价格

同时选择instance和oracle

准确而便宜的标签

如下图,

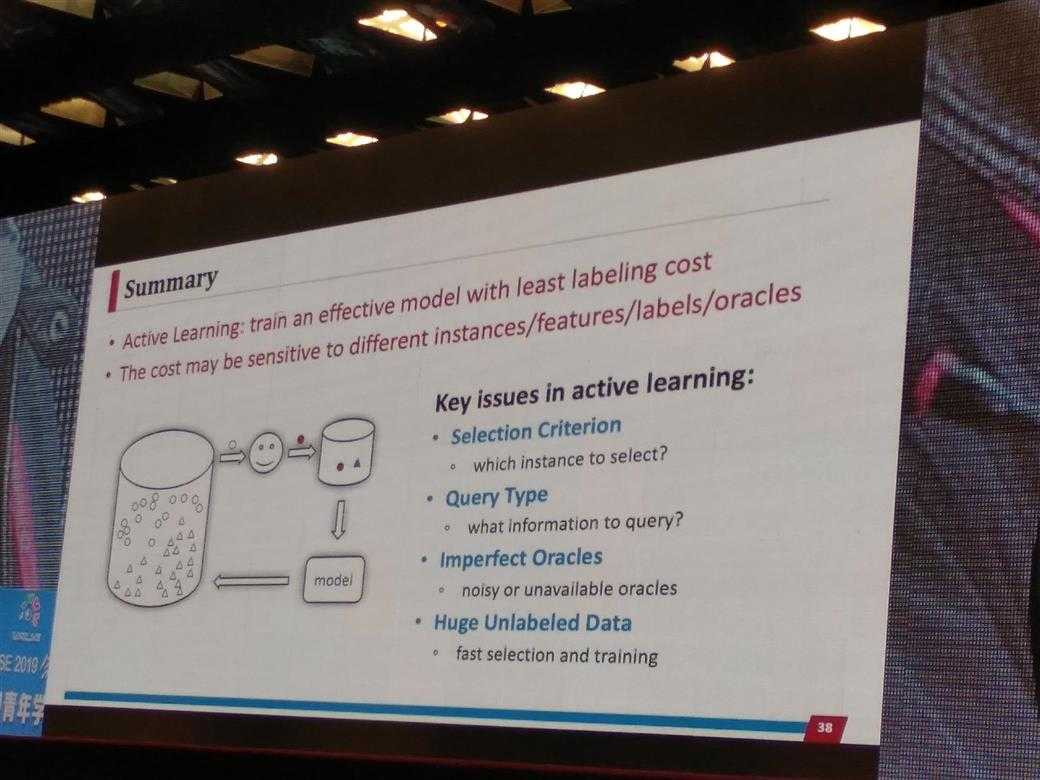

Summary:

Active Learning: train an effective model with least labeling cost

The cost may be sensitive to different instances/features/labels/oracles

Key issues in active learning

Selection Criterion

Query Type

Imperfect Oracles

Huge Unlabeled Data

如下图,

我之前关注过的关于 Active Learning的 zhihu link: link-1 link-2, link-3

引子:

Towards Weakly Supervised Object Segmentation & Scene Parsing

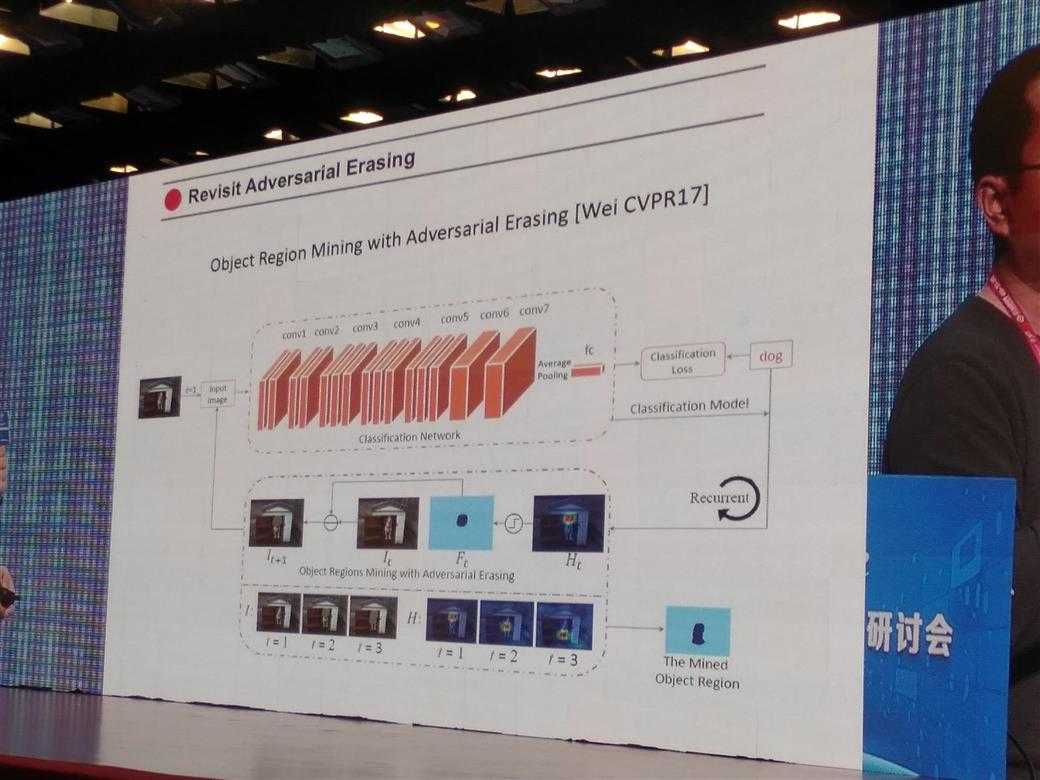

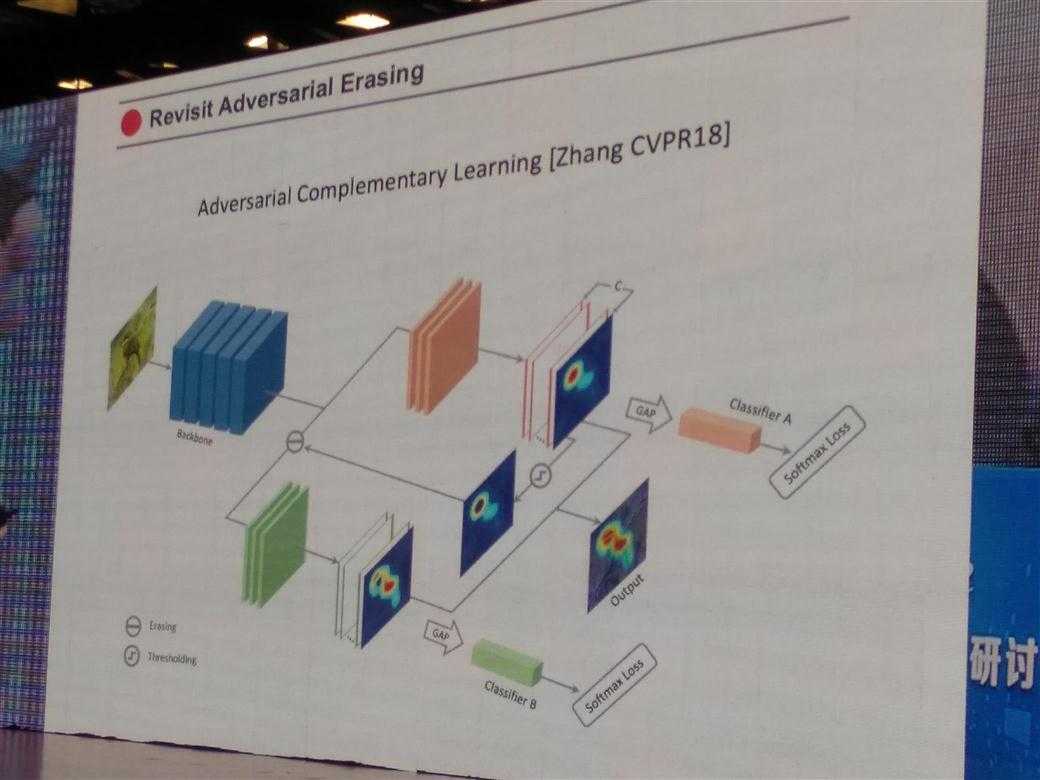

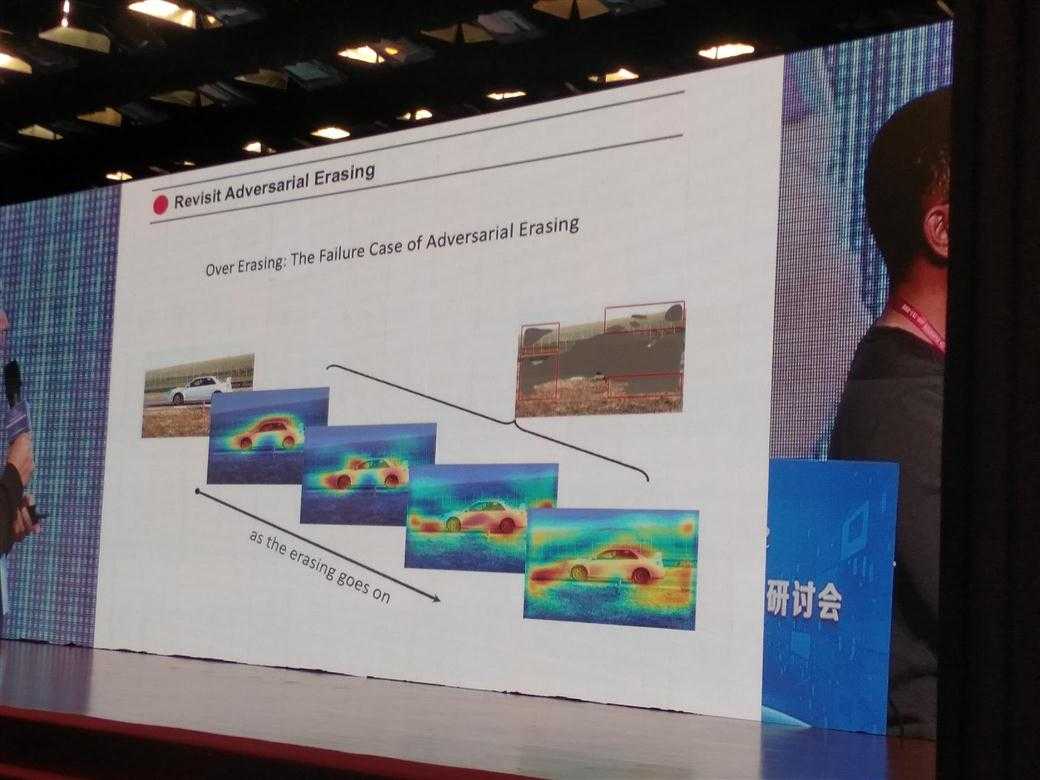

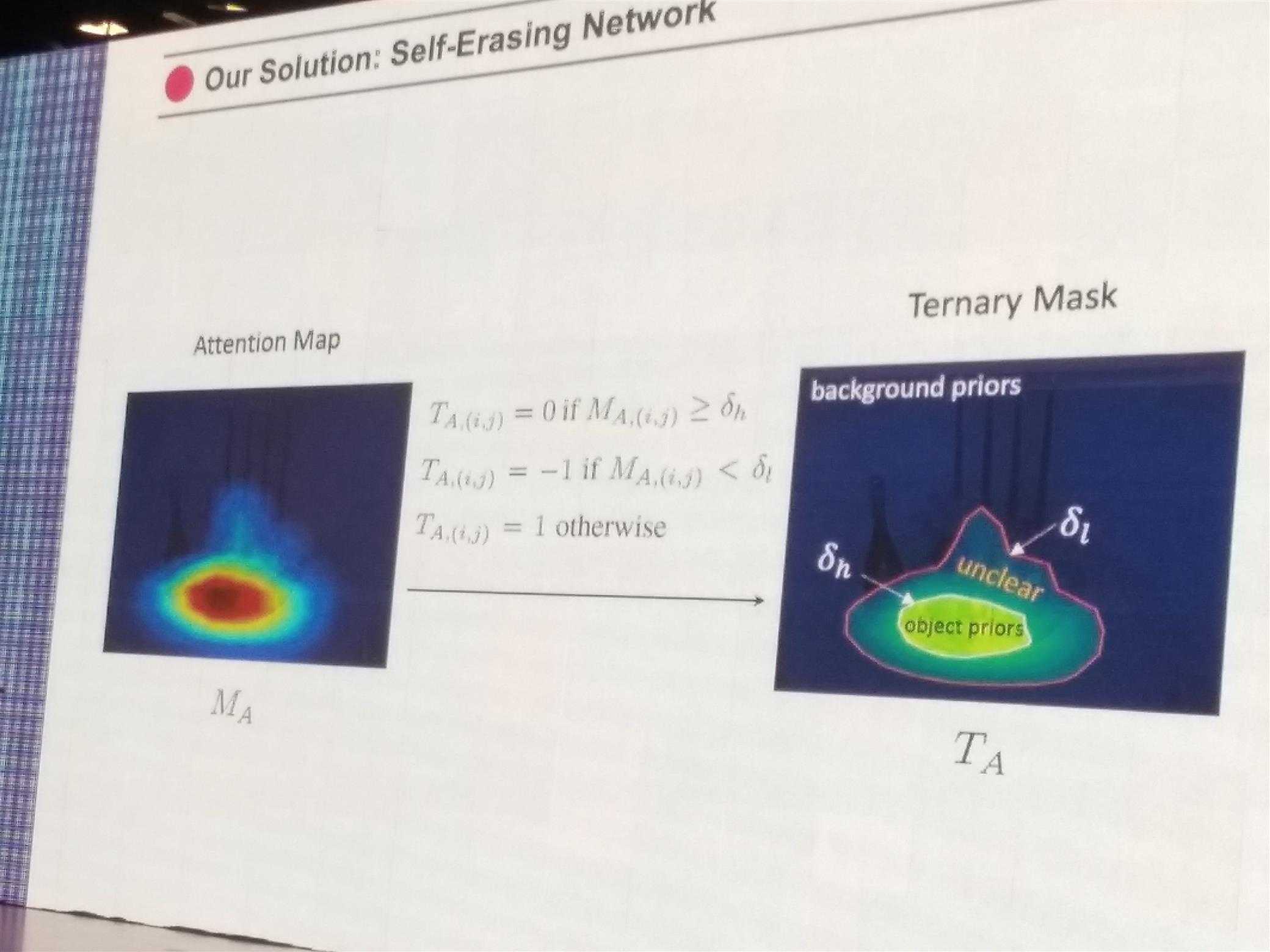

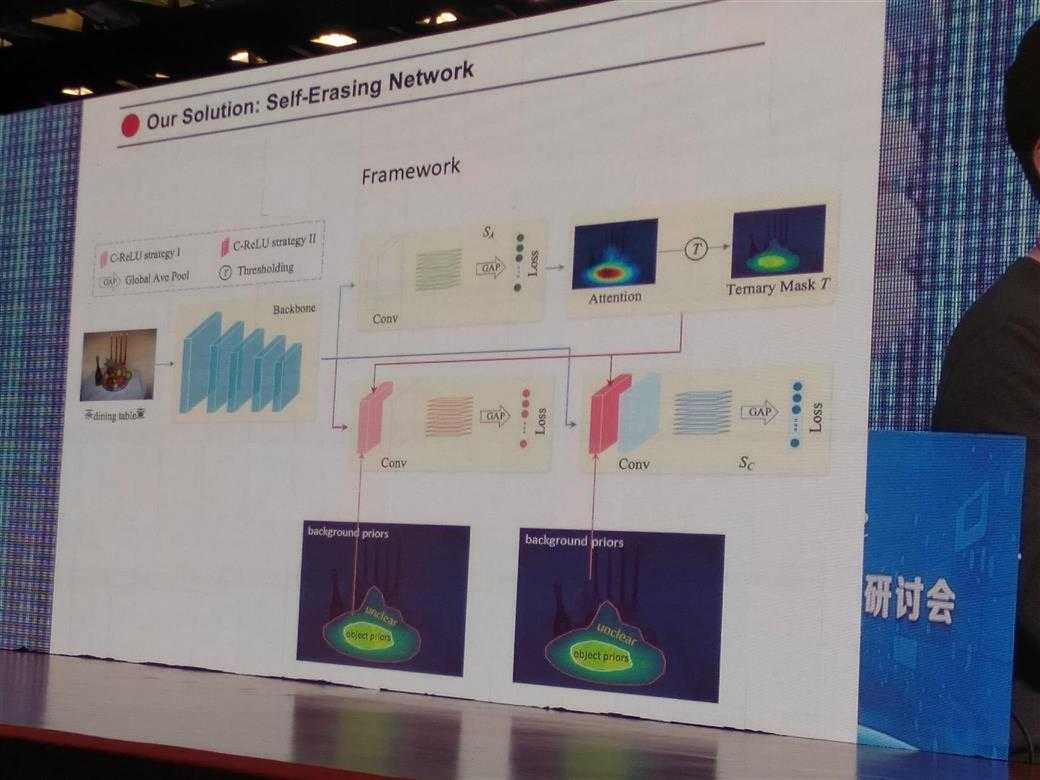

Revisit Adversarial Erasing

Object Region Mining with Adversarial Erasing (CVPR2017)

Adversarial Complementary Learning (Zhang CVPR2018)

Issue:Over Erasing: The Failure Case of Adversarial Erasing

如下图,

一篇论文:

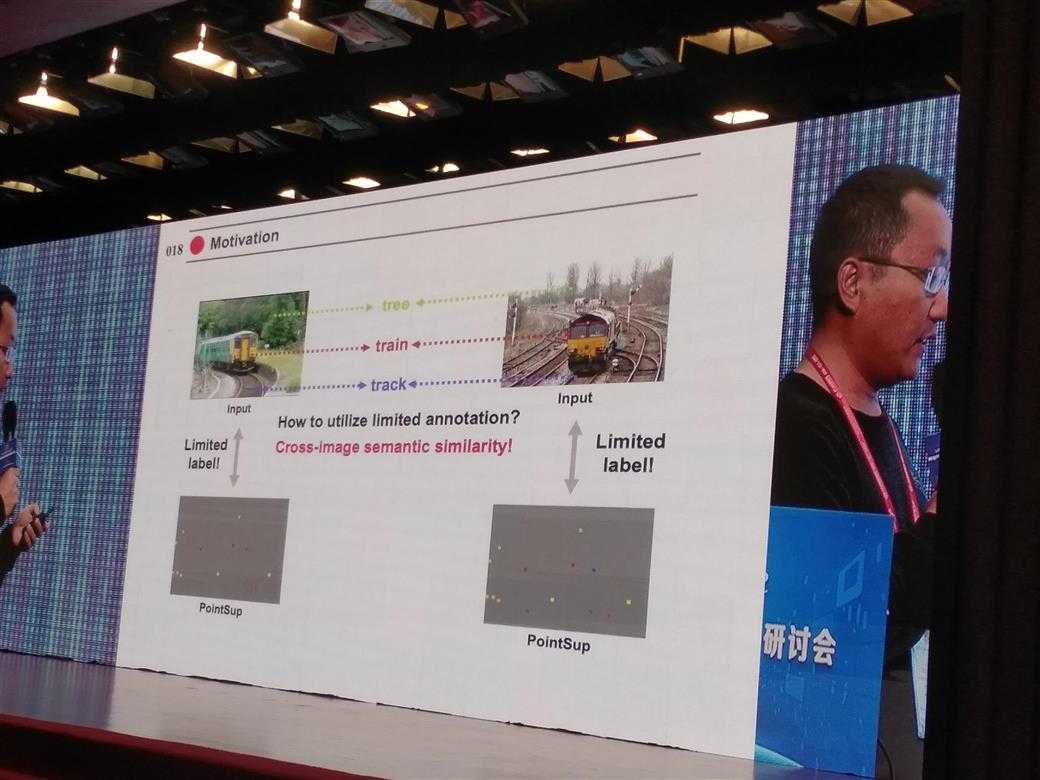

Weakly Supervised Scene Parsing with Point-based Distance Metric Learning (yunchao wei, CVPR)

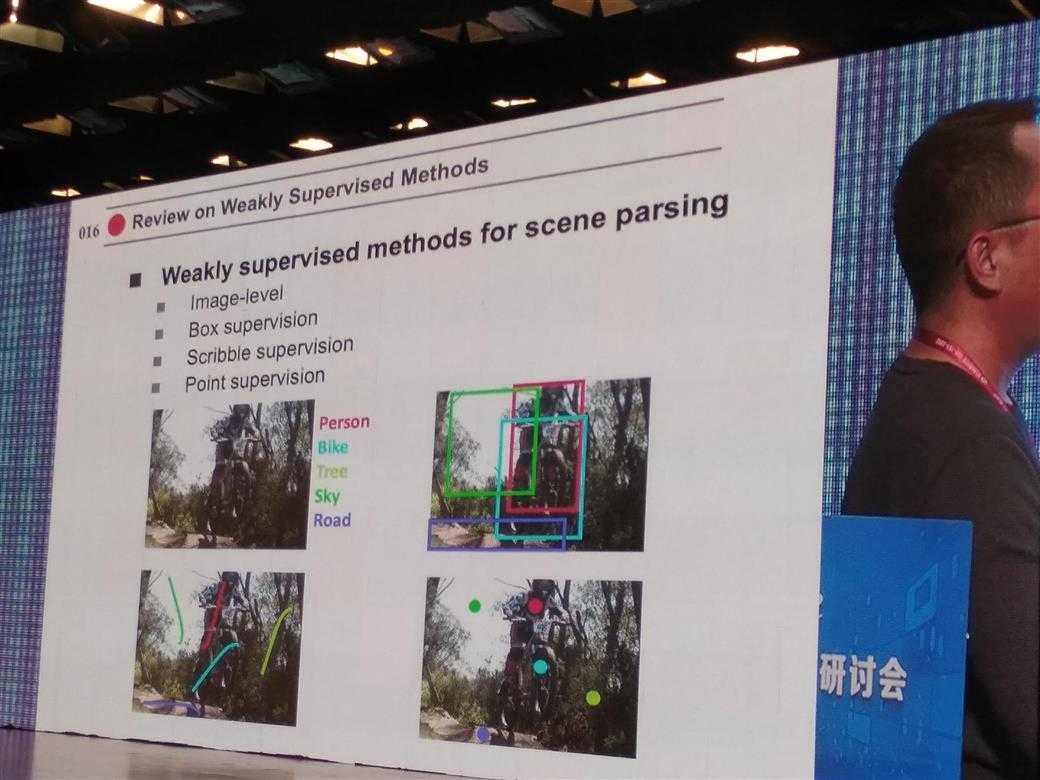

Weakly supervised methods for scene parsing

image-level labeling -> Box-level -> scribble-level -> point-level

如图,

wekaly的体现: point-based labeling than pixel-based labeling

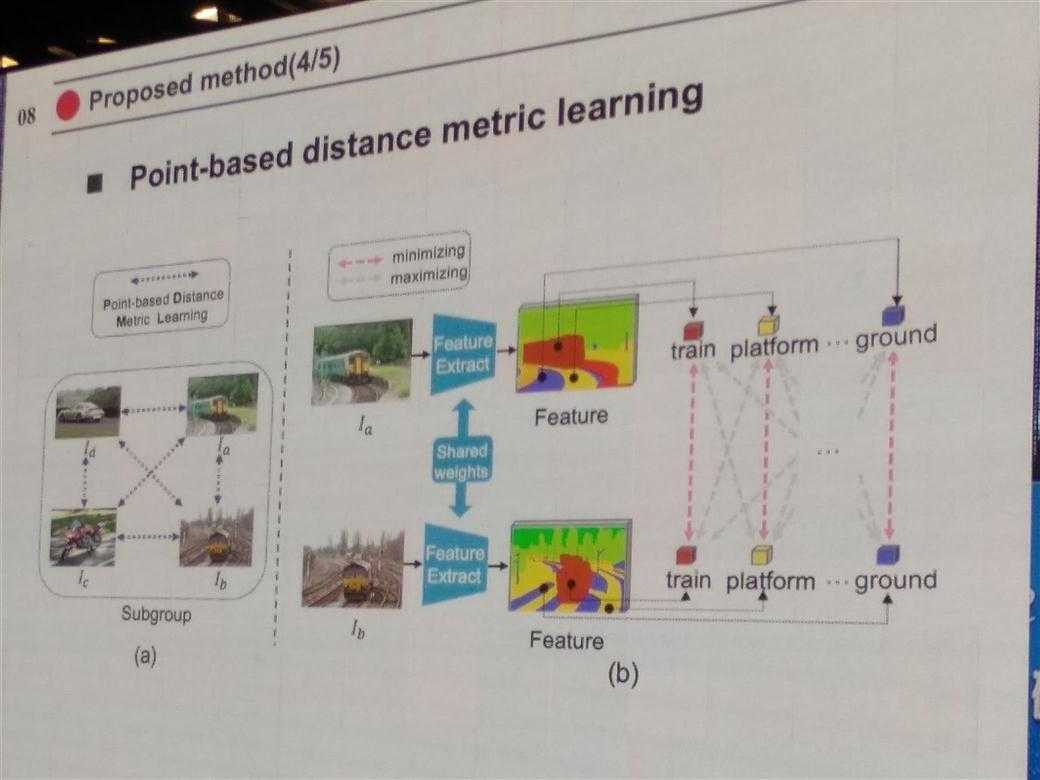

motivation: How to utillze limited annotation? 答:Cross-Image semantic similarity

如图,

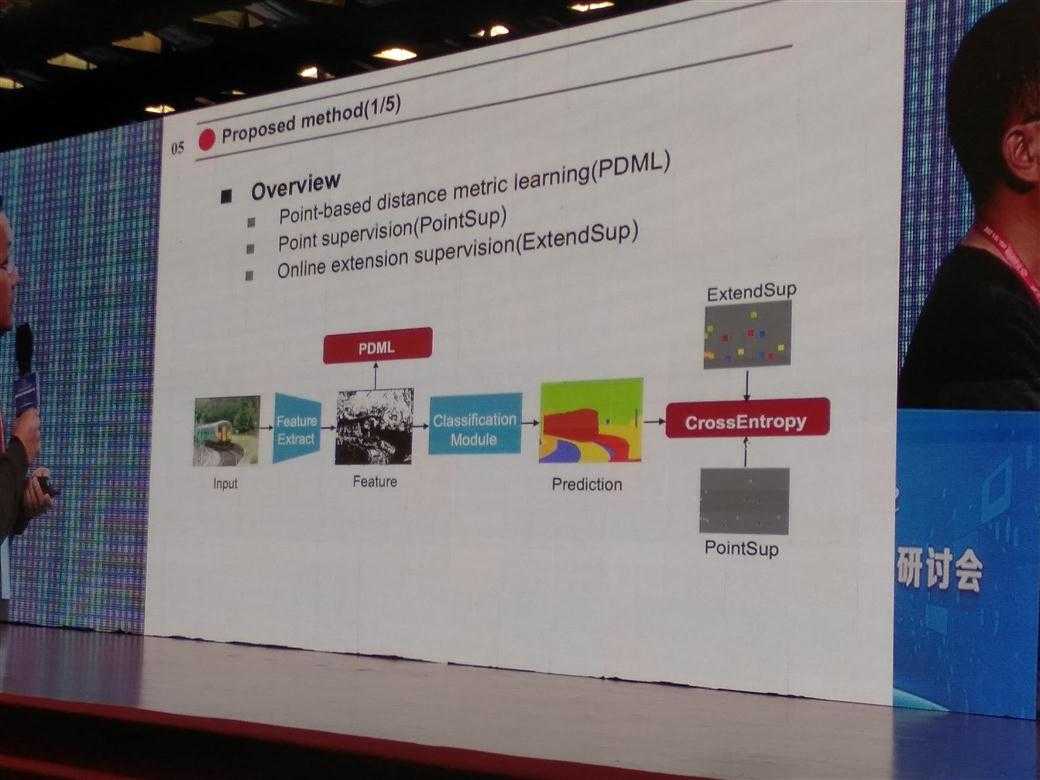

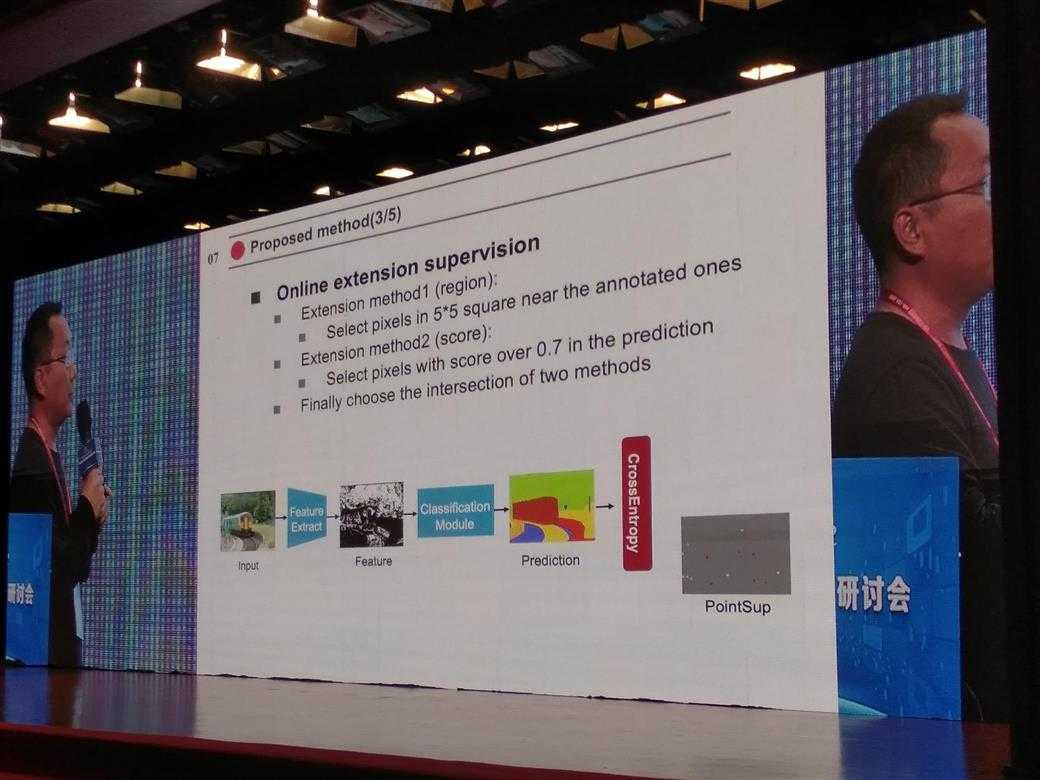

论文方法overview

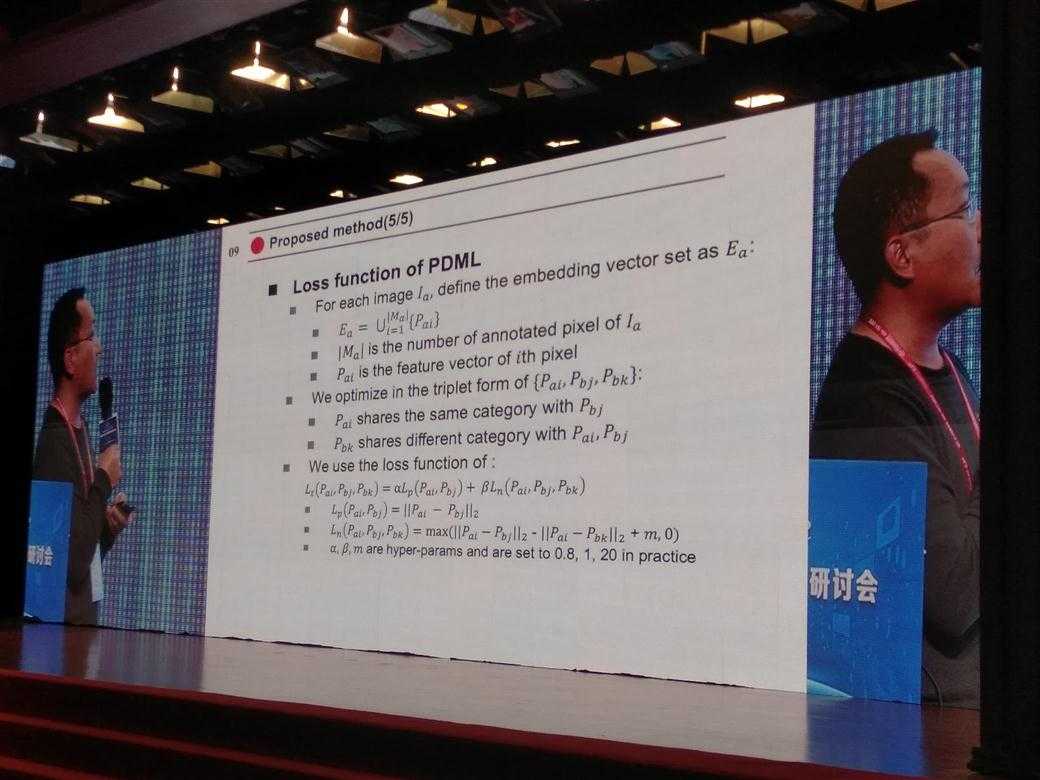

Point-based distance metric learning (PDML)

point supervision (PointSup)

Online extension supervision(ExtendSup)

如图,

Conclusion

叶齐祥的弱标记:

只给目标物体上画一条线,只在目标物体上打一个点,仅仅告诉模型一系列图片中包含什么而不给位置,让模型自己学习找到这些目标。

魏云超的擦除思想:

作者尝试直接使用预训练模型,找原图【使得预训练模型最后一个卷积层激活较大】的区域,然后发现在Image-Net上预训练模型虽然有很好的分类能力,但最后的激活层往往来自于原图中最有判别能力的部分而不是全部物体。举例:虽然预训练模型能将狗分类成狗,但是使得最后输出“狗”这个维度的激活最大的可能仅是狗头、狗腿这些比较discriminative的区域,而不是整个狗的instance segmentation,于是作者提出,将原图中最disciminative的区域擦掉(erase),然后再训练模型,如此反复,直到模型最后的激活来源于整个狗。

一些idea:

为了衡量图像和文本的相似度,将图像编码到文本的特征空间中,或者将文本编码到图像的特征空间中,以此衡量,而不是将二者编码到第三个特征空间中衡量

设计好的loss是发表论文的好方法

待看blog:

原文:https://www.cnblogs.com/LS1314/p/10885026.html