在爬虫中cookie是非常有用的,可以解决反爬,封号等问题。接下来我们来说说获取cookie的集中方式。

这里采用python2.7,本来我都是用python3.6的,来了公司之后,公司适用版本2.7,就2.7咯,反正就写法上面有一些区别

第一种:mechanize

首先我们要使用mechanize,第一步:

pip install mechanize

第二步编写获取cookie代码:

import os import mechanize import cookielib,re br = mechanize.Browser() cj = cookielib.LWPCookieJar() br.set_cookiejar(cj) br.set_handle_equiv(True) br.set_handle_gzip(True) br.set_handle_redirect(True) br.set_handle_referer(True) br.set_handle_robots(False) br.set_handle_refresh(mechanize._http.HTTPRefreshProcessor(), max_time=1) br.set_debug_http(True) br.addheaders = [(‘User-agent‘, ‘用户ua‘)] br.set_proxies({"http": "代理"}) response = br.open(‘https://www.amazon.com‘) cj = br._ua_handlers[‘_cookies‘].cookiejar for cookie in cj: print("cookieName:"+cookie.name) print("cookieValue:"+cookie.value) cookie = [item.name + ":" + item.value for item in cj] cookiestr={} for item in cookie: name,value = item.split(":") cookiestr[name]=value

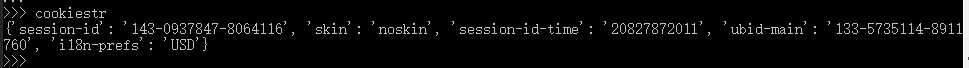

运行结果:

第二种:urllib

import urllib2 import cookielib from http import cookiejar from bs4 import BeautifulSoup User_Agent = ‘Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36‘ header = {} header[‘User-Agent‘] = User_Agent cookie = cookiejar.CookieJar() cookie_handle=urllib2.HTTPCookieProcessor(cookie) cookie_opener = urllib2.build_opener(cookie_handle) # proxy_support = urllib2.ProxyHandler({"http":"5.62.157.47:8085"}) # proxy_opener = urllib2.build_opener(proxy_support) urllib2.install_opener(cookie_opener) # urllib2.install_opener(proxy_opener) request = urllib2.Request("https://www.amazon.com",headers=header) response = urllib2.urlopen(request) for item in cookie: print(‘Name = ‘ +item.name) print(‘Value =‘ +item.value)

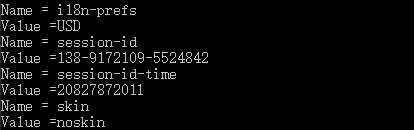

运行结果:

第三种:selenium(个人感觉这个虽然加载比较慢,但是获取cookie最全)

pip install selenium

代码:

from selenium import webdriver driver = webdriver.Chrome(executable_path=‘d:/seop/chromedriver.exe‘) driver.get("https://www.amazon.com") #for c in cookiestr.keys(): # driver.add_cookie({‘name‘:c,‘value‘:cookiestr[c]}) #driver.get("https://www.amazon.com") cookie = [item["name"] + "=" + item["value"] for item in driver.get_cookies()] cookiestr = ‘;‘.join(item for item in cookie)

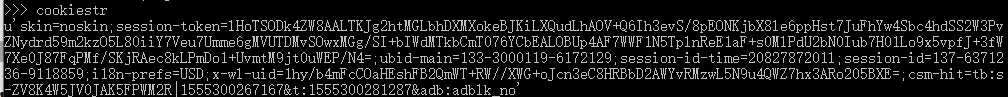

运行结果:

第四种:chrome headless 使用无头浏览器来获取

这个目前我是在centos上面进行操作:

第一步:肯定你要安装chrome啦

第二步:运行安装脚本

curl https://intoli.com/install-google-chrome.sh | bash

测试是否成功: 运行以下命令,如果成功会在当前目录下面保存百度的截图

google-chrome-stable --no-sandbox --headless --disable-gpu --screenshot https://www.baidu.com

这里我们开始获取cookie信息

first:

google-chrome-stable --no-sandbox --headless --disable-gpu --user-data-dir="$HOME/Library/Application Support/Google/Chrome/" --remote-debugging-port=9222 https://www.amazon.com

second: 这里我们主要是获取websocket的url

curl -s localhost:9222/json

third:

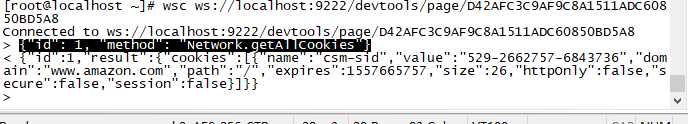

wsc ws://localhost:9222/devtools/page/D42AFC3C9AF9C8A1511ADC60850BD5A8

然后输入:

{"id": 1, "method": "Network.getAllCookies"}

最后cookie结果:

目前尝试了mechanize、urllib、selenium、headless chrome(以上四个贴了相关的代码以及操作)

requests、htmlunit、phantomjs、scrapy(后面也测试了这四个,发现获取的结果几乎差不多,selenium获取比较全的cookie信息,这里就没贴代码)

目前已经尝试了以上八种,个人觉得还是selenium获取cookie比较全面,经过这两天的研究cookie,就是selenium获取cookie的速度比较慢,看看还有没啥办法优化速度,继续查阅别的方式来获取cookie。

原文:https://www.cnblogs.com/zhe-hello/p/10709897.html