spark版本:1.6.1

scala版本:2.10

问题呢场景:

在idea调试本地程序的时候创建hiveContext报错,上午的时候是没有这个问题的,下午在项目中写了一个小deamon,出现了而这个问题,下面是我的代码:

import cn.com.xxx.common.config.SparkConfig

import org.apache.spark.sql.hive.HiveContext

object test{

def main(args: Array[String]): Unit = {

SparkConfig.init("local[2]", this.getClass.getName)

val sc = SparkConfig.getSparkContext()

sc.setLogLevel("WARN")

val hqlContext = new HiveContext(sc)

println("hello")

sc.stop()

}

}

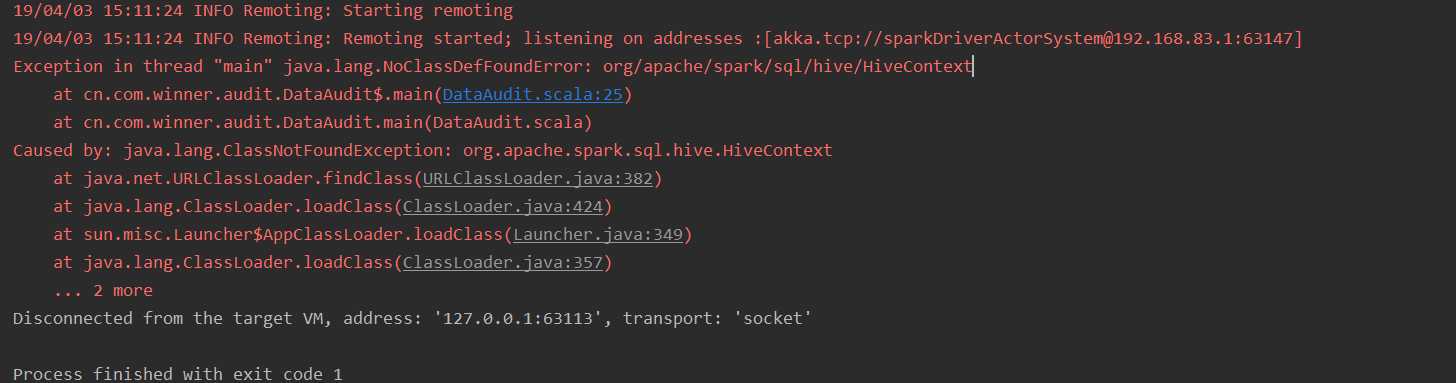

报错:

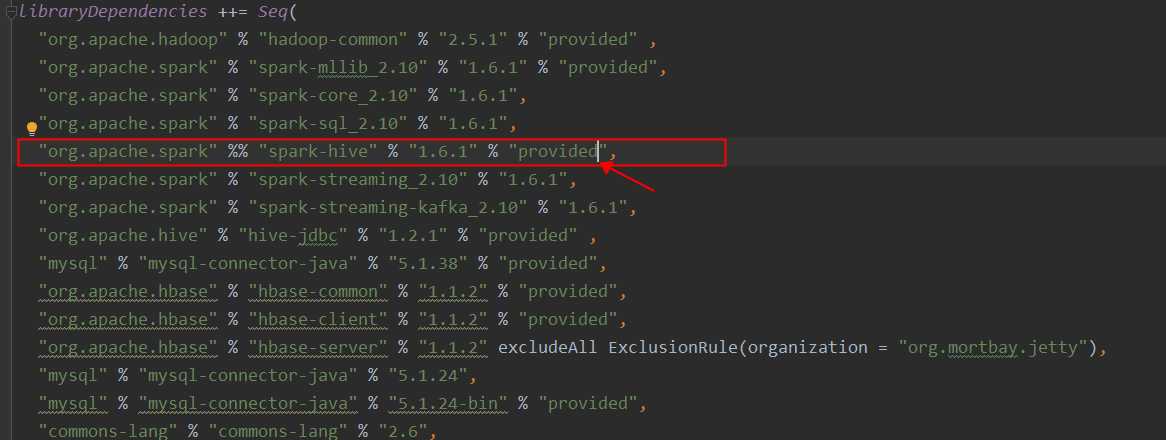

苦恼了一早晨,开始是以为我的依赖包没有下载,但是查看我的sbt的中的built.sbt文件中是有这个包的,跟踪源码,找度娘,等等,最终找到问题,最后定位到问题,是因为这个spark-hive依赖包的类型设置错误了:

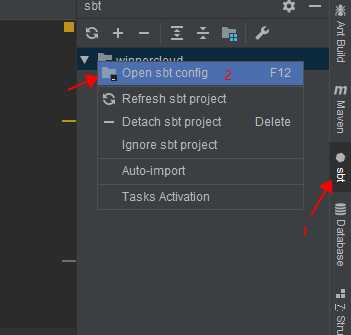

顺便说一下,idea中我是怎么找到built.sbt文件的:

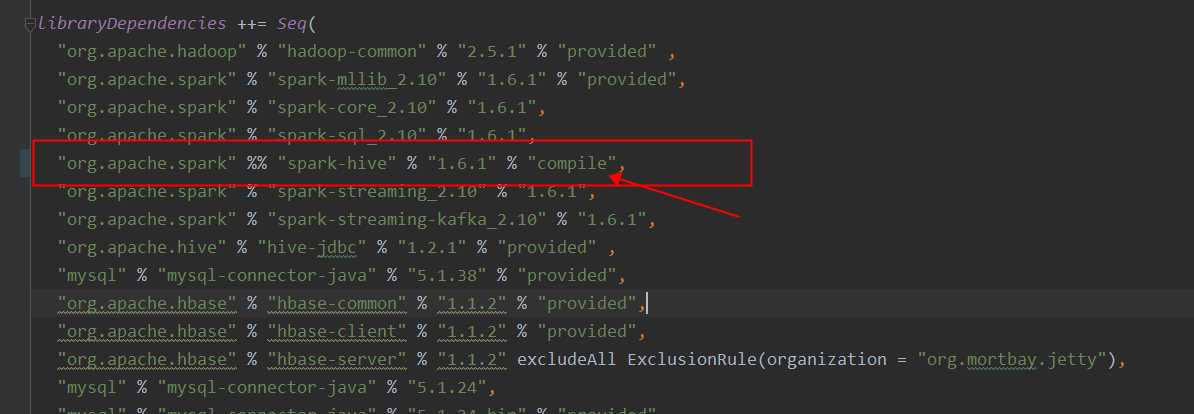

罪魁祸首就是这个单词,需要将这里改为"compile",如下图:

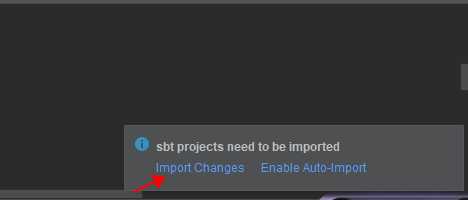

,然后,点击右下角出现的提示,import:

等待更新结束之后,然后在此进行编译,成功

大坑啊,这里记录一下,防止以后再次遇到

idea在本地调试,spark创建hiveContext的时候报错

原文:https://www.cnblogs.com/Gxiaobai/p/10649035.html