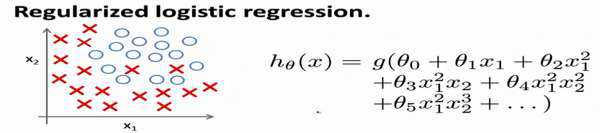

针对逻辑回归问题,我们在之前的课程已经学习过两种优化算法:我们首先学习了使用

梯度下降法来优化代价函数??(??),接下来学习了更高级的优化算法,这些高级优化算法需要

你自己设计代价函数??(??)。

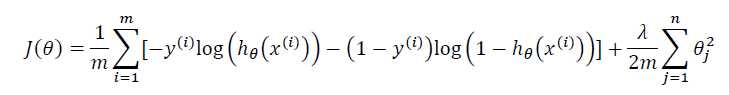

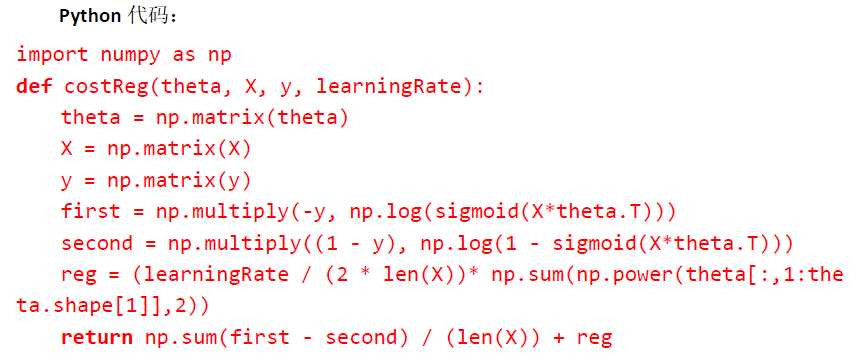

自己计算导数同样对于逻辑回归,我们也给代价函数增加一个正则化的表达式,得到代

价函数:

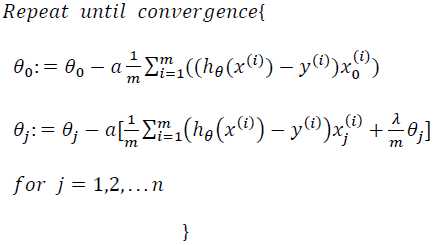

要最小化该代价函数,通过求导,得出梯度下降算法为:

注:看上去同线性回归一样,但是知道 ??? (??) = ??(??????),所以与线性回归不同。

注意:

1. 虽然正则化的逻辑回归中的梯度下降和正则化的线性回归中的表达式看起来一样,

但由于两者的??? (??)不同所以还是有很大差别。

2. ??0不参与其中的任何一个正则化。

吴恩达机器学习笔记22-正则化逻辑回归模型(Regularized Logistic Regression)

原文:https://www.cnblogs.com/sl0309/p/10402920.html