1:下载hadoop2.7.3并解压

2:配置hadoop2.7.3环境变量

HADOOP_HOME

%HADOOP_HOME%\bin

3:下载hadoop-eclipse-plugin插件

网址:https://github.com/winghc/hadoop2x-eclipse-plugin

4:添加hadoop.dll和winutils.exe到hadoop解压目录的bin目录下面

hadoop.dll和winutils.exe 在hadoop-eclipse-plugin目录里面

5:将hadoop-eclipse-plugin-2.7.3.jar拷贝到eclipse的plugin目录中

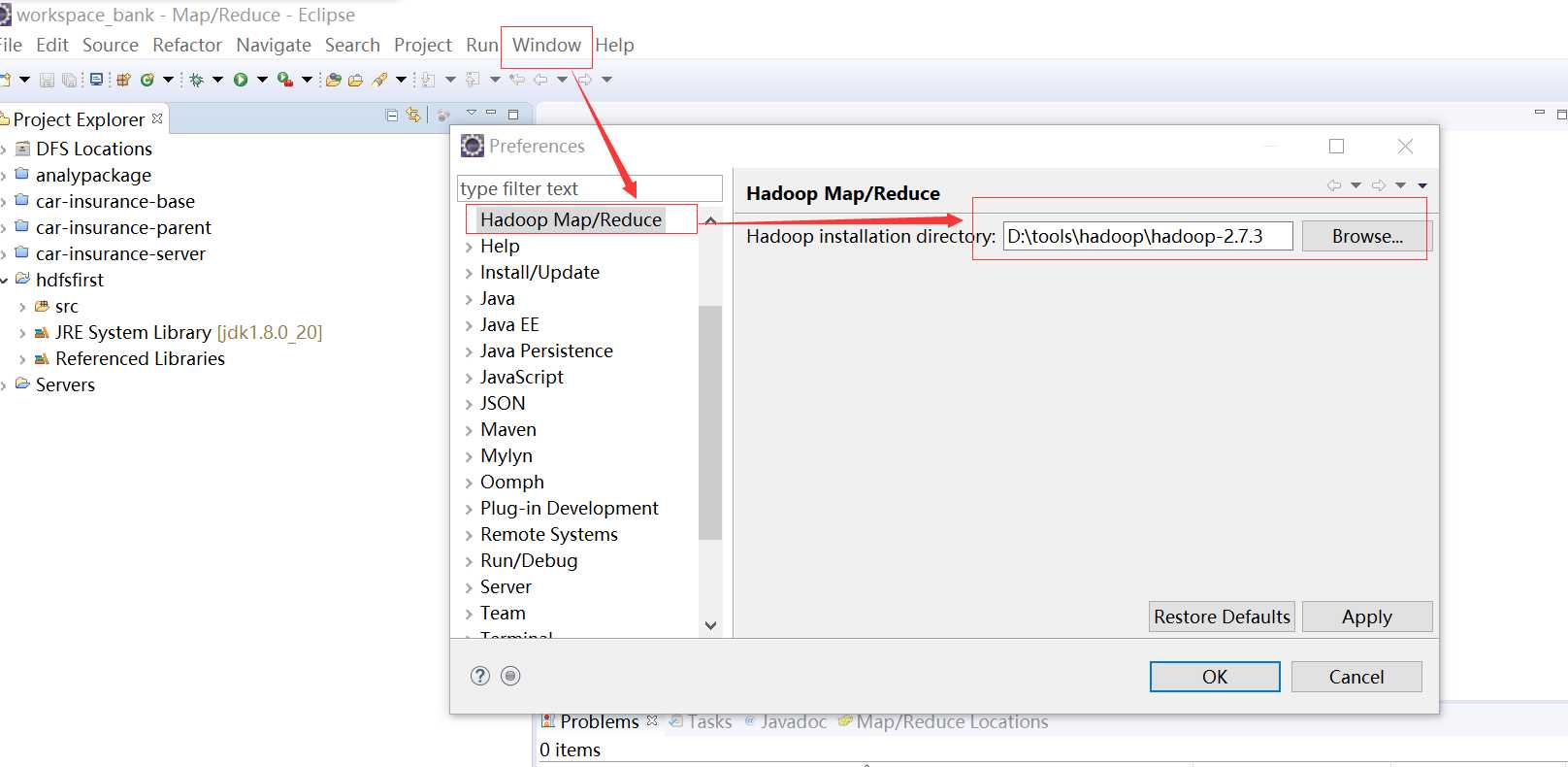

6:在eclipse里面配置hadoop的安装目录

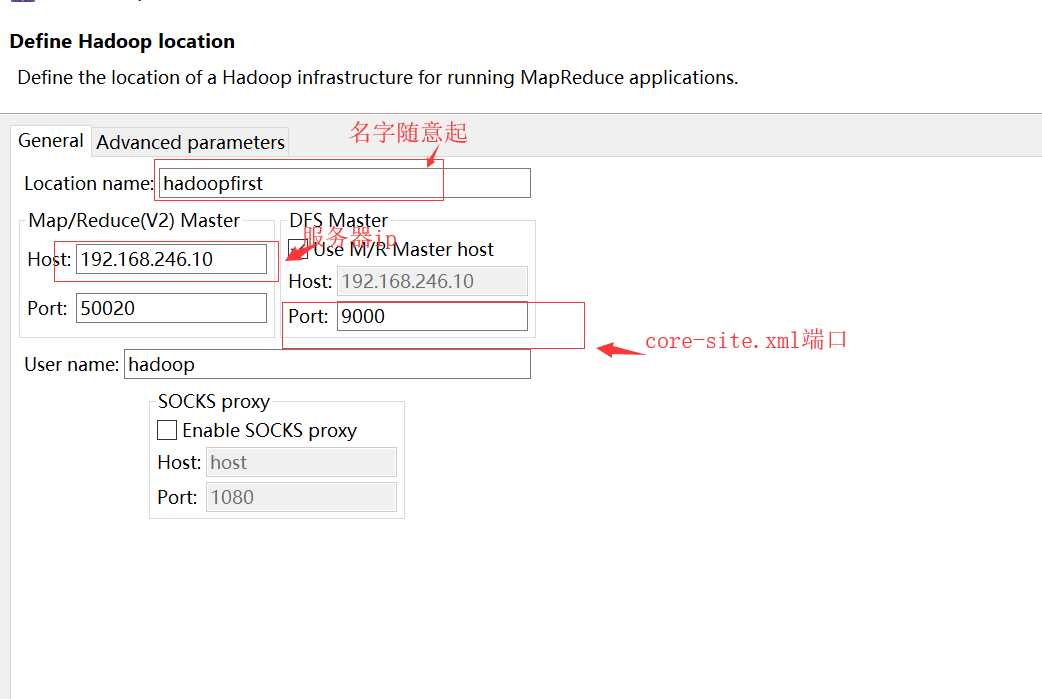

7:配置eclipse的DFS location

window--->> preferences--->> hadoop Map/Reduce

8:配置hadoop集群的信息

hdfs-site.xml

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

1:所需工具

1)hadoop2.7.3安装包

2)hadoop-eclipse-plugin插件

https://github.com/winghc/hadoop2x-eclipse-plugin

原文:https://www.cnblogs.com/zhoufly-blog/p/10067837.html