---恢复内容开始---

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

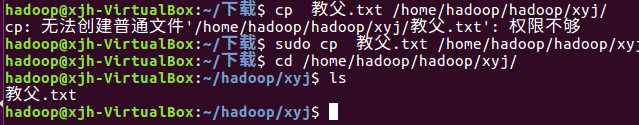

在虚拟机上网下载一个著名的《教父》的英文小说,下载到本地。

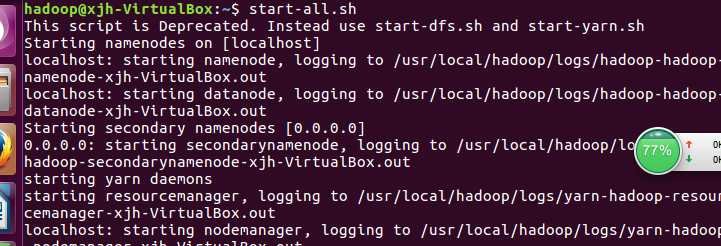

首先要启动dfs:

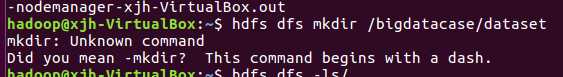

在hdfs上创建文件夹:

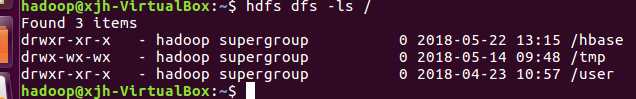

查看hdfs上的所有文件:

把下载的文件上传到hdfs:

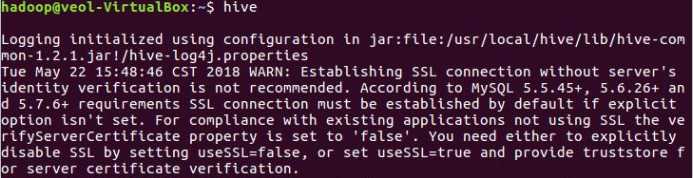

启动hive:

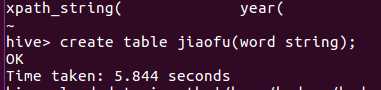

创建表:

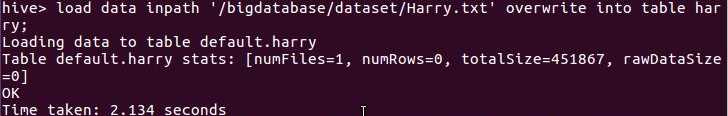

把hdsf上的文件内容添加进去表里:

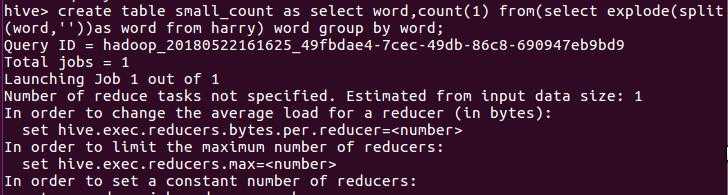

创建一个新的表存放词频统计:

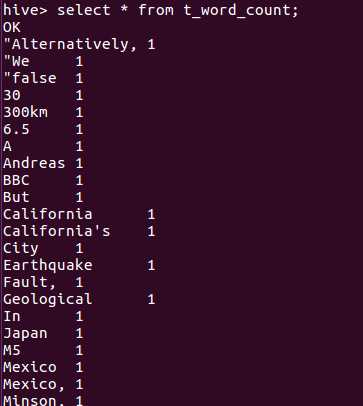

查找表的前十条记录:

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

首先在本地把统计好的词频转化成csv格式

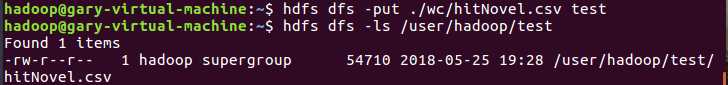

把文件上传到虚拟机

启动hive

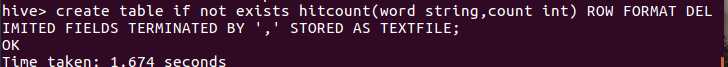

创建表

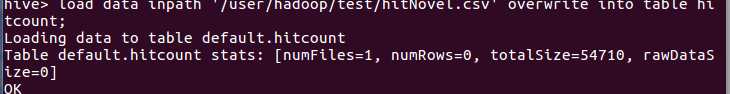

存放到表

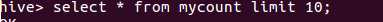

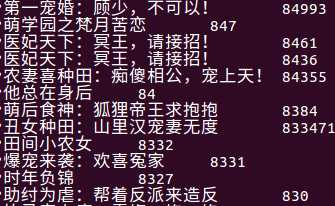

查看前十

分析:说明大家喜欢的小说类型一般主题都是言情,男女之类的小说

原文:https://www.cnblogs.com/a305810827/p/9090849.html