经典网络

- LeNet-5

- AlexNet

- VGG

Ng介绍了上述三个在计算机视觉中的经典网络。网络深度逐渐增加,训练的参数数量也骤增。AlexNet大约6000万参数,VGG大约上亿参数。

- 从中我们可以学习到:

- 随着网络深度增加,模型的效果能够提升。

- 另外,VGG网络虽然很深,但是其结构比较规整。每经过一次池化层(过滤器大小为2,步长为2),图像的长度和宽度折半;每经过一次卷积层,输出数据的channel数量加倍,即卷积层中过滤器(filter)的数量。

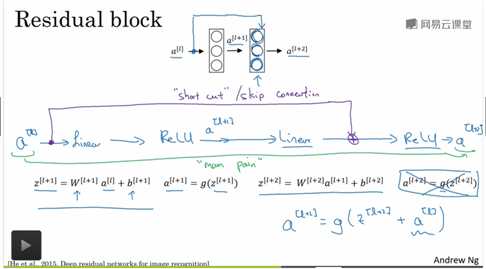

残差网络(ResNet)

由于存在梯度消失与梯度爆炸的现象,很难训练非常深的网络,因此引入了 “skip connections ”的概念,它可以从网络中的某一层获取激活值,并将信息传递给更深一层的网络(将输入流合并,点加),残差块可以训练更深的神经网络。

残差网络的结构如下:

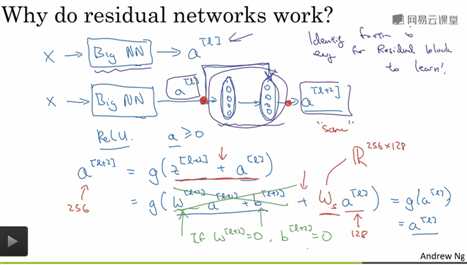

- 更加直观的理解是:

- 残差网络可以尽量避免梯度爆炸或消失的现象;

- 我认为级联相当于对网络加了双层保险,类似于物理中电路的并联,两个输入流只要有一个work,仍能推动网络进行正常的训练。

- 看完上文的描述,可能有人会问,当两个输入流维度不同怎么进行“点加”操作?为了解决上述问题,Ng在课上提到引入一个权重矩阵\(W_s\),课堂笔记如下图所示:

该矩阵可以作为网络的参数进行训练;也可以是一个固定矩阵,对 “skip connections ”的数据进行zero padding,补齐到相同维度。之后将两个相同维度的数据进行”点加“操作。