1.上传

2.解压

3.

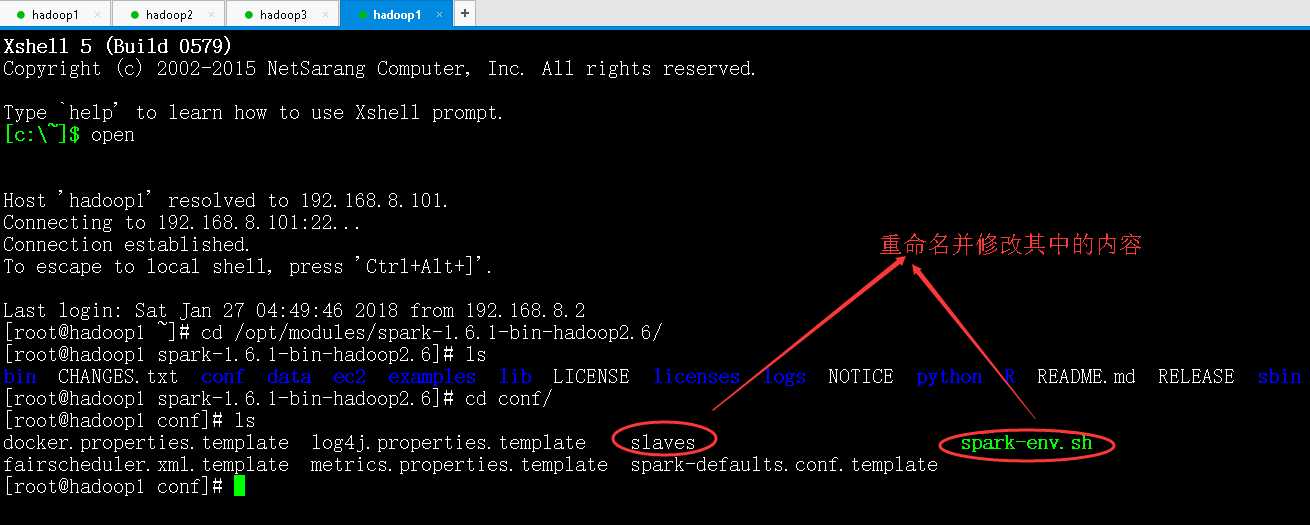

进入到Spark安装目录

cd

进入conf目录并重命名并修改spark-env.sh.template文件

cd conf/

mv spark-env.sh.template spark-env.sh

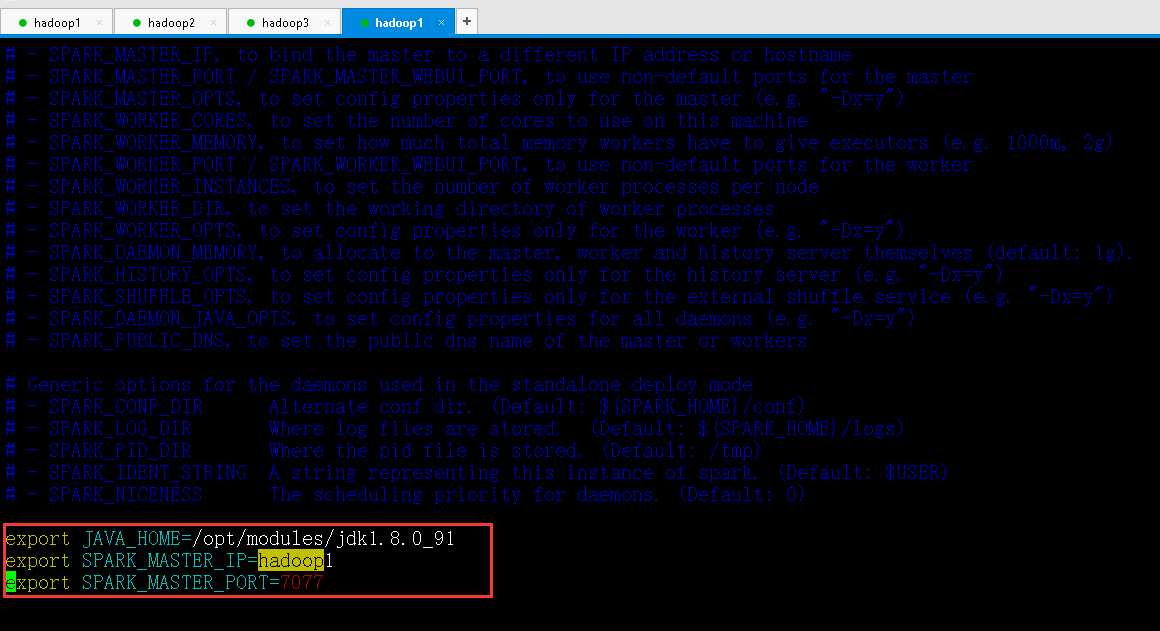

vi spark-env.sh

在该配置文件中添加如下配置

export JAVA_HOME=/opt/modules/jdk1.8.0_91

export SPARK_MASTER_IP=hadoop1

export SPARK_MASTER_PORT=7077

保存退出

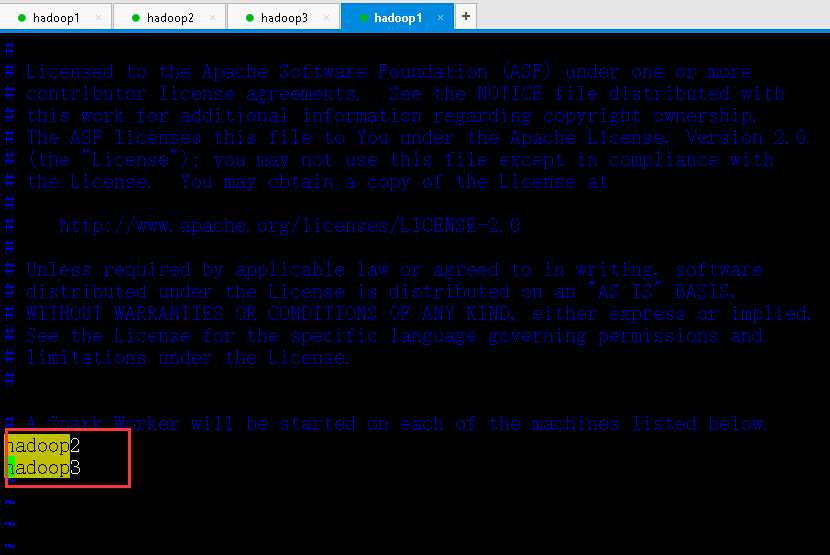

重命名并修改slaves.template文件

mv slaves.template slaves

vi slaves

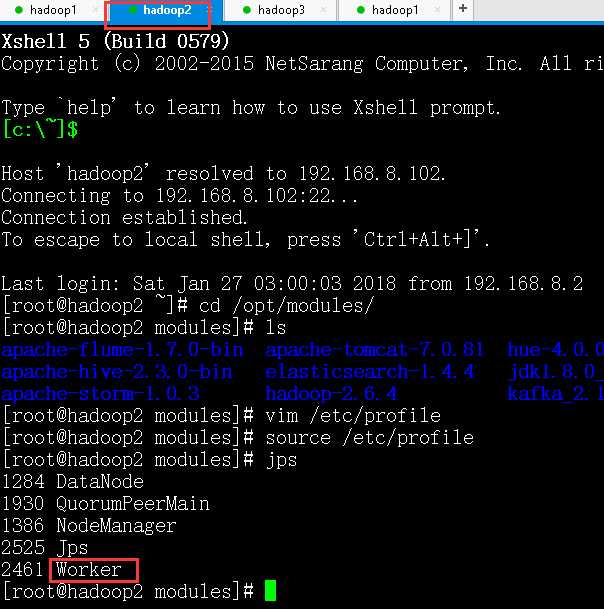

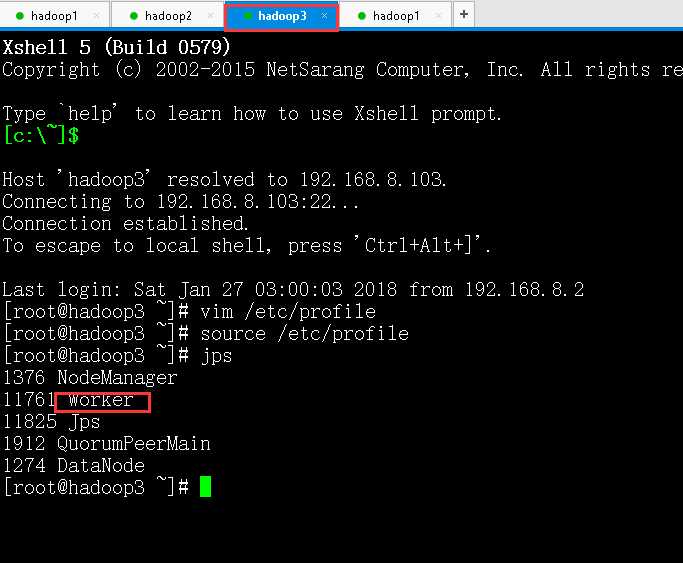

在该文件中添加子节点所在的位置(Worker节点)

hadoop2

hadoop3

保存退出

将配置好的Spark拷贝到其他节点上

scp -r /opt/modules/spark-1.6.1-bin-hadoop2.6/ root@hadoo2:/opt/modules/

scp -r /opt/modules/spark-1.6.1-bin-hadoop2.6/ root@hadoo3:/opt/modules/

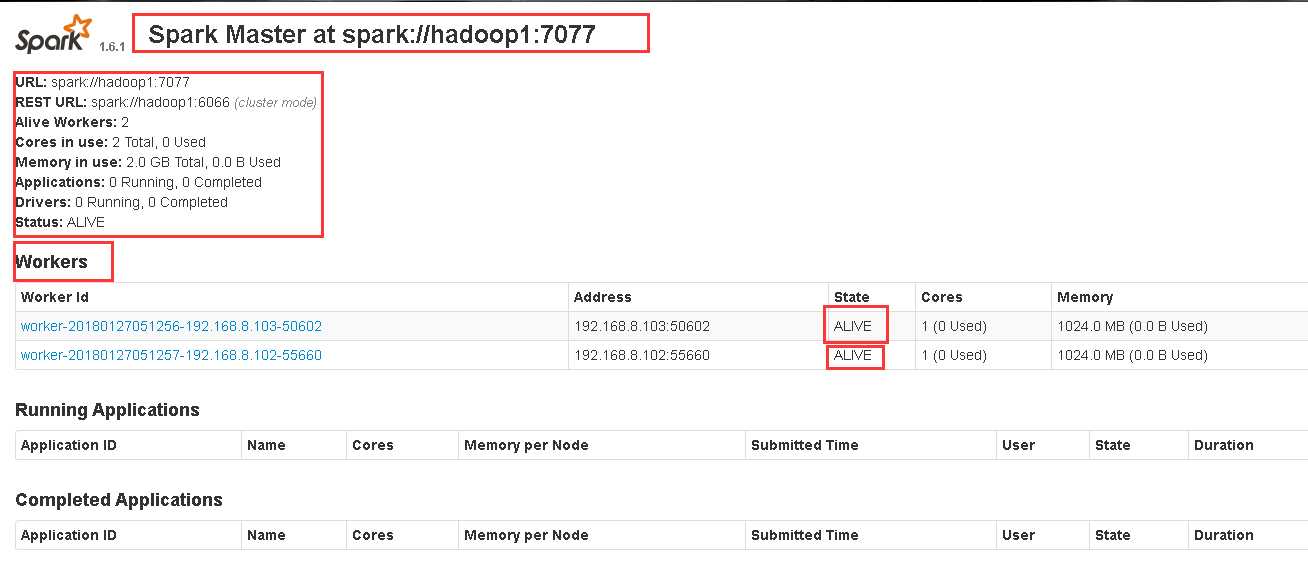

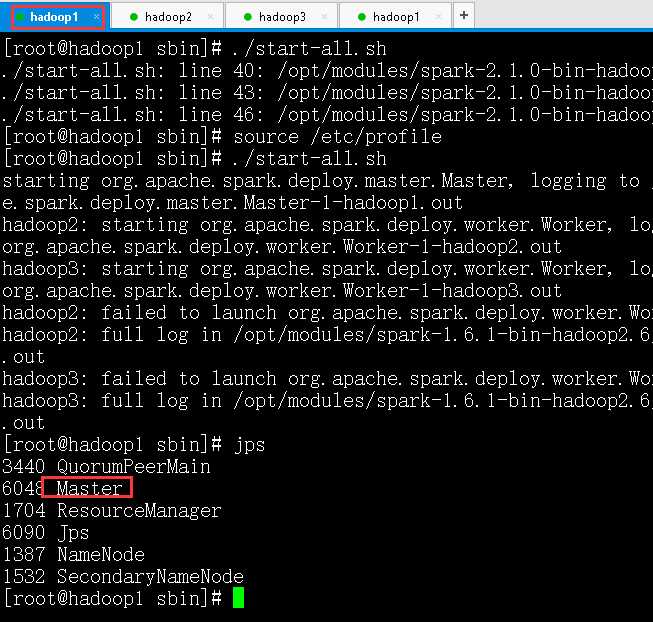

Spark集群配置完毕,目前是1个Master,2个Work,在hadoop1上启动Spark集群

./sbin/start-all.sh

在网站输入hadoop1:8080