2.1 输入和输出的不同叫法: input/predictor/feature/independent variable output/response/dependent variable

2.2 对于分类,输出变量是Qualitative variables/categorical variable/discrete variable/factor,多类时用K维向量(每一维是二元的)表示,dummy variable,Y

对于回归,输出变量是quantitative output, G

这两类都可以看成函数逼近问题

第三类变量是ordered categorical(比如 small,medium和large),在Chp4会讨论。

矩阵X,每行代表一个样本的所有变量值,每列代表所有样本在某个变量上的取值。

2.3 两种简单的预测方法:least squares 和 nearest neighbors

由最小二乘拟合的线性模型:对结构有很多假设,产生稳定但可能不准确的预测;k-nearest neighbors有very mild structural assumption,预测经常准确但可能不稳定。

线性模型的截距:intercept/bias

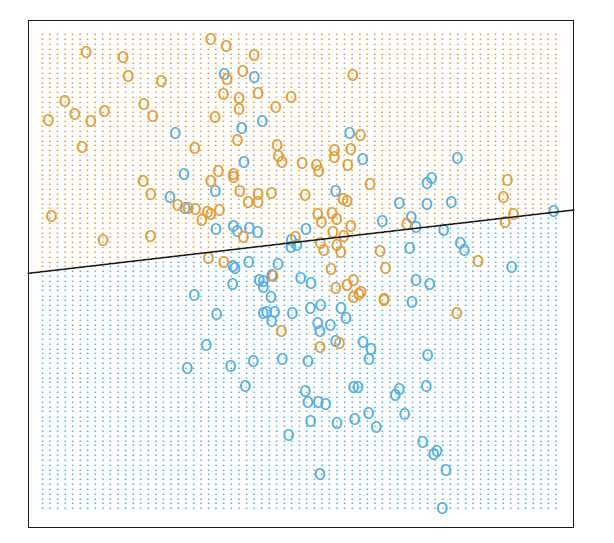

例子:用线性回归来解决0/1分类问题。

情形1. 每类的训练数据由参二元高斯分布产生,两种二元分布有uncorrelated components 和不同的均值,此时区域的重合不可避免,线性决策边界最优。low variance

可能 high bias

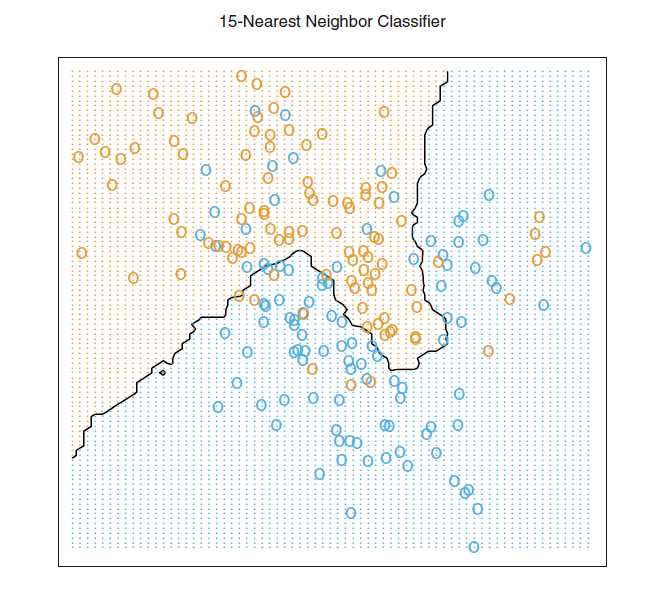

情形2. 每类数据由 10个低方差高斯分布的mixture产生,各自的均值服从高斯分布,此时线性边界不是最优,有更好的办法,KNN对这种情形很有用(15-NN,最近邻,

voronoi tessellation),K-NN的的有效参数是N/k,一般大于p。high variance,low bias

例子数据的生成方式:~~

这两种简单模型的扩展产生了许多现在流行的技巧——kernel method(用连续减小到0的weight)、高维空间中的distance kernel、 local regression、线性回归扩展允许任意复杂的模型 、projection pursuit and neural network。kernel method 与local/optimal bayesian error regression区别,允许任意复杂的模型什么意思

2.4 统计决策理论(statistical decision theory)

最小二乘假设f(x)被一个全局线性函数近似;而KNN假设其被一个局部常数的函数较好地近似。

对于分类问题,Bayes calssifier,贝叶斯分类器的误差率称为 Bayes rate

《The Elements of Statistical Learning》 chp2 Overview of Supervised Learning

原文:http://www.cnblogs.com/terryhaha/p/6710842.html