课程主页:http://cs231n.stanford.edu/

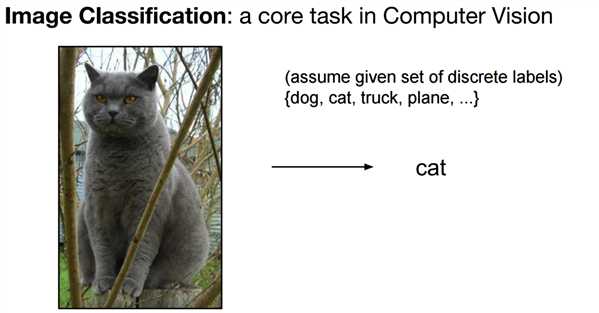

Task:

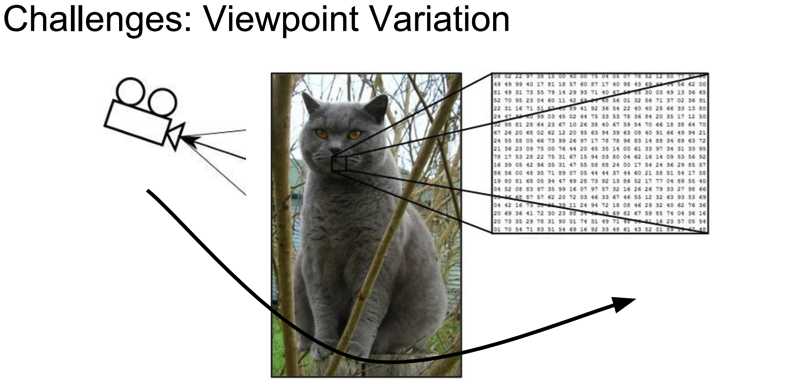

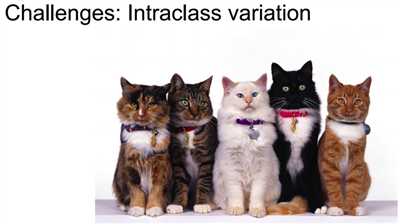

Challenges:

____________________________________________________________________________________________________________________________________________________________________________________

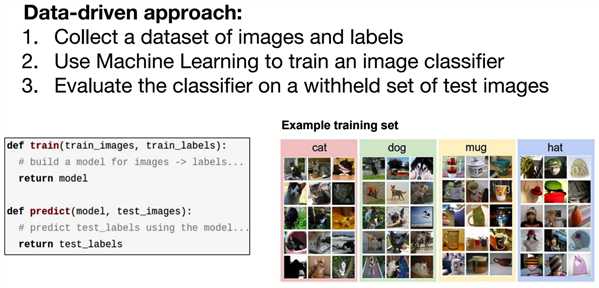

Data-driven approach:

____________________________________________________________________________________________________________________________________________________________________________________

-采用最简单的分类器:knn

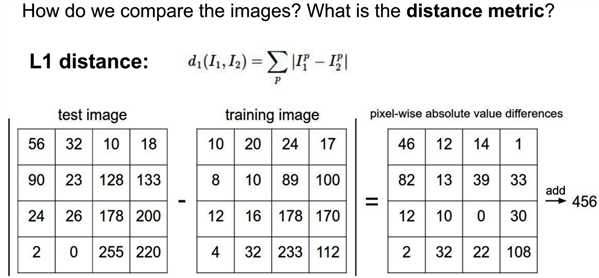

*distance的定义:

当然,这里才用的L1 (Manhattan) distance,当然也可以采用 L2 (Euclidean) distance。

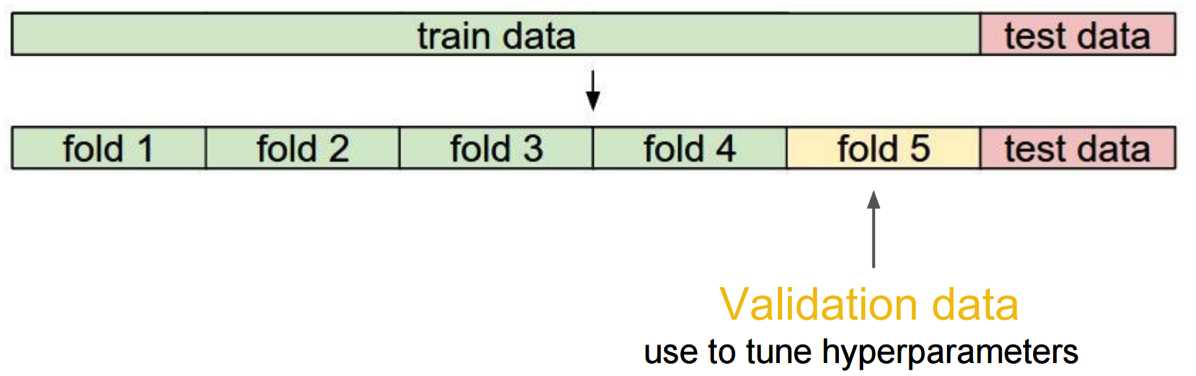

*如何确定k的值?

将数据分为6份,其中1份作为测试集。剩下的5份中,4份作为训练集,1份作为评估集(用以得到最佳的k值)[5折交叉验证]。

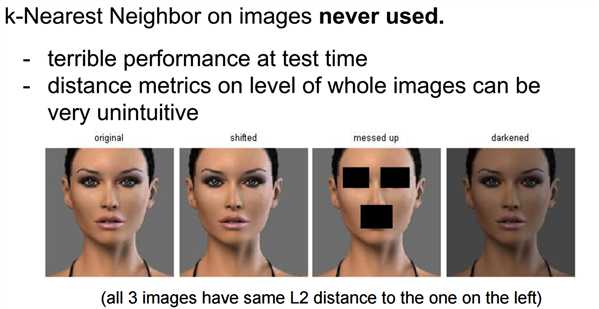

-缺陷:

____________________________________________________________________________________________________________________________________________________________________________________

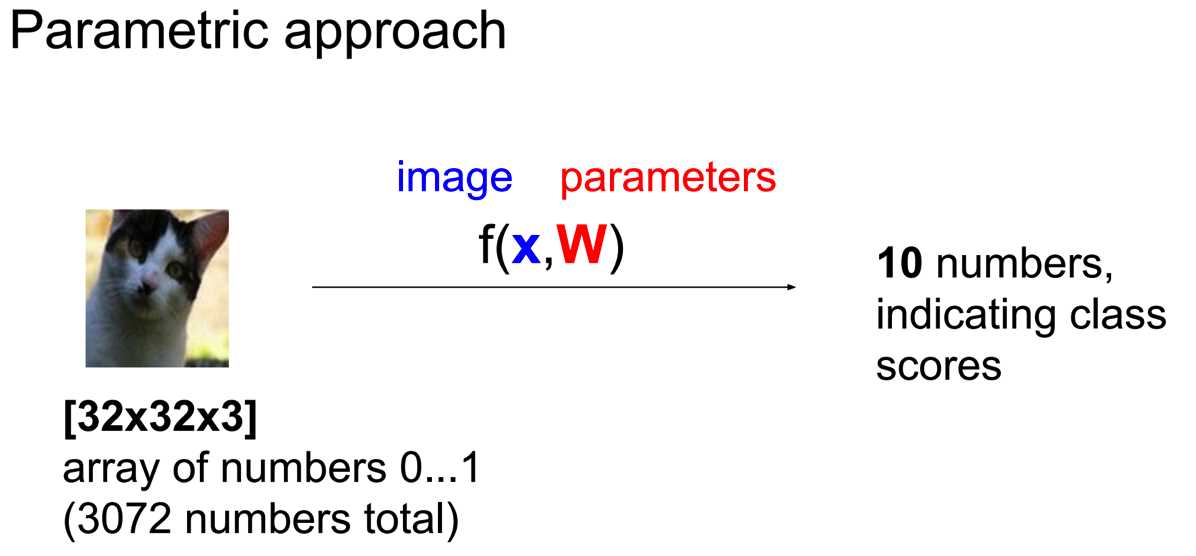

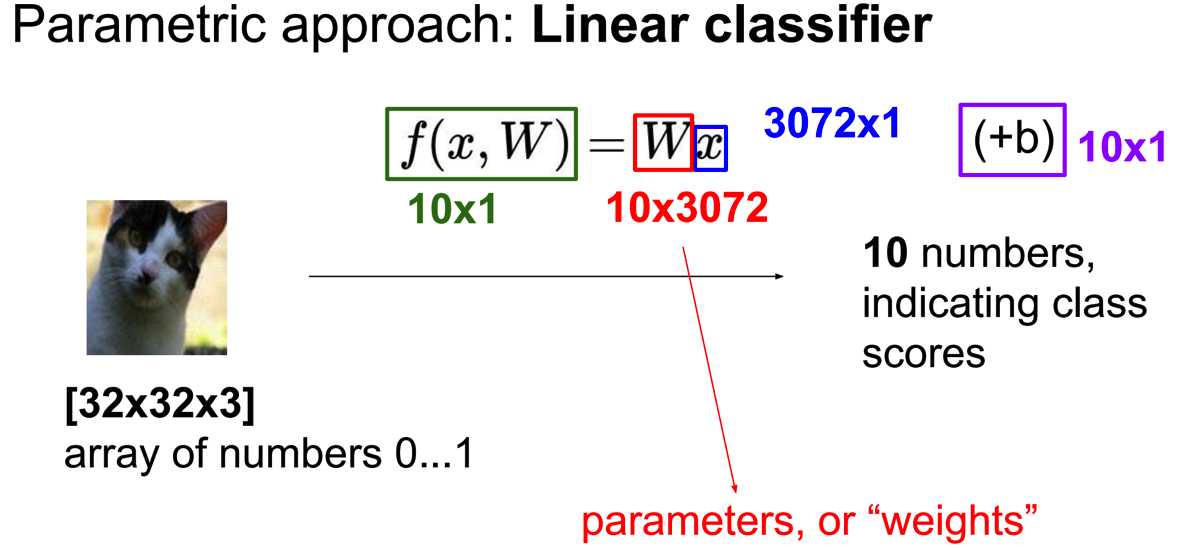

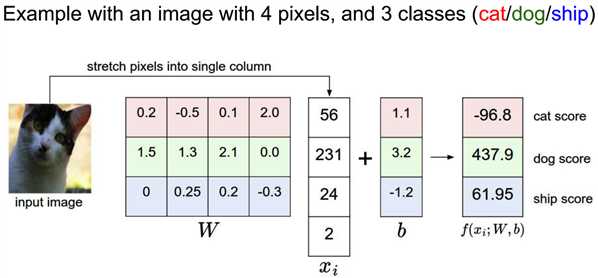

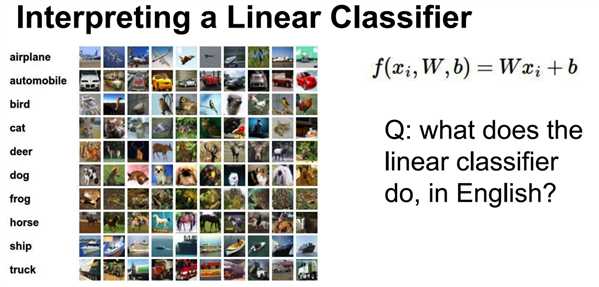

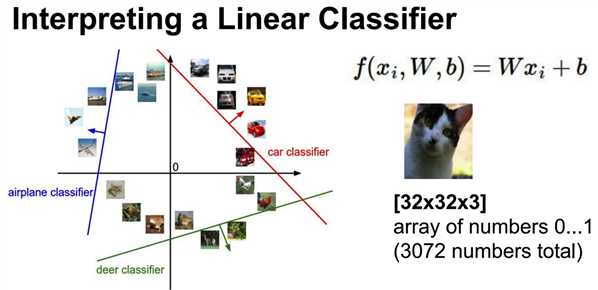

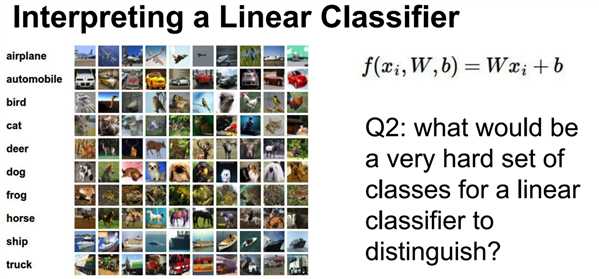

-采用线性分类器:Linear Classification

输入一个image和若干个参数(每一类都会有一组属于自己的参数即w和b),返回这个image属于每一类的score。

我们希望的是:如果一张图是猫,那么将这张图输入到cat()里面算出来score应该为最高,其他的类别都很低。

*缺陷:

如果是grey picture的话,效果会很差。

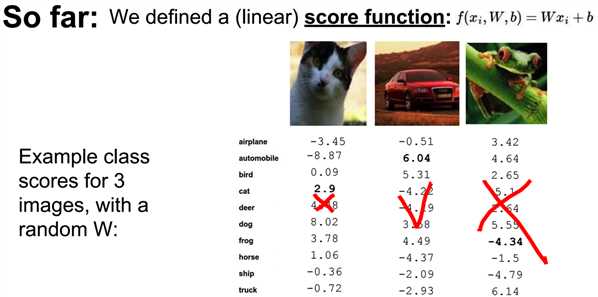

从这个实验我们以发现,

第一张图,实际是一只猫,但是算出它是猫的score一般,所以我们认为对于这张图而言,w并不理想。

第二张图,实际是一辆车,算出它是车的score最高,所以我们认为对于这张图而言,w很理想。

第三张图,实际是一只青蛙,算出它是青蛙的score相对很低,所以我们认为对于这张图而言,w很不理想。

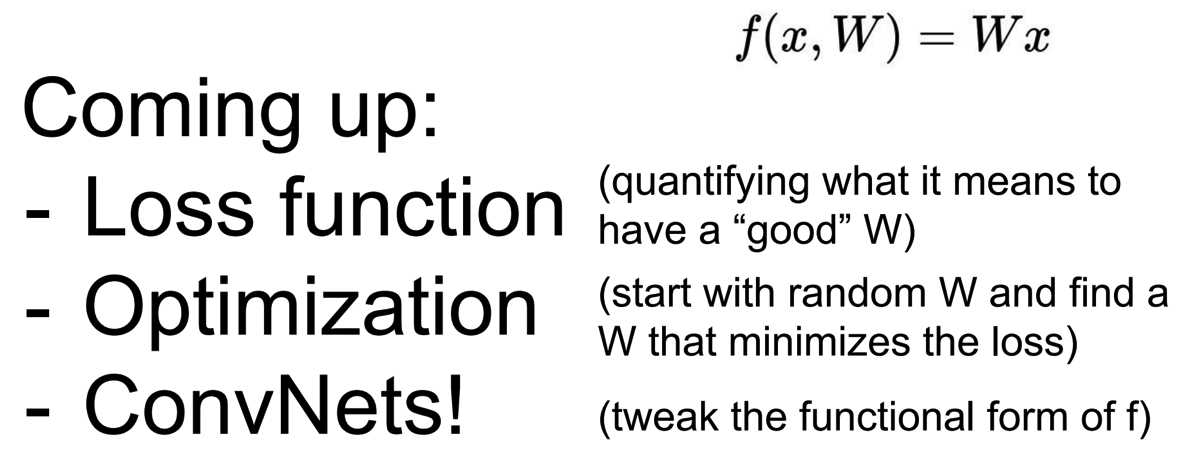

*引出loss function,用于量化结果是否理想(程度)。

好处:如果你的loss function的值很高,说明w不理想,所以需要调整。通过这种方式,可以帮助我们找到一组w,能够对于test dataset中的每一张照片都有一个相对理想的结果。

原文:http://www.cnblogs.com/XBWer/p/5326220.html