CDH对我们已经封装了,我们如果需要Spark on Yarn,只需要yum安装几个包就可以了。

如果没有内网Yarn服务器的,请使用Cloudera的yum服务器。

开始安装(所有的从节点)

yum install -y spark-core spark-python

是不是很简单?

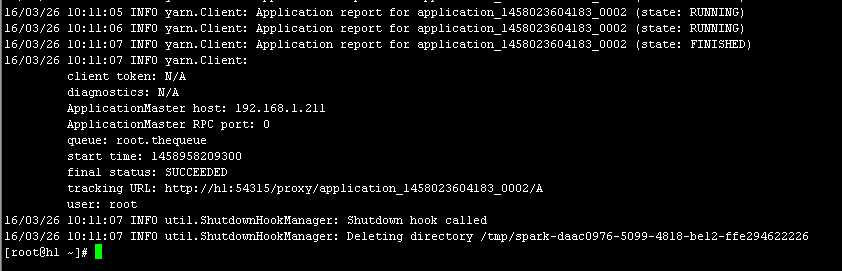

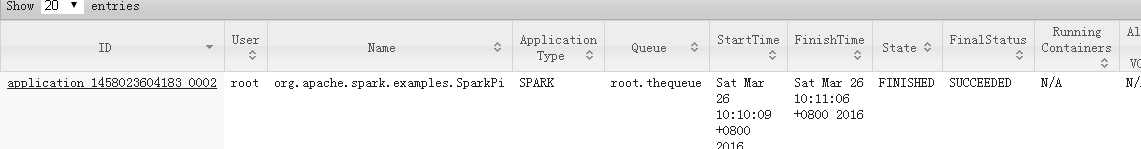

测试:

spark-submit --class org.apache.spark.examples.SparkPi --master yarn --deploy-mode cluster --driver-memory 4g --executor-memory 2g --executor-cores 2--queue thequeue /usr/lib/spark/lib/spark-examples.jar 2

CDH5.5.1 安装Spark ON Yarn环境

原文:http://www.cnblogs.com/luguoyuanf/p/a3316e187d4a9e2c54836317a4fceab8.html